简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

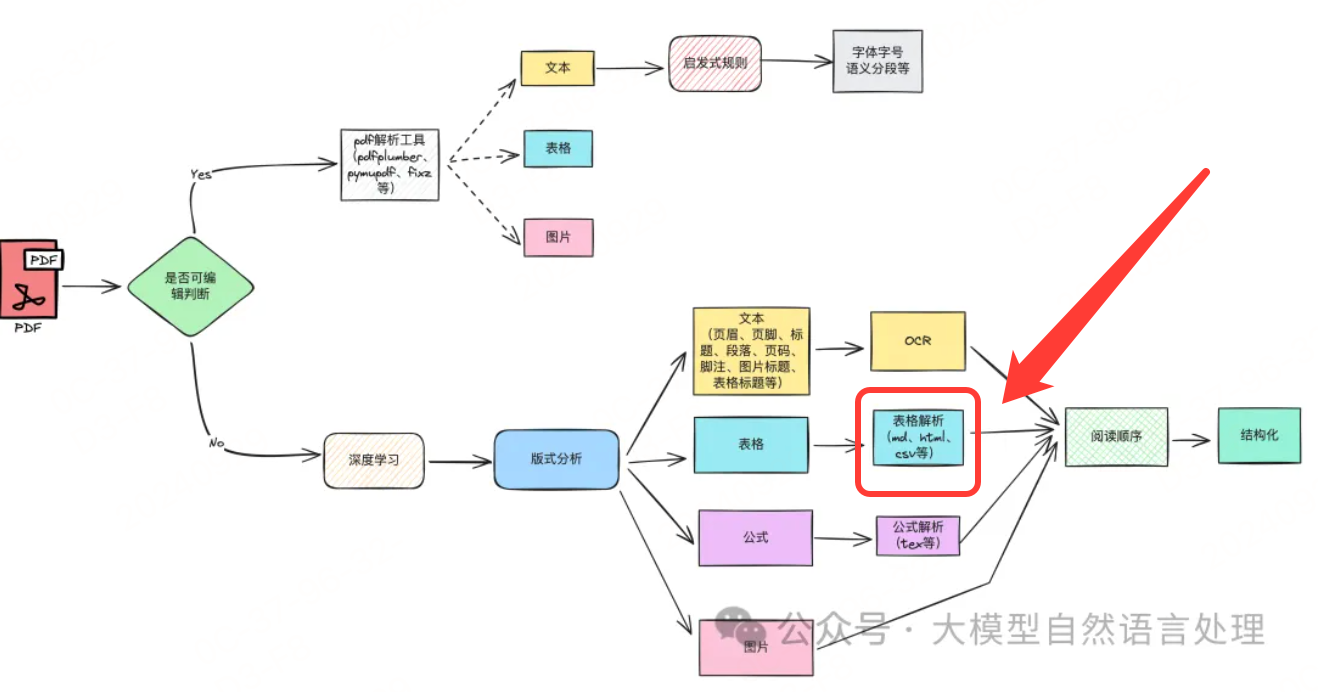

训练数据质量大于一切,含大量数据的超长文本表格目前还不能准确识别,因为笔者训练的是。作为文档智能的重要组成部分,面临着复杂结构和多样化格式的挑战。前期文章也介绍了传统视觉的方法进行表格结构识别的方法,国庆期间,笔者利用一个较长的时间段,训练了一个。模型,效果还不错,特此记录一下多模态的效果。下面的一些case来源于网络的表格截图。关于表格识别在这里就不做过多的介绍了。模型参数量目前较大,推理速度比

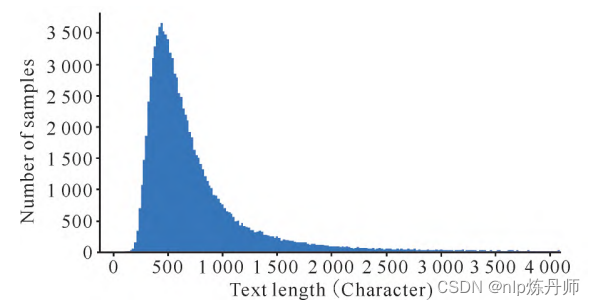

本文将回顾第四届“中国法研杯”司法人工智能挑战赛-刑期预测算法赛道比赛。使用多任务预训练、然后进行微调的形式最终在比赛中取得了三等奖的成绩。

可以看到paddleocr输出logging主要有两种,DEBUG和WARNING,因此关闭这两种打印日志即可。

PIKE-RAG框架的设计目标是提供一个灵活且可扩展的RAG系统,应对工业应用中复杂多样的任务需求。框架的核心是通过有效的知识提取、理解和组织,以及构建连贯的推理逻辑,解决了RAG系统在工业应用中的局限性。下面来看下PIKE-RAG框架及其实现过程,供参考。

Phi-4-Multimodal 是一种参数高效的多模态模型,通过 LoRA 适配器和模式特定路由器实现文本、视觉和语音/音频的无缝集成。训练过程包括多阶段优化,确保在不同模式和任务上的性能,数据来源多样,覆盖高质量网络和合成数据。它的设计体现了小型语言模型在多模态任务上的潜力。

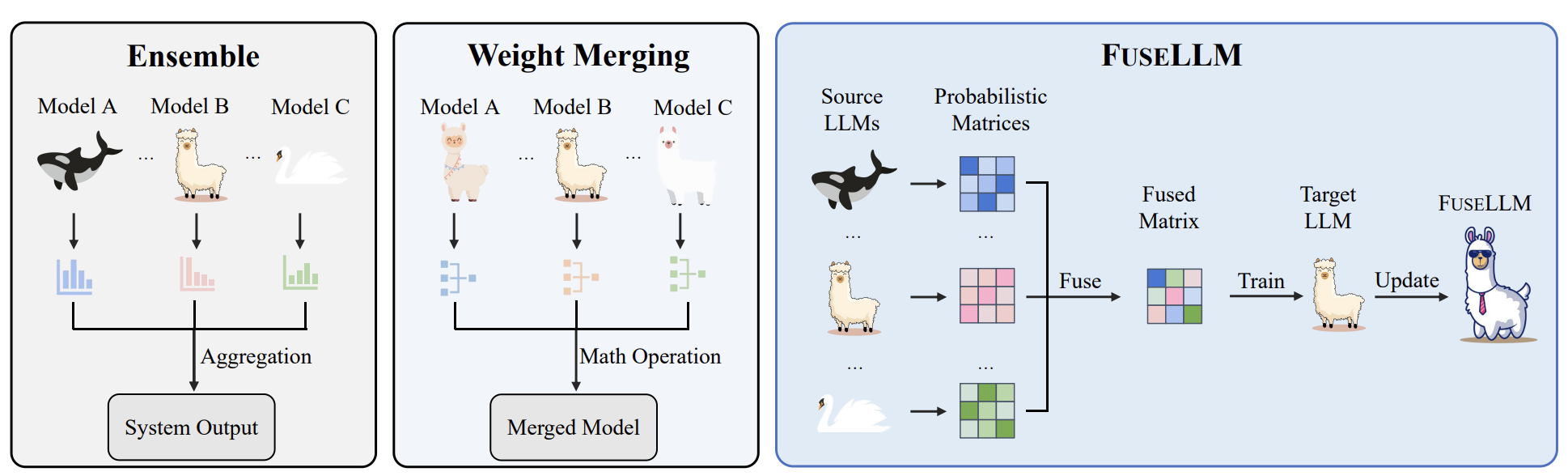

传统的模型融合方法分为集成的方法和权重合并的方法,这两种方法在以往的NLP的比赛中非常常见,是一种提分手段。然而,上述两种方法都需要预训练或者微调相应的模型。在大模型场景下,对每个源模型都进行初始化成本太高,为了减少初始化源LLM的成本,使集成后的模型受益于所有源LLMs的优势。因此,本文介绍了一种知识融合的方法用来进行大模型的融合。FUSELLM提供了一种LLMs的集成方法,为大模型融合提供了一

刚开始琢磨使用DeepSeek-R1风格训练多模态R1模型,就看到这个工作,本文一起看看,供参考。先提出问题,仅靠 RL 是否足以激励 MLLM 的推理能力?结论:不能,。:从未经专门推理优化的原始 MLLM(例如 Qwen-2.5VL-7B-Instruct)开始,直接应用 RL 训练。使用与 Vision-R1 相同的奖励函数,即硬格式结果奖励函数(HFRRF):如果输出格式正确且答案正确,奖

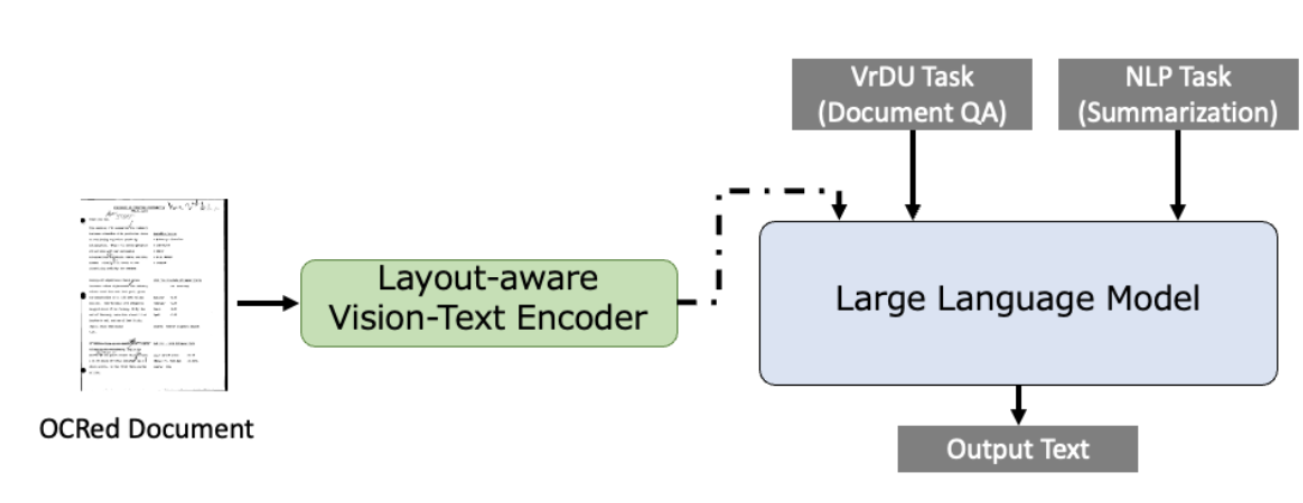

传统的文档理解任务,通常的做法是先经过预训练,然后微调相应的下游任务及数据集,如文档图像分类和信息提取等,通过结合图像、文本和布局结构的预训练知识来增强文档理解。LayoutLLM是一种结合了大模型和视觉文档理解技术的单模型方法,通过多模态指令数据集的微调来提高对图像文档的理解和分析能力。本文介绍了一种传统布局模型结合大模型做文档理解的方法:LayoutLLM。这个框架通过结合VrDU编码器来捕捉

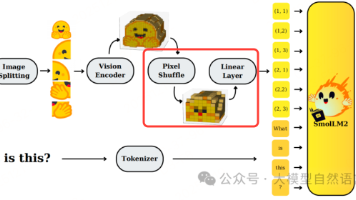

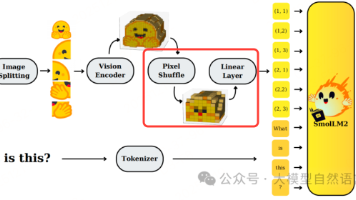

标题一次,非Qwen3-VL-0.6B官方。最近手里有一台昇腾910B的服务器,顺便摸索下国产芯片的训练都有哪些坑,笔者时隔一年对Reyes《》进行了改造,原本的Reyes由8B的参数构成(InternViT-300M-448px-V2_5+Qwen2.5-7B-Instruct),随着端侧模型的发展与手里资源的限制,最终笔者将Reyes参数量设置成0.6B,训练了一个轻量化的多模态模型,最终在M

标题一次,非Qwen3-VL-0.6B官方。最近手里有一台昇腾910B的服务器,顺便摸索下国产芯片的训练都有哪些坑,笔者时隔一年对Reyes《》进行了改造,原本的Reyes由8B的参数构成(InternViT-300M-448px-V2_5+Qwen2.5-7B-Instruct),随着端侧模型的发展与手里资源的限制,最终笔者将Reyes参数量设置成0.6B,训练了一个轻量化的多模态模型,最终在M