简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要: 本文介绍了如何基于Model Context Protocol (MCP) 构建AI应用,实现LLM与外部数据源的标准化交互。首先配置云端容器环境并部署vLLM服务(Qwen2.5-72B模型),接着通过fastmcp库将模拟的金融数据(CSV格式)封装为MCP工具。最后在Dify平台集成该工具,形成完整工作流,使LLM能够按需查询金融数据并以Markdown表格返回结果。实验展示了MCP

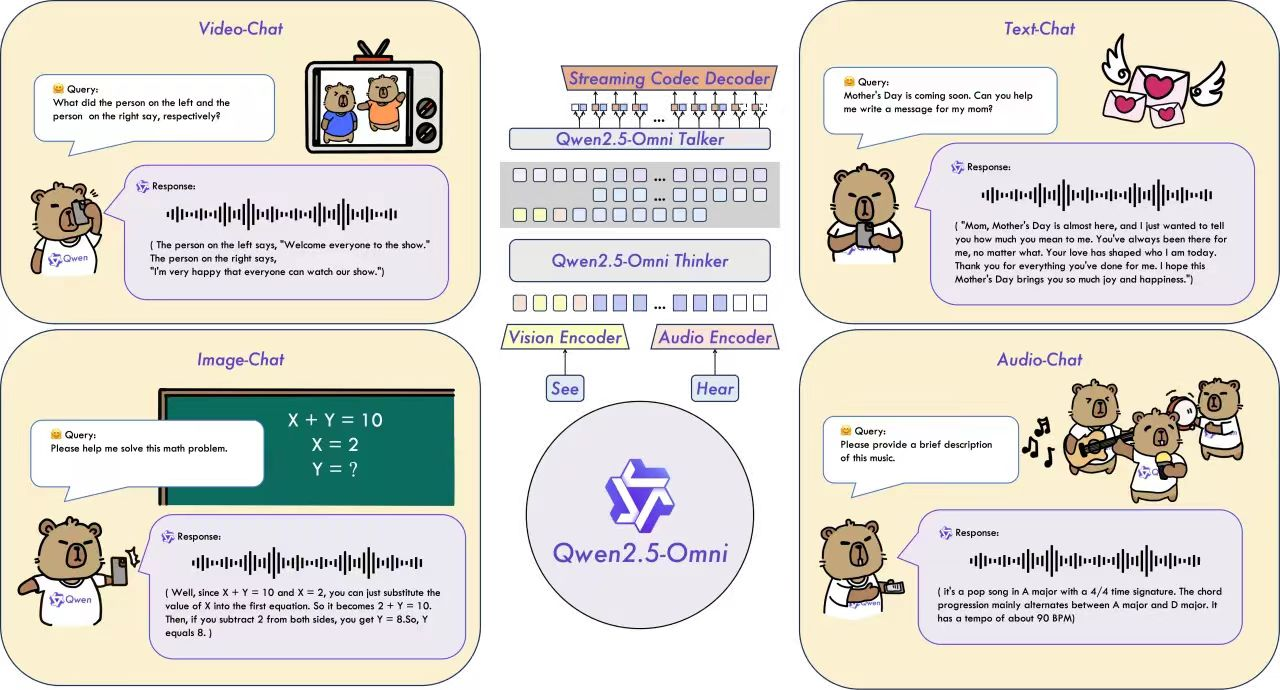

OpenAI 发布 GPT-4V 与 Gemini 1.5-Pro,Google DeepMind 推出 Flamingo 和 Gemini 系列,多模态技术逐渐成为 AI 实用化的关键路径。但多模态大模型往往意味着参数暴增、推理开销剧增、无法实时响应等现实问题。如何构建“轻量化、全模态、强泛化、可部署”的 AI 系统。在这样的背景下,阿里通义团队开源发布的 Qwen2.5-Omni-7B,无疑是

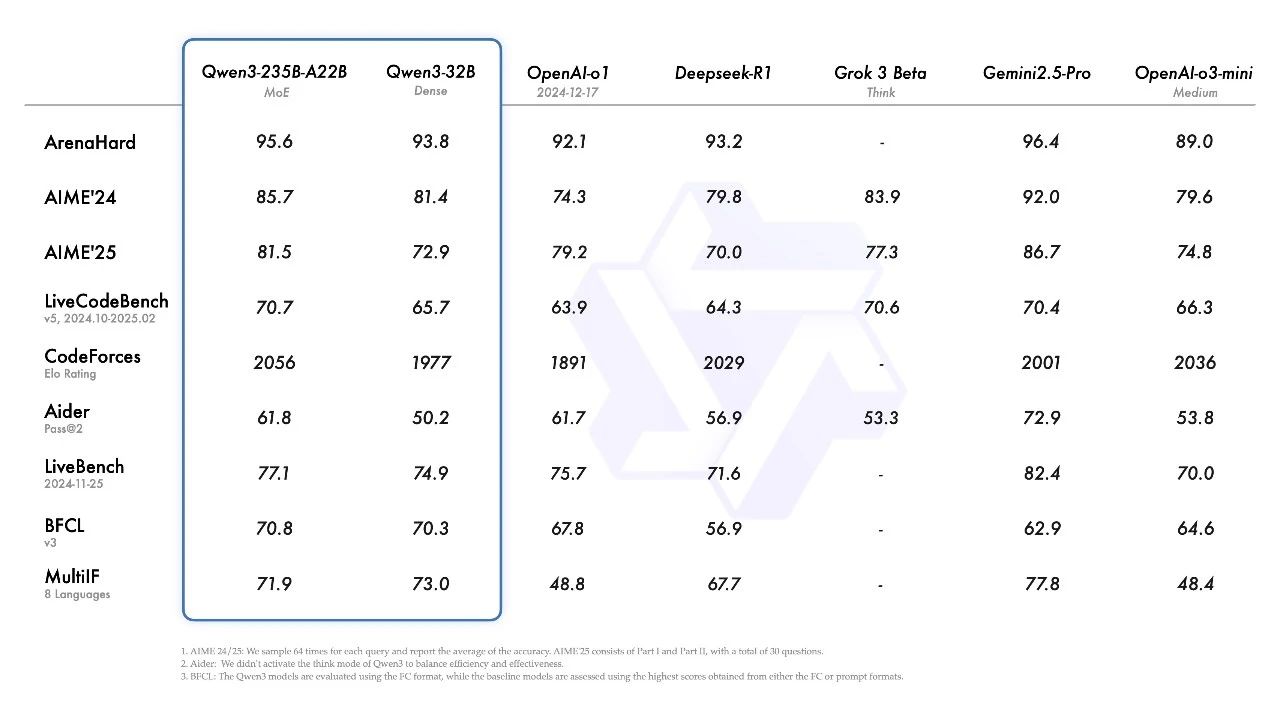

Qwen 系列大型语言模型的最新成员。我们的旗舰模型 Qwen3-235B-A22B 在代码、数学、通用能力等基准测试中,与 DeepSeek-R1、o1、o3-mini、Grok-3 和 Gemini-2.5-Pro 等顶级模型相比,表现出极具竞争力的结果。此外,小型 MoE 模型 Qwen3-30B-A3B 的激活参数数量是 QwQ-32B 的 10%,表现更胜一筹,甚至像 Qwen3-4B

本章节将使用xinference启动 LLM+检索模型服务,然后使用Langchain-chatchat接收模型服务api,并录入知识库,实现本地知识库部署。

在本章我们将从获取算力卷创建自己的云平台账号开始,一步一步的带着大家从0到1完成,从创建云平台环境选择镜像,选择SDK版本,到SSH登录云平台环境,更改github原版yolov5 v5.0代码实现mlu370训练和推理,同时在最后总结出部分QA为各位开发者提供快速支持。

DeepSeek-R1拥有卓越的性能,在数学、代码和推理任务上可与OpenAI o1媲美。其采用的大规模强化学习技术,仅需少量标注数据即可显著提升模型性能,为大模型训练提供了新思路。此外,DeepSeek-R1构建了智能训练场,通过动态生成题目和实时验证解题过程等方式,提升模型推理能力。该模型完全开源,采用MIT许可协议,并开源了多个小型模型,进一步降低了AI应用门槛,赋能开源社区发展。

opencv-cuda编译 or 问题解决处理装前温馨提示一、常规安装流程1.ffmpeg安装1.常规依赖项安装2.下载ffmpeg3.安装nv-codec-headers4.编译5.配置环境变量6.ffmpeg说明2、opencv-cuda编译1.常规依赖项安装2.下载opencv所需相关文件及编译方式3.开始编译4.编译自查是否成功(看config)4.1查看ffmpeg是否编译成功4.2查看

opencv-cuda编译 or 问题解决处理装前温馨提示一、常规安装流程1.ffmpeg安装1.常规依赖项安装2.下载ffmpeg3.安装nv-codec-headers4.编译5.配置环境变量6.ffmpeg说明2、opencv-cuda编译1.常规依赖项安装2.下载opencv所需相关文件及编译方式3.开始编译4.编译自查是否成功(看config)4.1查看ffmpeg是否编译成功4.2查看

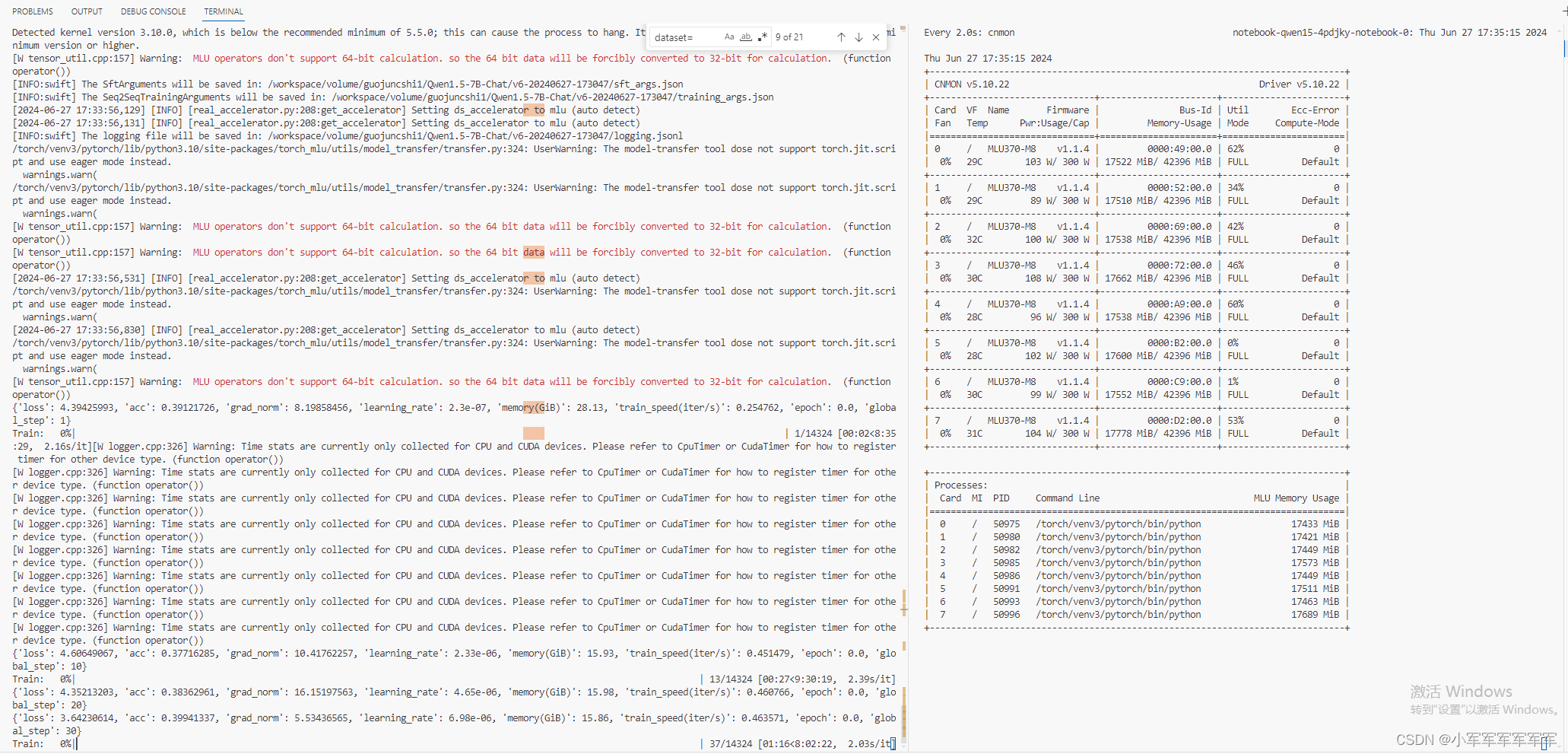

本期我们采用魔塔的swift来完成qwen1.5-7b-chat的训练,除一些环境安装需要转换,其他的与N卡训练操作一致。

更强大的性能:基于 ChatGLM 初代模型的开发经验,我们全面升级了 ChatGLM2-6B 的基座模型。ChatGLM2-6B 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识符的预训练与人类偏好对齐训练,评测结果显示,相比于初代模型,ChatGLM2-6B 在 MMLU(+23%)、CEval(+33%)、GSM8K(+571%) 、BBH(+60%)等数据集上的性能取得了大幅度的