简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

AI赋能安全运营中心(ISOC)正加速安全运营智能化转型。文章从六个维度展开:风险识别(资产管理、风险评估、漏洞管理)、威胁检测(高级威胁识别、告警降噪、情报分析)、事件响应(自动化处置、智能决策)、运营管理(模拟演练、数据安全、合规评估)、知识问答(专家辅助)。通过机器学习、知识图谱、NLP等技术,ISOC实现了从被动防御到主动管理的转变,显著提升威胁检测准确率(降低误报漏报)、响应效率(缩短M

随着大模型的迅猛发展,各种新的AI工具也在不断涌现,当下代表性的 MCP(Model Context Protocol)标准实现的工具正逐渐成为连接大语言模型(LLM)与外部工具、数据源之间的桥梁,但MCP 的快速普及也带来了新的安全挑战。

摘要:大模型引入慢思考模式可提升复杂任务处理质量,通过逐步推理减少错误,但存在计算成本高、过度规划等问题。慢思考虽能增强过程可追溯性,但无法完全解决模型黑箱性,可能将简单错误转化为系统性偏差。研究表明合理控制推理深度能在成本与效果间取得平衡,但过度依赖内部推理会降低对环境反馈的敏感性。

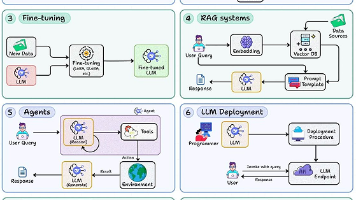

构建可落地的LLM应用需要系统化工程方法,而非仅依赖提示词优化。文章提出8大核心技能:1)结构化提示工程;2)上下文管理;3)模型微调;4)RAG系统构建;5)智能体设计;6)高性能部署;7)模型优化;8)全链路观测。这些能力覆盖从交互设计到系统实现再到运维优化的完整生命周期,强调标准化、可观测和成本控制,将演示级应用转化为可应对真实流量的生产级系统。建议从基础交互层入手,逐步构建完整技术栈,最终

在将大型语言模型应用于特定领域或任务时,需要帮助模型快速适应新的需求。

论文展示了通过大规模强化学习(RL)可以显著提升模型的推理能力,即使不使用监督微调(SFT)作为冷启动。进一步地,加入少量冷启动数据可以进一步提升性能。DeepSeek-R1-Zero:纯强化学习直接在基础模型上应用强化学习,不使用任何 SFT 数据。探索 LLM 在纯 RL 环境下的自演化过程,使其自主发展推理能力。DeepSeek-R1:冷启动 + 多阶段训练使用少量高质量的 CoT 数据进行

网络安全 L3 级安全大模型的主要技术难点和突破路径。

摘要:吴军老师提出ChatGPT的边界本质是数学边界。哥德尔不完备定理证明数学无法同时满足完备性和一致性;马季亚谢维奇证实部分数学问题无法判定解的存在性;图灵则划定了可计算问题的边界。这些理论共同构成了AI的三大硬性边界:逻辑完备性、可计算性和确定性边界。虽然量子计算等新技术可能扩展AI能力范围,但在现有计算框架下,数学边界仍是无法突破的绝对限制。(149字)

如果追求极致的推理能力,用于复杂的科研项目或大型企业的关键业务,32B或70B版本可能更适合。

AI与网络安全融合为从业者带来新机遇。本文为网络安全人员提供AI转型框架,分析两大方向(AI赋能安全和AI系统安全),规划转型路径与技能清单,推荐定制化学习方案和实战项目,并指出常见误区。建议从业者明确方向、制定计划、积累成果、持续学习,掌握AI开发等核心技能,实现从传统安全到智能防护的成功转型,在AI时代获得竞争优势。文中强调技术与业务结合的重要性,并提供实用资源与学习建议。