简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

现在,让我们对数据集的一个子集进行此操作,以用作我们的训练数据。随着训练集大小的增加,您应该看到性能继续呈线性扩展,但您的作业也将需要更长时间。与经典的“微调”类似,您只需使用您的新微调模型名称填充“model”参数,调用“ChatCompletions”即可。在构建训练样本时,请考虑到这一点——如果您的模型将在多轮对话中发挥作用,请提供代表性的例子,以免在对话开始扩展时表现不佳。现在我们可以使用

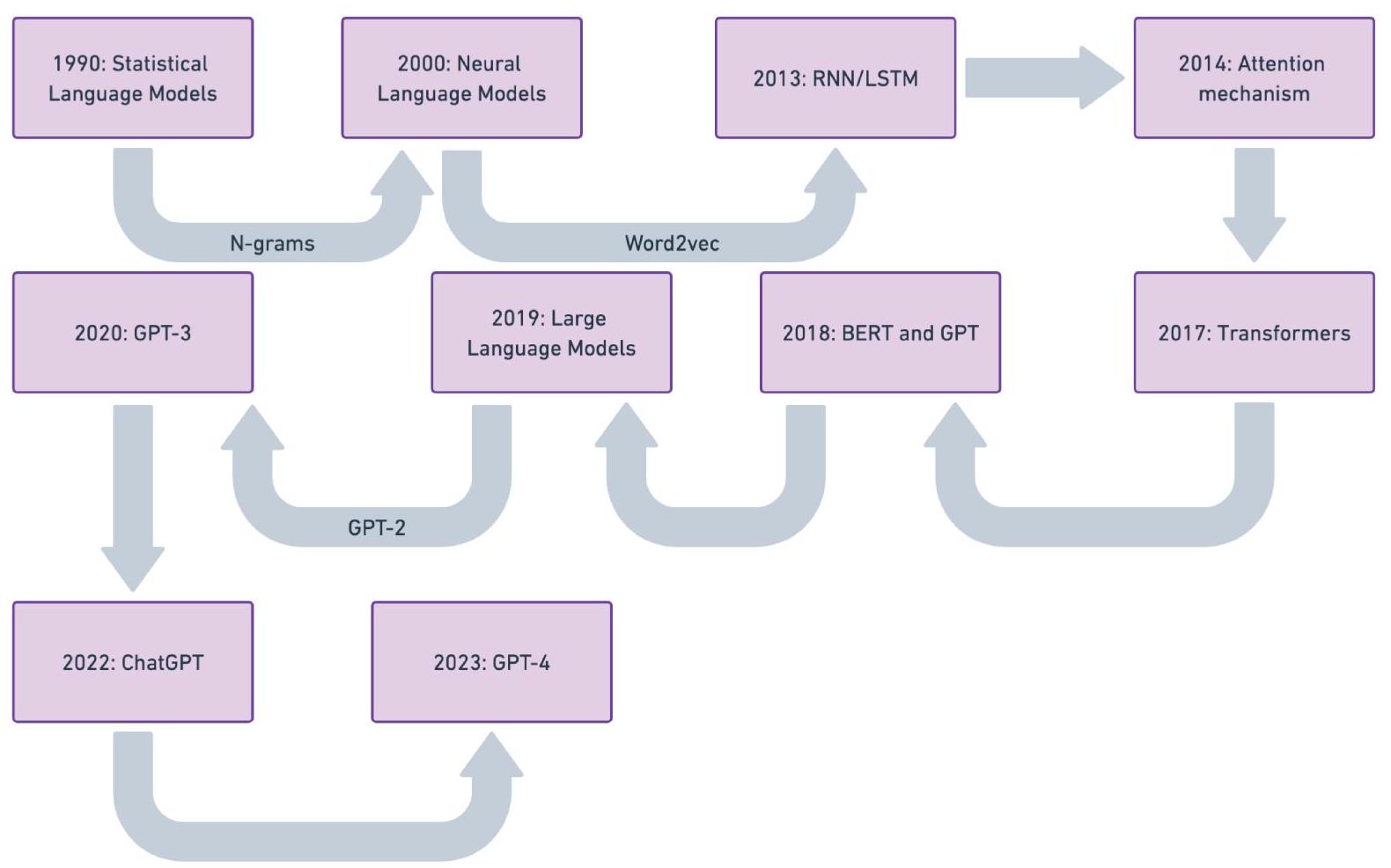

本技术报告深入研究了微调大型语言模型(LLMs)的过程,融合了理论见解和实践应用。首先追溯了LLMs的历史发展,强调它们从传统自然语言处理(NLP)模型的演变及其在现代人工智能系统中的关键角色。分析区分了各种微调方法,包括监督学习、无监督学习和基于指令的方法,强调它们对特定任务的各自影响。报告介绍了一个结构化的七阶段微调管道,涵盖了从数据准备到模型部署的完整生命周期。关键考虑因素包括数据收集策略、

DocuPilot是一款开源的Office AI助手,支持Excel、Word和PowerPoint三大应用的自然语言交互。用户只需用日常对话描述需求,AI就能自动完成复杂操作,如数据分析、文档编辑和PPT制作。基于Claude Agent SDK开发,具备意图理解、任务分解和错误修复能力。作为MIT开源项目,它提供免费、透明、可定制的解决方案,支持本地部署和模型切换。相比付费的Microsoft

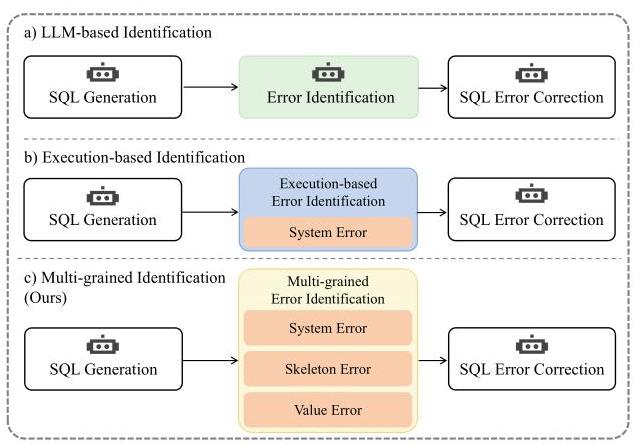

文本转SQL是一种将自然语言问题转换为可执行SQL查询的技术,使用户能够更轻松地查询和管理关系型数据库。近年来,大语言模型显著推动了文本转SQL的发展。然而,现有方法在SQL生成过程中往往忽略了对生成结果的验证。当前的错误识别方法主要分为基于大模型的自纠错方法和基于SQL执行的反馈方法,这两种方法都存在局限性。我们将SQL错误主要分为三类:系统错误、框架错误和值错误,并提出了一种多粒度错误识别方法

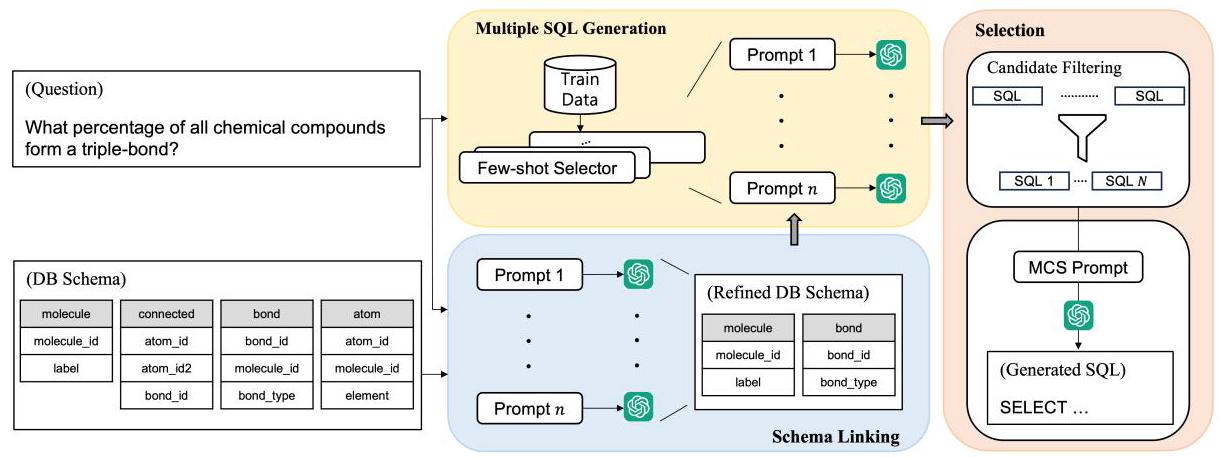

大型语言模型(LLMs)的最新进展催生了基于上下文学习(ICL)的方法,这些方法在文本到SQL任务中显著优于微调方法。然而,在包含复杂模式和查询的基准测试(如BIRD)中,它们的性能仍远低于人类专家。本研究考虑了大型语言模型对提示的敏感性,并引入了一种新方法,该方法利用多个提示来探索更广泛的可能答案搜索空间,并有效地对这些答案进行聚合。具体而言,我们通过使用多个提示进行模式链接,对数据库模式进行稳

论文:https://arxiv.org/abs/2411.00073Abstract-文本到SQL生成旨在将自然语言问题转换为SQL语句。在基于大语言模型的文本到SQL任务中,模式链接(schema linking)是一种广泛采用的策略,它通过仅选择相关的模式元素来简化大语言模型(LLM)的输入,从而减少噪声和计算开销。然而,模式链接面临一些需要谨慎对待的风险,包括可能遗漏必要元素以及破坏数据库

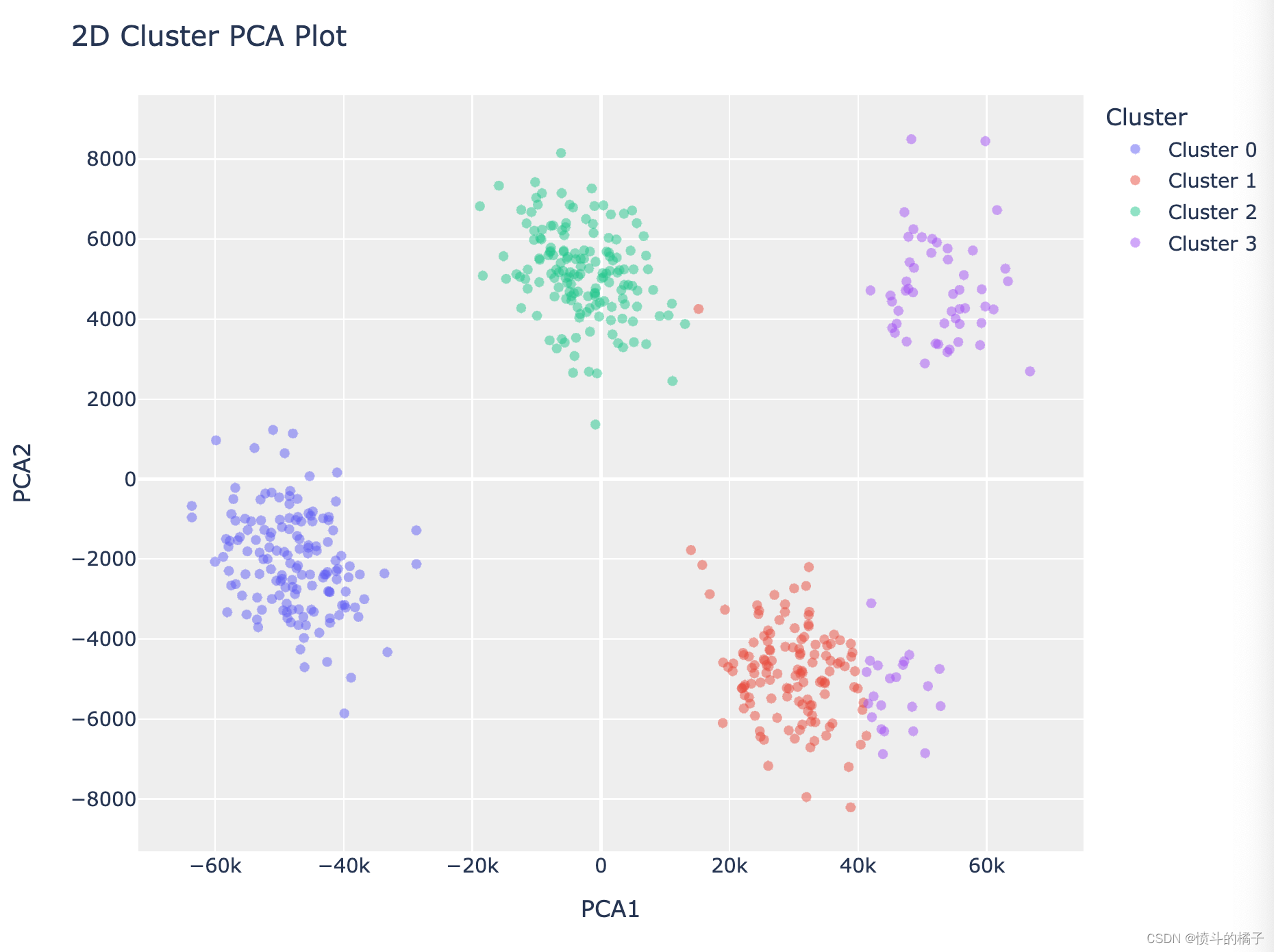

PyCaret 是一个开源的、低代码的 Python 机器学习库,可以自动化机器学习工作流程。它是一个端到端的机器学习和模型管理工具,可以大幅加快实验周期并提高工作效率。与其他开源机器学习库相比,PyCaret 是一个替代低代码库,可以用几行代码代替数百行代码。这使得实验速度指数级增长,效率更高。PyCaret 本质上是围绕几个机器学习库和框架(如scikit-learn、XGBoost、Ligh

在应对文本到SQL(Text-to-SQL)任务中大型语言模型(LLM)性能方面的挑战时,我们推出了CHASE - SQL,这是一个采用创新策略的新框架,它在多智能体建模中利用测试时计算来改进候选SQL语句的生成和选择。CHASE - SQL利用大语言模型的内在知识,通过不同的大语言模型生成器来生成多样化且高质量的SQL候选语句,具体方法如下:(1)采用分治法,在一次大语言模型调用中将复杂查询分解

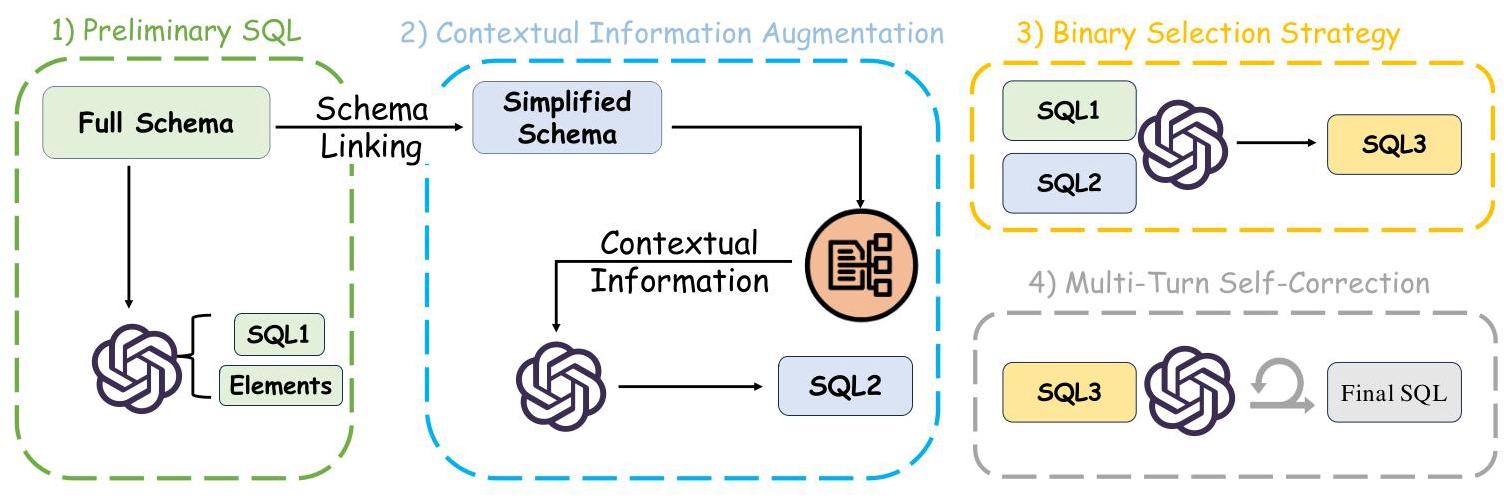

将自然语言查询转换为结构化查询语言(文本到SQL或自然语言查询到SQL)是自然语言处理和数据库领域广泛研究的一项关键任务,旨在为数据库提供自然语言接口(NLIDB),并降低非专业人员的使用门槛。尽管最近通过使用大语言模型(LLM)取得了一些进展,但仍然存在重大挑战。这些挑战包括处理复杂的数据库模式、解决用户查询中的歧义,以及生成能够准确反映用户意图的复杂结构SQL查询。在这项工作中,我们引入了E

使用excalidraw制作所以,你想学习人工智能?但你不知道如何开始或从哪里开始?我在2020年写了一篇。但我意识到,参加很多课程并不是正确的方法。为了摆脱教程地狱并学到东西,你必须动手实践,从零开始编写算法,实现论文,并使用人工智能进行有趣的项目来解决问题。本文试图制定一份遵循这一理念的课程计划。首先,关于课程计划的一些说明和学习建议。