简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这一节比较简单,主要介绍对训练好的模型的参数进行保存与加载,也对应上一文章的注意过程记录。这里面涉及的是save_checkpoint函数、load_checkpoint和load_param_into_net函数。值得注意的是,MindIR模型。如果说checkpoint是对标PyTorch的checkpoint,那MindIR预计是对标onnx和onnxruntime,用于端侧(后文写着还有云

从网络构建中加载代码,构建一个神经网络模型。nn.ReLU(),nn.ReLU(),超参(Hyperparameters)是可以调整的参数,可以控制模型训练优化的过程,不同的超参数值可能会影响模型训练和收敛速度。目前深度学习模型多采用批量随机梯度下降算法进行优化,随机梯度下降算法的原理如下:公式中,𝑛是批量大小(batch size),η是学习率(learning rate)。另外,𝑤𝑡为训

SSD,全称Single Shot MultiBox Detector,是Wei Liu在ECCV 2016上提出的一种目标检测算法。使用Nvidia Titan X在VOC 2007测试集上,SSD对于输入尺寸300x300的网络,达到74.3%mAP(mean Average Precision)以及59FPS;对于512x512的网络,达到了76.9%mAP ,超越当时最强的Faster R

数据、算力、算法,人工智能的三大要素。迁移学习,很有拿来主义的内涵。一个已经在大规模数据上训练的具有良好的泛化特征的网络进行特征提取,而训练除最后一层分类网络。着重关注网络定义、权重冻结(不计算梯度)。真正能应用的是成熟的有效果的,与科研追求学术前沿是相反的。在实际应用场景中,由于训练数据集不足,所以很少有人会从头开始训练整个网络。普遍的做法是,在一个非常大的基础数据集上训练得到一个预训练模型,然

FCN主要用于图像分割领域,是一种端到端的分割方法,是深度学习应用在图像语义分割的开山之作。通过进行像素级的预测直接得出与原图大小相等的label map。因FCN丢弃全连接层替换为全卷积层,网络所有层均为卷积层,故称为全卷积网络。全卷积神经网络主要使用以下三种技术:卷积化(Convolutional)使用VGG-16作为FCN的backbone。VGG-16的输入为224*224的RGB图像,输

是非常有趣的应用了,生成模型、语音生成。与当前的大模型、具身智能、多模态等等挺有关系的。使用了MindNLP。或许后续可以考虑变成一个项目,而不单是Jupyter Notebook。MusicGen是来自Meta AI的Jade Copet等人提出的基于单个语言模型(LM)的音乐生成模型,能够根据文本描述或音频提示生成高质量的音乐样本,相关研究成果参考论文《MusicGen直接使用谷歌的及其权重作

近些年,随着基于自注意(Self-Attention)结构的模型的发展,特别是Transformer模型的提出,极大地促进了自然语言处理模型的发展。由于Transformers的计算效率和可扩展性,它已经能够训练具有超过100B参数的空前规模的模型。ViT则是自然语言处理和计算机视觉两个领域的融合结晶。在不依赖卷积操作的情况下,依然可以在图像分类任务上达到很好的效果。ZOMI酱对本文的贡献。

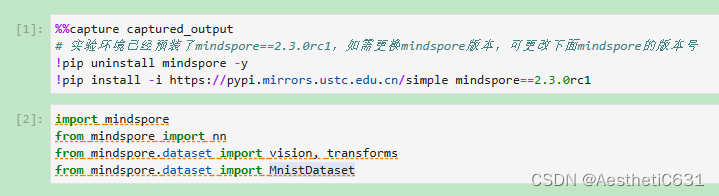

快速入门走通了一个深度学习基本流程。大约分为四个模块。后续变成工程时,大约转换成不同的.py文件。1.数据预处理,了解数据情况,例如图片与标签的组织结构,使用mindspore.datasett模块进行数据预处理,定义一些超参数,比如batch_size。定义了一些transforms参数,比如vision.Rescale和vision.Normalize。和PyTorch的transform也挺

当我们定义神经网络时,可以继承nn.Cell类,在__init__方法中进行子Cell的实例化和状态管理,在construct方法中实现Tensor操作。construct意为神经网络(计算图)构建,相关内容详见使用静态图加速。评:类似PyTorch中的模型定义和forward,这里改了forward为construct,改了继承torch.nn为继承nn.cell。这一部分完成了整一个流程,模型

MobileNet网络是由Google团队于2017年提出的专注于移动端、嵌入式或IoT设备的轻量级CNN网络,相比于传统的卷积神经网络,MobileNet网络使用深度可分离卷积(Depthwise Separable Convolution)的思想在准确率小幅度降低的前提下,大大减小了模型参数与运算量。并引入宽度系数 α和分辨率系数 β使模型满足不同应用场景的需求。