简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

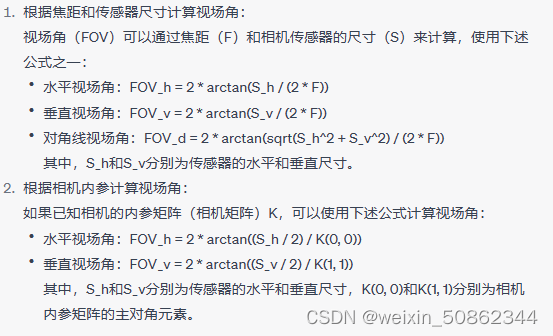

【计算机视觉】视场角

其实K(0,0)和K(1,1)只是x和y方向上的焦距。

ppocrlabel简单教学

ppocrlabel简单教学

paddleocr window10初体验

paddleocr安装和使用

【论文笔记】GeneFace: Generalized and High-FidelityAudio-Driven 3D Talking Face Synthesis

(3)然而,由于生成的标志(多说话人域)和NeRF训练集(目标人域)之间的域转移,我们发现基于NeRF的渲染器在给定预测的地标的情况下无法生成高保真的帧。每一个三维的人脸,可以由一个数据库中的所有人脸组成的基向量空间中进行表示,而求解任意三维人脸的模型,实际上等价于求解各个基向量的系数的问题。蒙特卡罗ELBO不依赖于解析计算,而是通过随机采样的方式进行估计,优点是可以应用于各种复杂的概率模型,不受

迁移学习 & 凯明初始化

乱七八糟的

到底了