简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

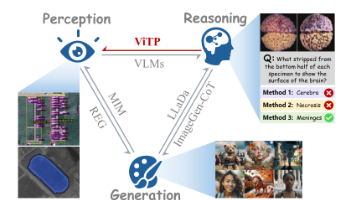

本文提出了一种创新的自上而下视觉指令预训练框架ViTP,通过利用视觉语言模型(VLM)的推理能力反向指导视觉编码器的特征学习。与传统的自监督或对比学习方法不同,ViTP将ViT嵌入多模态大模型,通过特定领域指令任务迫使ViT学习具有辨识度的深层特征。核心创新包括:1)设计视觉鲁棒性学习(VRL),随机丢弃75%视觉token以提高特征信息密度;实验表明,ViTP在遥感和医疗领域的16个数据集上均取

本文主要介绍了一种新的基于CLIP模型的指代图像分割方法,称为CRIS。该方法通过视觉语言解码和对比学习来实现文本和像素级特征之间的对齐,以提高跨模态匹配的能力。作者在三个基准数据集上的实验证明了该方法的有效性。

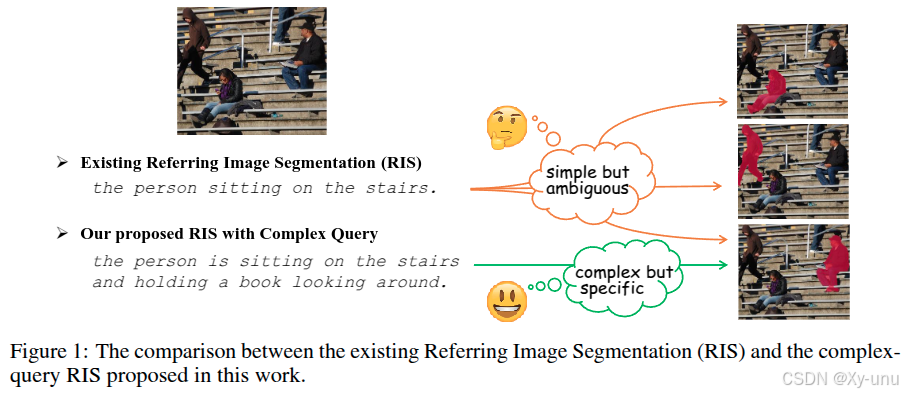

鉴于大预训练模型语义理解能力提升,有必要在 RIS 中纳入复杂语言查询。作者基于 RefCOCO 和 Visual Genome 数据集构建新基准数据集 RIS - CQ ,该数据集高质量、大规模,用丰富信息查询挑战现有 RIS,推动 RIS 研究。还提出双模态图对齐模型 DUCOGA 用于 RIS - CQ 任务。

Swin Transformer 采用 pixel-word attention module (PWAM) 模块进行多模态融合。语言门 Language gate (LG),用于管理语言在语言路径 Language pathway (LP) 上的信息流动。拼接后的特征图做两个 conv 3x3 + Batch Norm + ReLU。PWAM:conv 1x1 + ReLU 视觉特征和多模态注意

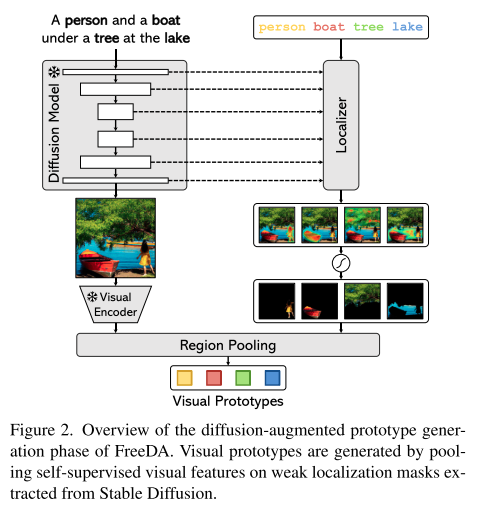

提出了Freeda,一种无训练的无监督开放词汇切分方法。方法利用视觉原型和文本关键字通过扩散增强生成来离线提取,并利用推理时的局部全局相似性。在实验上,在五个不同的数据集上获得了最先进的结果。

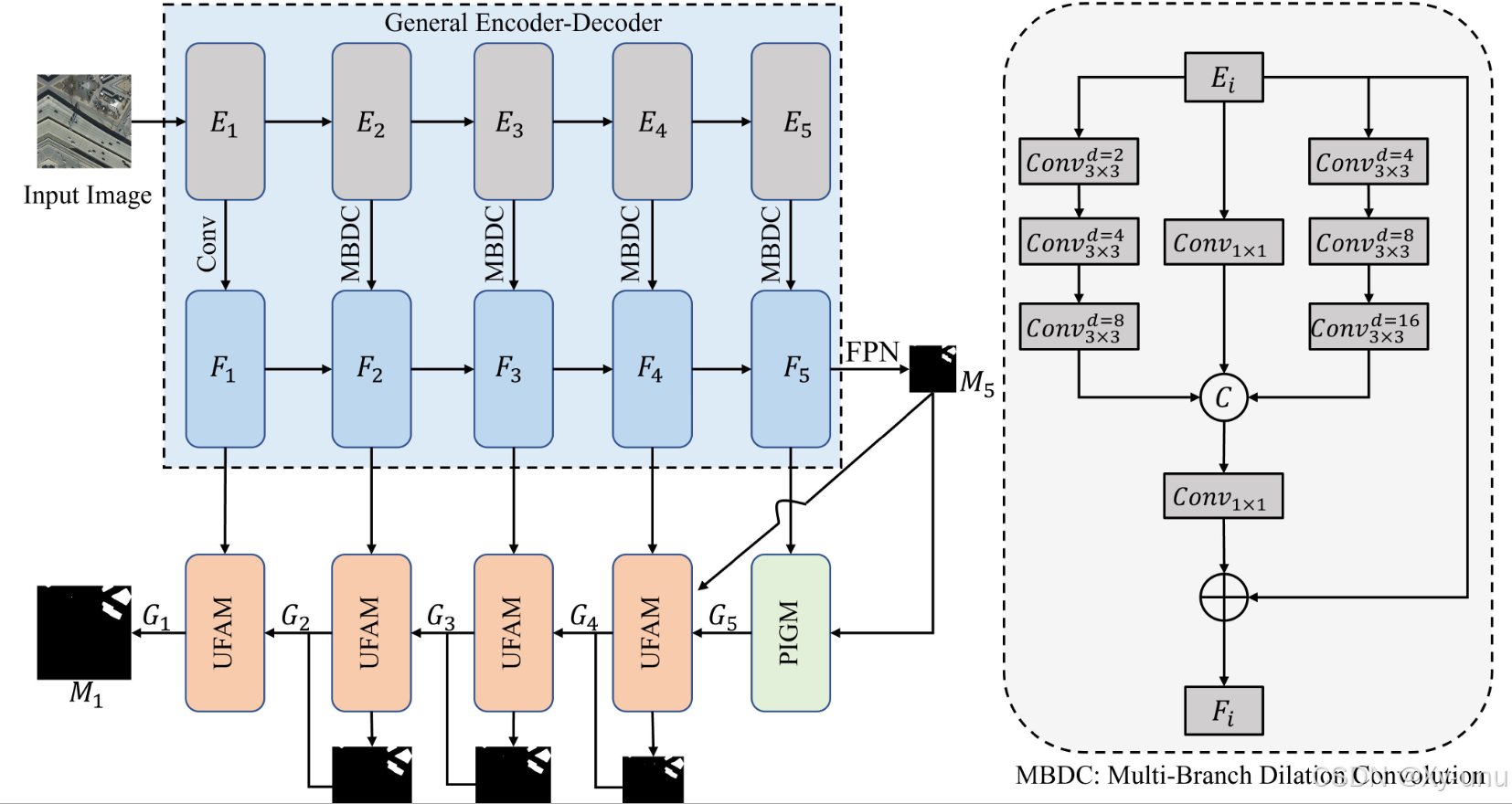

我们引入了不确定性的概念,并提出了一种新的UANet。首先,我们利用一个通用的编码器-解码器网络来产生一个通用的不确定提取图。其次,我们提出了 PIGM 来增强最高级别的特征。随后,利用URA提出了UAFM,以消除从高层到低层特征的不确定性。最后,所提出的UANet输出不确定度较低的最终提取图。通过进行充分的实验,我们验证了 UANet 的有效性。

本文介绍了CTA-Net,这是一种用于在小规模数据集(少于100,000个样本)上改善多尺度特征提取的CNN-Transformer聚合网络。CTA-Net解决了CNN和ViT特征融合不足以及模型复杂度高的挑战。通过在ViT框架内整合CNN操作,CTA-Net利用了两种架构的优势,增强了局部特征提取和全局信息处理,提高了网络的表征能力。逆重建CNN变体(RRCV)和轻量级多尺度特征融合多头自注意力

Cutie 是一个视频对象分割框架——它是 XMem 的后续工作,具有更好的一致性、鲁棒性和速度。该库包含标准视频对象分割的代码和交互式视频分割的 GUI 工具。

ReMaber,一种新颖的 RIS 架构,它将 Mamba 的力量与多模态 Mamba Twister 块相结合。Mamba Twister 显式建模图像-文本交互,并通过其独特的通道和空间扭曲机制融合文本和视觉特征。我们使用简单有效的架构在三个具有挑战性的基准上实现了具有竞争力的结果。

证明了利用小波变换( Wavelet Transform,WT ),实际上可以获得非常大的感受野而不受过参数化的影响,例如,对于一个k × k的感受野,所提出的方法中可训练参数的数量只与k成对数增长。所提出的WTConv层可以作为现有架构中的直接替换。