简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

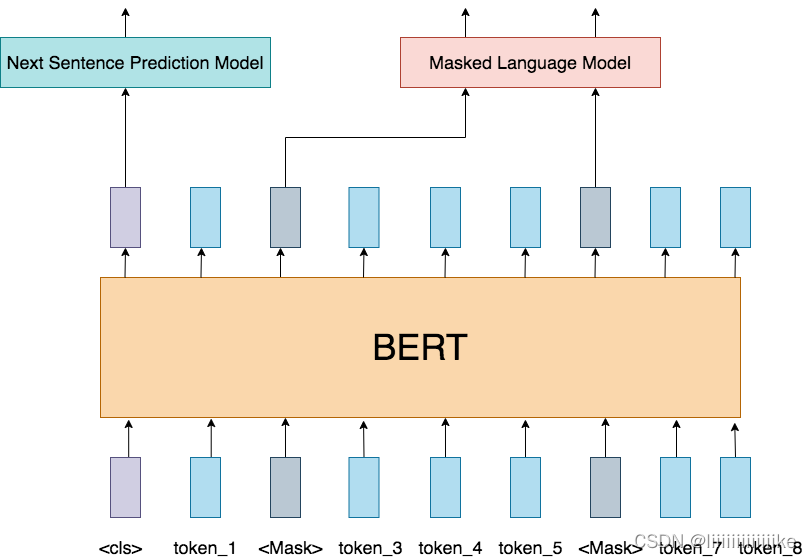

一顿读下来,你可能有个印象:如果训练数据量不够多的话,看起来VIT也没比CNN好多少呀,VIT的意义是什么呢?这是个很好的问题,因为在工业界,人们的标注数据量和算力都是有限的,因此CNN可能还是首要选择。但是,VIT的出现,不仅是用模型效果来考量这么简单,今天再来看这个模型,发现它的意义在于证明了一个统一框架在不同模态任务上的表现能力。在VIT之前,NLP的SOTA范式被认为是Transforme

第一步:使用标签数据训练模型第二步:使用训练的模型为不加标签的数据预测标签第三步:同时使用pseudo和标签数据集重新训练模型在第三步中训练的最终模型用于对测试数据的最终预测

数据、算法、算力是人工智能发展的三要素。数据决定了Ai模型学习的上限,数据规模越大、质量越高,模型就能够拥有更好的泛化能力。然而在实际工程中,经常有数据量太少(相对模型而言)、样本不均衡、很难覆盖全部的场景等问题,解决这类问题的一个有效途径是通过数据增强(Data Augmentation),使模型学习获得较好的泛化性能。1. 数据增强介绍数据增强(Data Augmentation)是在不实质性

一、创建TensorRT有以下几个步骤:1.用TensorRT中network模块定义网络模型2.调用TensorRT构建器从网络创建优化的运行时引擎3.采用序列化和反序列化操作以便在运行时快速重建4.将数据喂入engine中进行推理二、Python api和C++ api在实现网络加速有什么区别?个人看法1.python比c++更容易读并且已经有很多包装很好的科学运算库(numpy,scikit

特征金字塔 特征金字塔是目前用于目标检测、语义分割、行为识别等方面比较重要的一个部分,对于提高模型性能具有非常好的表现,因为视觉任务中存在不同尺寸的物体,而cnn特征提取层级化结构的特点,因此需要在不同level层检测不同尺寸大小的物体。特征金字塔具有在不同尺度下有不同分辨率的特点,不同大小的目标都可以在相应的尺度下拥有合适的特征表示,通过融合多尺度信息,在不同尺度下对不同大小的目标进行预测,从

1 LabelImgLabelImg 是一款开源的图像标注工具,标签可用于分类和目标检测,它是用 Python 编写的,并使用Qt作为其图形界面,简单好用。注释以 PASCAL VOC 格式保存为 XML 文件,这是 ImageNet 使用的格式。 此外,它还支持 COCO 数据集格式。2 Labelmelabelme 是一款开源的图像/视频标注工具,标签可用于目标检测、分割和分类。灵感是来自于

为什么要学习偏移而不是实际值? Anchor已经粗略地“框住了”输入图像中的目标,明显的一个问题是:框的不够准确。因为受限于Anchor的生成方式,Anchor的坐标永远都是固定的那几个。所以,如果我们需要预测相对于Anchor的offset,那么,就可以通过预测的offset调整锚框位置,从而得到更精准的bounding box。为什么要学习偏移系数而不是偏移量? 因为w和h都是正数,而网络

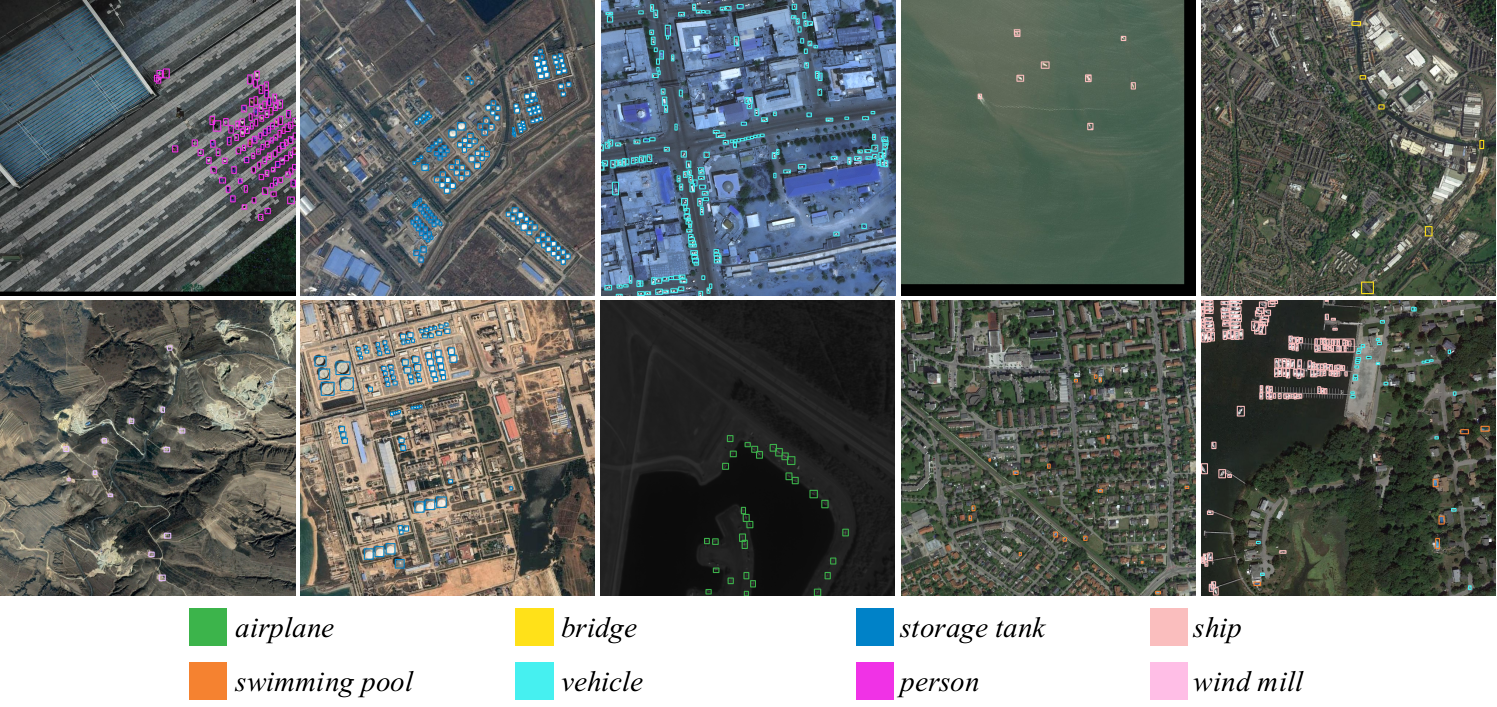

在这里插入图片描述](https://img-blog.csdnimg.cn/direct/c263ea3db15547c6903838fba9683ebd.png)[在这里插入图片描述](https://img-blog.csdnimg.cn/direct/0f67372ff9454e6e9b67e0cbe71d2371.png)*小目标自身的纹理显著度有强弱区别,但是总体来说纹理特征都较弱,很

特征金字塔 特征金字塔是目前用于目标检测、语义分割、行为识别等方面比较重要的一个部分,对于提高模型性能具有非常好的表现,因为视觉任务中存在不同尺寸的物体,而cnn特征提取层级化结构的特点,因此需要在不同level层检测不同尺寸大小的物体。特征金字塔具有在不同尺度下有不同分辨率的特点,不同大小的目标都可以在相应的尺度下拥有合适的特征表示,通过融合多尺度信息,在不同尺度下对不同大小的目标进行预测,从

前言图像size对于训练任务的准确性有很大影响,size越大小目标越清晰,而目前大部分模型的input都是resize或者reshape成W,H相同(双线性插值),但是这些resize会不会限制了训练网络的任务性能呢?作者通过实验证明硬resize可被调整为可学习的resize,从而大大提高性能。背景目前resize方法都是提前设计好了,因此我这里自己取名为硬resize,典型的有NEAREST,