简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

近年来,研究者提出了多种混合推理方法,在思考(CoT)和非思考模式间实现智能切换。

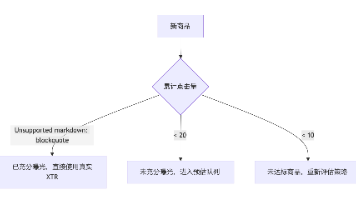

本文提出了一种基于语义理解和GBRT的新商品冷启动解决方案,用于解决电商平台新商品因缺乏用户行为数据而难以准确推荐的问题。方案通过Qwen3模型提取商品语义特征,构建1280维向量表征商品内容,再采用梯度提升树预测消费指标XTR。实验表明,该方法显著提升了新商品的转化率和GMV,优化后模型误差率降至4.5%。文章还讨论了模型过拟合风险和改进方向,包括增强正则化、引入多模态特征等,为电商平台新商品推

传统自回归解码存在串行依赖和内存墙问题,GPU利用率不足30%。SpecInfer提出树状推测式推理方案,通过双引擎驱动实现突破:1)扩展引擎用小模型生成多路径候选树(Top-5成功率97%),2)融合引擎并行验证整棵树。关键技术包括树注意力机制和深度优先缓存共享,单次前向传播即可验证多路径。实验显示,LLaMA-65B在8*A100上实现2.8倍加速,OPT-30B单卡卸载推理达43.1 tok

本文提出了一种新型强化学习算法AEPO(Agentic Entropy-Balanced Policy Optimization),旨在解决大模型在多轮工具调用任务中因过度依赖熵信号导致的两个关键问题:高熵轨迹崩溃和梯度裁剪失效。AEPO通过动态熵平衡机制(包括熵预监控和分支惩罚)和熵感知策略优化(停止梯度裁剪和优势估计),在14个推理任务上实现了SOTA性能,仅需1K训练样本就超越GPT-4o等

TDPO:基于Token级偏好的语言模型优化方法 TDPO(Token-level Direct Preference Optimization)是针对DPO方法在句子级KL散度控制上的局限性提出的改进方案。传统DPO存在KL增长失衡和多样性下降等问题,而TDPO通过将RLHF任务拆分为token级MDP,引入Bellman方程和双向KL约束机制。

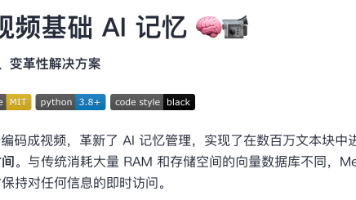

Memvid 通过将文本数据编码成视频,革新了 AI 记忆管理,实现了在数百万文本块中进行闪电般的语义搜索,并具备小于一秒的检索时间。与传统消耗大量 RAM 和存储空间的向量数据库不同,Memvid 将您的知识库压缩成紧凑的视频文件,同时保持对任何信息的即时访问。它有什么优势呢?

本文提出DMPO方法,将单回合的DPO扩展至多回合语言代理场景。通过将策略约束替换为状态-动作占用度量约束,并引入长度归一化因子,解决了多回合场景下partition function无法约简的问题。该方法在Bradley-Terry模型中实现轨迹长度归一化,使不同长度轨迹的累积奖励可比,同时通过衰减权重降低后期动作噪声影响。理论推导表明,DMPO能有效减少行为克隆在多回合任务中的累积误差,实现对

本文深入解析了brpc框架中的并发机制,重点介绍了bthread和Execution Queue的原理与应用。bthread作为M:N线程模型实现,具有高并发低成本的特点,适用于并行计算场景;Execution Queue则提供有序任务处理能力,适合批量操作。文章详细对比了不同并发工具的适用场景,并指出常见陷阱如线程局部存储的风险。通过QPS*Latency公式的决策模型,指导开发者合理选择并发策

摘要: 推荐系统重排阶段常面临结果同质化问题。行列式点过程(DPP)通过建模相关性与多样性的平衡,利用核矩阵的行列式计算子集概率,几何上对应向量集的多样性。核矩阵构造结合物料质量分与相似度(如高斯核),并通过贪婪算法(Fast Greedy MAP)高效求解。工程实现中优化核矩阵正定性、个性化加权(如华为pDPP)及增量计算(Cholesky分解)。实际应用需结合特征工程(如双塔Embedding

这篇文章系统介绍了将7B基础模型升级为ChatGPT级AI助手的四大微调步骤: SFT监督微调:通过标准问答对训练,确保模型回答准确性 IFT指令微调:使用结构化指令数据,提升模型对复杂指令的理解能力 EFT评估微调:训练模型自我评估能力,为后续强化学习做准备 RLHF强化学习:基于人类反馈优化输出,使回答更符合人类偏好 该流程通过逐步优化模型的知识准确性、指令遵循性、评估能力和人类偏好对齐,最终