简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

ldm(通常指 latent-diffusion-models)文件夹和 pip install diffusers 安装的 diffusers 库在功能和应用场景上有一定关联,但也存在明显区别。

根据自己电脑配置安装相应版本(命令行安装)查看目前安装了哪些版本,再使用。

RAM(Recognize Anything Model) 是用于图像识别和描述的模型,能从图像中识别多种对象、属性和场景,并生成对应的文本标签。它基于 Vision Transformer(ViT)架构,尤其代码里用的是 Swin Transformer 作为骨干网络,在大规模图像数据集上预训练,具备强大的图像特征提取和理解能力。RAM 模型用于文本提示提取,从图像里提取文本描述,为后续图像生成

将文本字符串转换为模型可以处理的 token ID 序列。:将 token ID 序列转换为高维度的向量表示,以便与图像表示进行比较。通过这两个组件,你可以处理文本输入并将其转换为适合 CLIP 模型处理的格式,从而实现多模态任务。

stable diffusion 环境配置

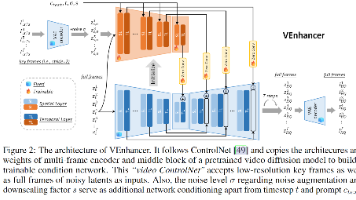

我们提出了VEnhancer,这是一种生成时空增强框架,通过在空间领域中添加更多细节以及在时间领域中合成详细的运动,从而改善现有的文本到视频的结果。针对生成的低质量视频,我们的方法可以通过统一的视频扩散模型同时提高其空间和时间分辨率,支持任意的上采样空间和时间尺度。此外,VEnhancer有效地去除了生成视频中的空间伪影和时间闪烁现象。为此,我们基于预训练的视频扩散模型,训练一个视频控制网络,并将

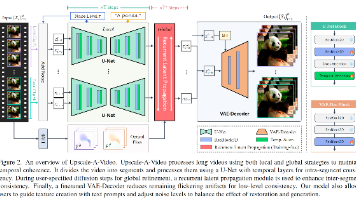

基于文本的扩散模型在生成和编辑方面表现出了显著的成功,显示出利用其生成先验增强视觉内容的巨大潜力。然而,由于对输出逼真度和时间一致性的高要求,将这些模型应用于视频超分辨率仍然具有挑战性,而这一点又因扩散模型固有的随机性而变得更加复杂。我们的研究引入了Upscale-A-Video,一种用于视频上采样的文本引导的潜在扩散方法。该框架通过两个关键机制确保时间一致性:局部上,它将时间层集成到U-Net和

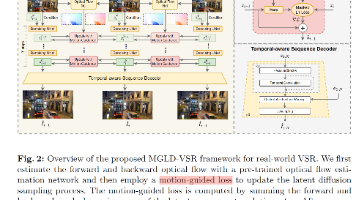

现实世界中的低分辨率(LR)视频存在多样化和复杂的退化现象,这对视频超分辨率(VSR)算法在高质量地再现其高分辨率(HR)对应物时提出了巨大的挑战。最近,扩散模型在图像还原任务中展现出了令人信服的生成真实细节的性能。然而,扩散过程具有随机性,使得控制还原图像内容变得困难。当将扩散模型应用于视频超分辨率(VSR)任务时,这个问题变得更加严重,因为时间一致性对视频的感知质量至关重要。在本文中,我们通过

这些先验可以包括面部特征,也称为几何先验(Geometric Prior),有基于高清参考人脸的先验(Reference Prior) ,有基于强的生成器先验(Generative Prior),也有基于离散的codebook的先验(Vector Quantized Codebook Prior),当然,还有近几年爆火的diffusion,作为强的文生图基本模型,他可以作为一种扩散先验(Diffu

偶然间在GitHub看到有一个创建个人相册的项目,觉得还挺美观的。再加上自己开始慢慢有想着记录生活的习惯,特别是用相机来记录。至少可以让记忆暂时留存。至少去过某些地方,见过某些风景,虽然不多,但至少是宝贵的记忆。本人是纯纯的前端小白,只会根据AI的提示修改东西。所以想记录一下新手怎么搭建自己的个人相册还有很多不足,希望大家给下指点。