简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

CV通常指的是“Computer Vision”(计算机视觉)。然而,传统的RNN模型存在梯度消失和梯度爆炸等问题,为了克服这些问题,后来出现了许多改进的RNN变体,如长短时记忆网络(LSTM)和门控循环单元(GRU)等。在学术和工业界,计算机视觉一直是一个活跃的研究领域,并且随着深度学习和大数据的发展,计算机视觉技术取得了显著的进步,为图像和视频分析提供了更准确和高效的解决方案。总的来说,LST

所谓无监督学习,是指利用无标签的数据学习数据的分布或者数据之间的关系;下面通过跟监督学习的对比来理解无监督学习:监督学习是一种目的明确的训练方式,你知道得到的是什么;而无监督学习则是没有明确目的的训练方式,你无法提前知道结果是什么。监督学习需要给数据打标签;而无监督学习不需要给数据打标签。监督学习由于目标明确,所以可以衡量效果;而无监督学习几乎无法量化效果如何。

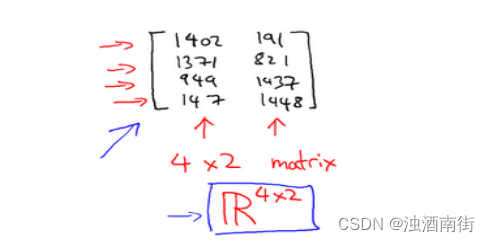

如图:这个是 4×2 矩阵,即 4 行 2 列,如𝑚为行,𝑛为列,那么𝑚 × 𝑛即 4×2

JDBC案例:模拟用户登录(一)1、示例代码如下:package com.jh.www;import java.sql.Connection;import java.sql.DriverManager;import java.sql.ResultSet;import java.sql.SQLException;import java.sql.Statement;import java.util.S

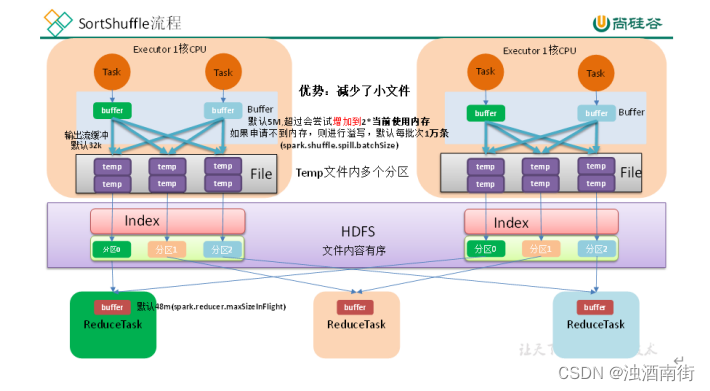

map-side 预聚合,就是在每个节点本地对相同的 key 进行一次聚合操作,类似于MapReduce 中的本地 combiner。map-side 预聚合之后,每个节点本地就只会有一条相同的key,因为多条相同的 key 都被聚合起来了。

目录1.问题引出2.默认partition分区3.自定义Partitioner步骤:4.分区总结5.案例分析:1.问题引出要求将统计结果按照条件输出到不同的文件中(分区)。比如:将统计结果按照手机归属地不同省份输出到不同的文件中(分区)2.默认partition分区public class HashPartitioner<k,v> extends partitioner<k,v&

目录一、正则的通配符简介1、正则表达式的符号及意义2、各种操作符的运算优先级:二、regexp_extract函数一、正则的通配符简介1、正则表达式的符号及意义符号含义实列/做为转意,即通常在"/"后面的字符不按原来意义解释如" * “匹配它前面元字符0次或多次,/a*/将匹配a,aa,aaa,加了”/"后,/a/* /将只匹配"a* "^匹配一个输入或一行的开头/^a/匹配"an A",而不匹配

目录1.FileInputFormat切片机制1.1:切片机制1.2:案例分析1.3:FileInputFormat切片大小的参数配置2.CombineTextInputFormat切片机制2.1:FileInputFormat切片机制的缺陷:2.2:CombineTextInputFormat切片机制2.3:案例分析1.FileInputFormat切片机制1.1:切片机制1.简单地按照文件的内

目录1.语法2.基本实例在mysql中在hive中3.实战3.1:数据准备3.2:需求一:得到临时拉链表 dwd_dim-user_info_his_tmp, 2019-01-023.2:需求二:得到临时拉链表 dwd_dim-user_info_his_tmp, 2019-01-021.语法语法: if(boolean testCondition, T valueTrue, T valueFal

目录1.STR_TO_MAP函数1.1:语法描述1.2:功能描述1.3:案例1.4:实战1.STR_TO_MAP函数将字符类型数据,转化成map格式的数据1.1:语法描述STR_TO_MAP(VARCHAR text, VARCHAR listDelimiter, VARCHAR keyValueDelimiter)1.2:功能描述使用listDelimiter将text分隔成K-V对,然后使用k