简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

距离ChatGPT已经发布1年半了,距离我们训练出自己的大模型也已经1周年了。目前仍然有很多同学在咨询如何训练自己的大模型。这个东西和男/女朋友一样。当你不认识TA,距离TA很远,不敢接触TA的时候,TA就是很神秘,也很难接触。但是一旦当你愈发了解TA的时候,你就知道其实上手也很容易。之前我已经撰写了一个简单的训练baichuan大模型的代码\[1\],用于阐述大模型训练其实和原来的训练没什么两样

高性价比:DeepSeek-V2模型以其史无前例的性价比著称,推理成本被降到每百万token仅1块钱,约等于Llama3 70B的七分之一,GPT-4 Turbo的七十分之一。架构创新:DeepSeek对模型架构进行了全方位创新,提出崭新的MLA(一种新的多头潜在注意力机制)架构,把显存占用降到了过去最常用的MHA架构的5%-13%,同时,独创的DeepSeekMoESparse结构,也把计算量降

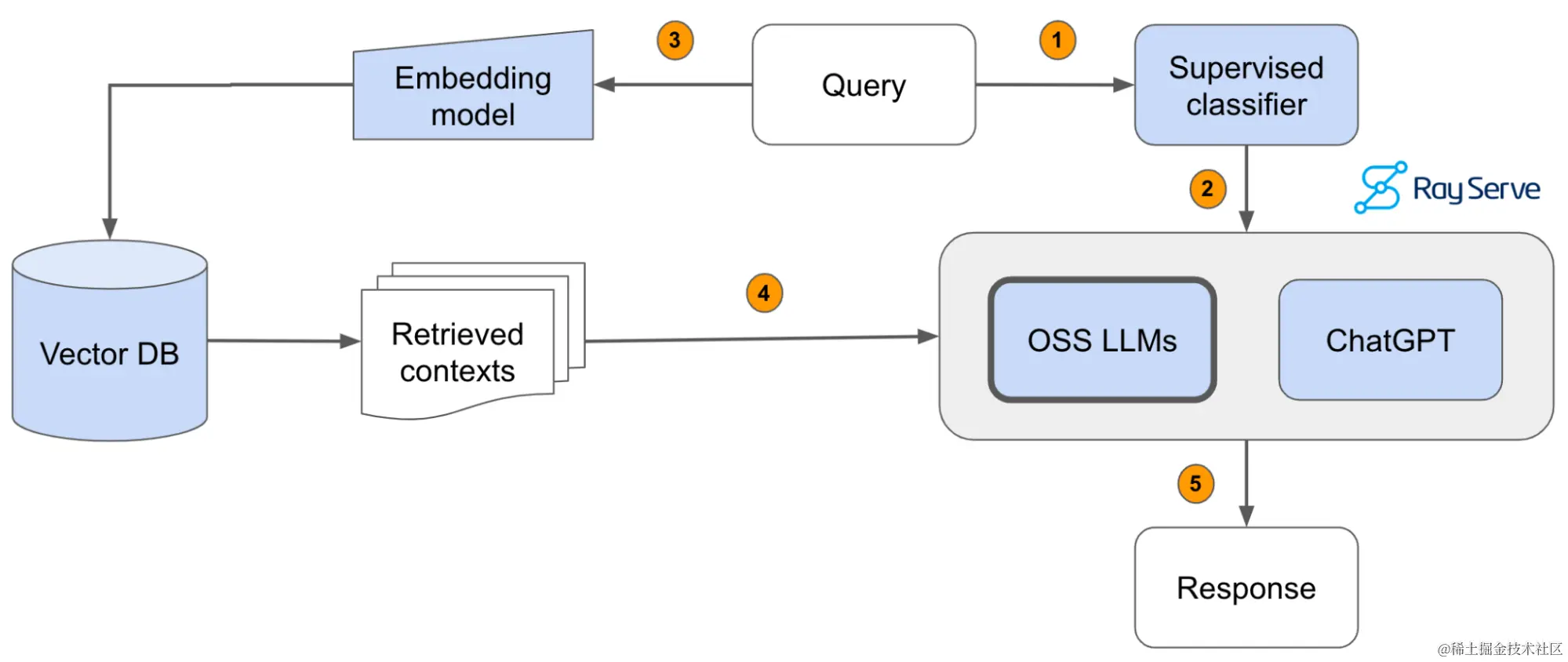

RAG是的缩写,翻译为中文的意思就检索增强,以基于最新,最准确的数据建立LLM的语料知识库。LLMLangChain是一个用于开发由语言模型驱动的应用程序的框架。具有上下文感知能力:将语言模型与上下文源(提示说明、少量镜头示例、基于其响应的内容等)联系起来。

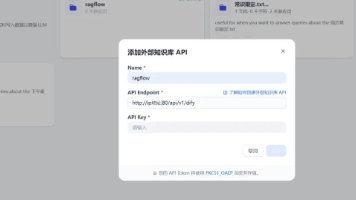

本文详细介绍了如何在Dify平台上集成RAGFlow知识库,通过创建知识库、配置API KEY、连接外部知识库等步骤,实现两种工具的优势互补。这种集成方式充分利用了Dify的工作流能力和RAGFlow优秀的知识库构建与召回功能,解决了Dify文档解析不足的问题,让开发者能够构建更精准、更强大的大模型应用。

2025年已然过半,今年大模型发展既有激动人心,也有惴惴不安,今天我们就从我个人的视角,盘点大语言模型2025年上半年发展的总结,并对下半年发展趋势进行预测分析。

大模型是如何训练的?这六个关键步骤要记牢!

在他看来,模型层依然重要,但是单独靠模型无法完成商业化闭环,绝大多数企业空有模型无用,无法兑现为生产力,企业也不愿意为此付费。AI应用价值越来越显化,模型之上的能力才是决定差异化的关键,当下企业级大模型应用的工程化能力被大大低估了。

很多人刚入门AI,可能对大模型如何学习数据知识的原理不太了解,今天就用一个例子来说明模型学习的过程。如果你将准备从事AI开发,或者也对原理感兴趣,不妨看一看。

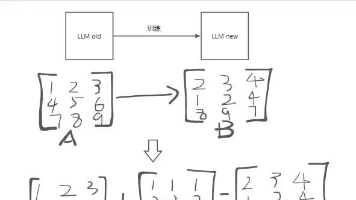

本文详细介绍了LoRA(Low Rank Adaptation)低秩微调技术的原理及在vLLM框架中的实现。文章通过替换原始模型层、预分配显存、动态加载LoRA权重等技术,实现了在不修改原始模型的情况下,用少量额外参数高效微调大模型的能力。详细解析了LoRA的加载、切分和推理过程,为开发者提供了完整的LoRA技术实现指南。

本系列主要通过调用天气的mcp server查询天气这个例子来学习什么是mcp,以及怎么设计mcp。话不多说,我们开始吧。