简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

如果图中没有提示词物品, 可能会强行安利一个不能处理太长的句子, 会超出理解范围提示词很重要, 检测不到的物品, 可能换个表达就能检测出来了.作为开集检测模型, GLIP还是非常优秀的, 比如零样本检测. 还可以实现视频检测任务. 快速自动标注等,至于检测精度, 还不能与有监督算法相比.对于工业部署, zero-shot还是算了, 薛定谔的检测结果不太靠谱. 微调后应该会好很多.

FasterRCNN tensorflow-keras源码解读提示:这里可以添加系列文章的所有文章的目录,目录需要自己手动添加例如:第一章 Python 机器学习入门之pandas的使用提示:写完文章后,目录可以自动生成,如何生成可参考右边的帮助文档文章目录FasterRCNN tensorflow-keras源码解读前言一、pandas是什么?二、使用步骤1.引入库2.读入数据总结前言faste

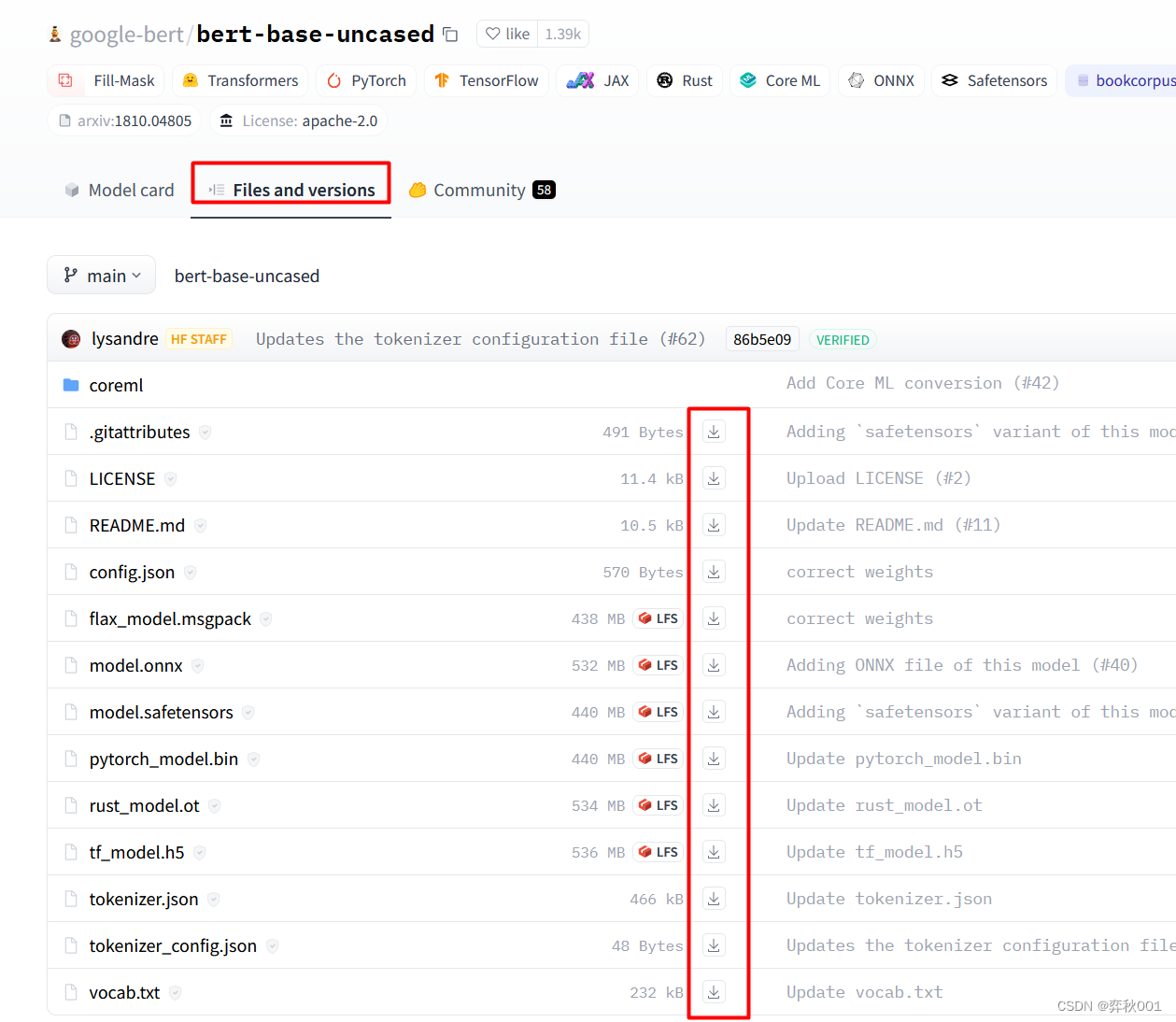

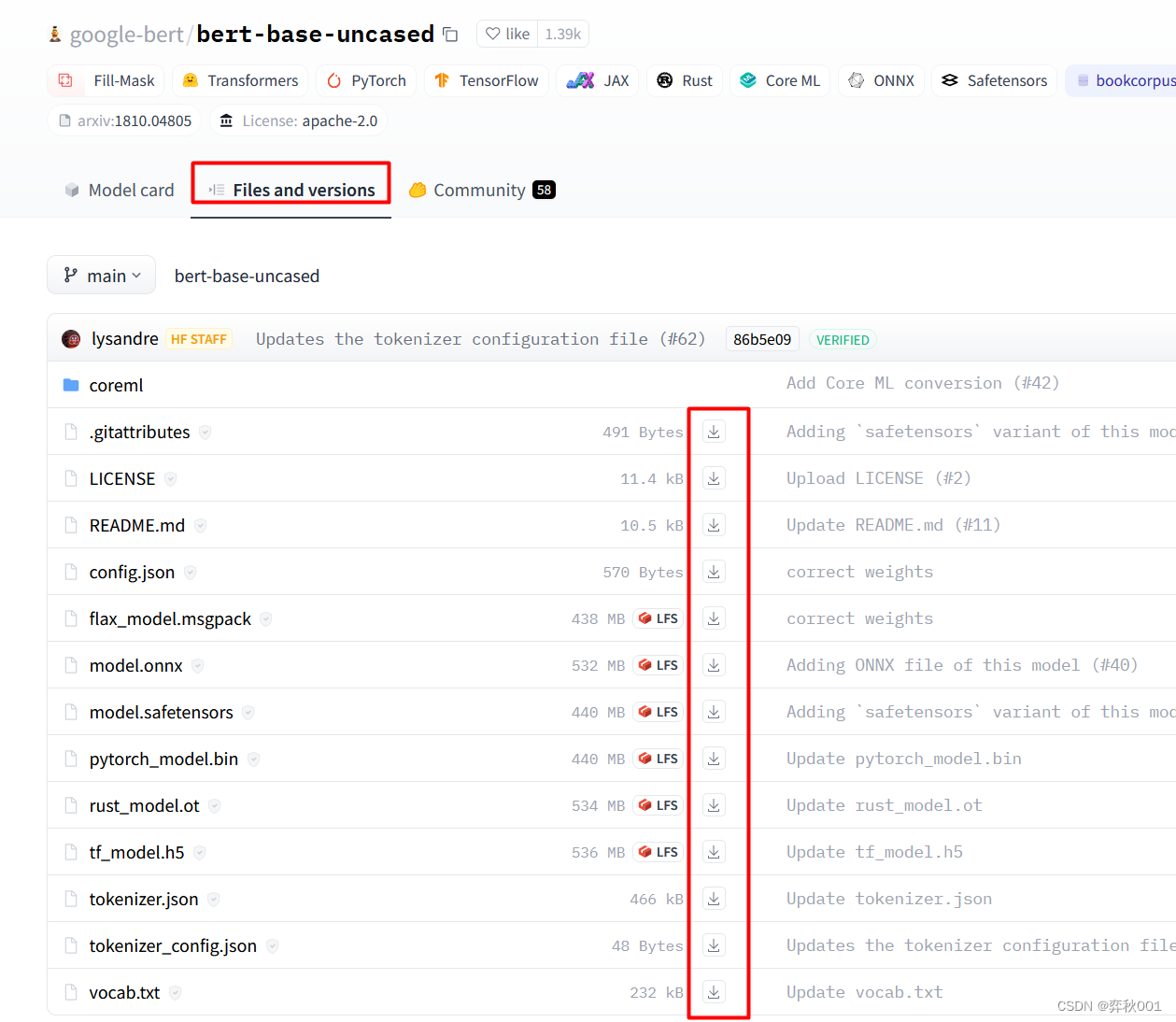

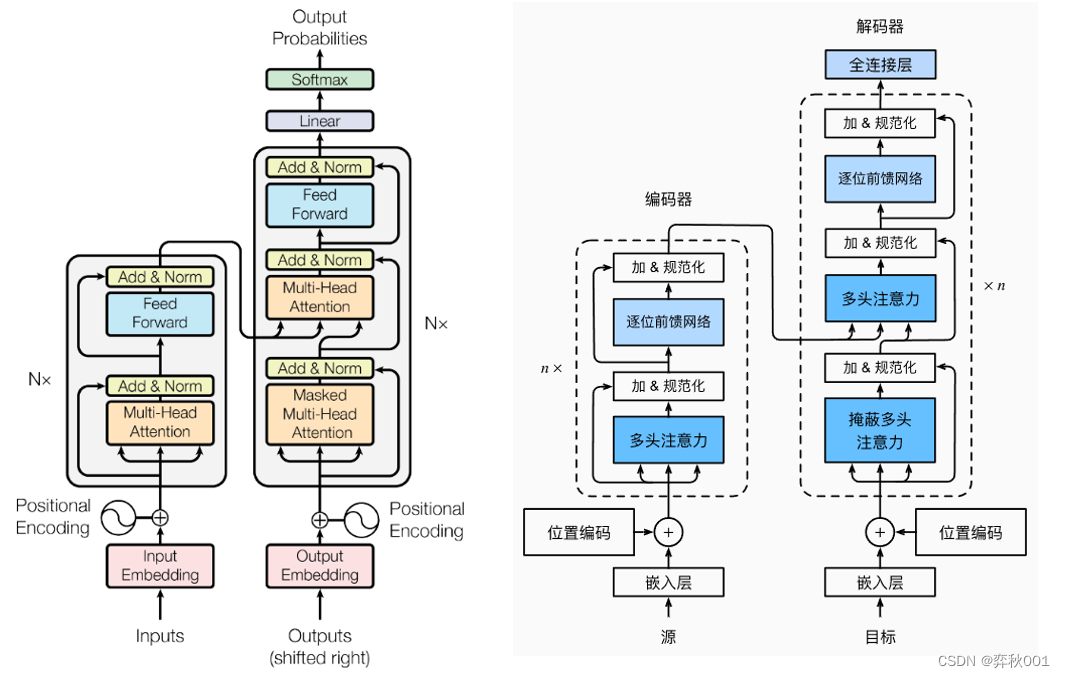

transformer是nlp领域重要创新,被应用到cv领域后更是迅速火爆,在Python包pyitcast已经实现好了transformer模型,为了深刻理解模型各个细节,这里重新手动实现一遍。重要参考:12345关于理论部分,上面列举参考讲的非常好,我写不出更好的文字解读,就直接推荐别人的吧。

TensorRT常见使用问题

比如llama3和llama3.1,在prompt一样时,transformers和vllm的推理结果是对齐的,但qwen系列结果对不齐,这就很奇怪,因为vllm解码与采样策略是所有模型公用的。在模型输出特征一致的情况下, 影响输出token最大因素即是不同的采样策略,如transformers和vllm的推理结果会有偏差。在前面几篇文章中,详细讲述了vllm的调度系统和模型推理流程,现在还剩下最

如果图中没有提示词物品, 可能会强行安利一个不能处理太长的句子, 会超出理解范围提示词很重要, 检测不到的物品, 可能换个表达就能检测出来了.作为开集检测模型, GLIP还是非常优秀的, 比如零样本检测. 还可以实现视频检测任务. 快速自动标注等,至于检测精度, 还不能与有监督算法相比.对于工业部署, zero-shot还是算了, 薛定谔的检测结果不太靠谱. 微调后应该会好很多.