简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

该代码使用了前面的数据路由模式,实现对话聊天数据的总结和删除,以此控制token量降低成本,具体参考代码,具体模式参考前面的博客else:if summary: # 如果存在summ则让大模型进行总结提取,并进行覆盖else:delete_messages = [RemoveMessage(id=m.id) for m in state["messages"]][:-1] # 删除 除最新一条消息

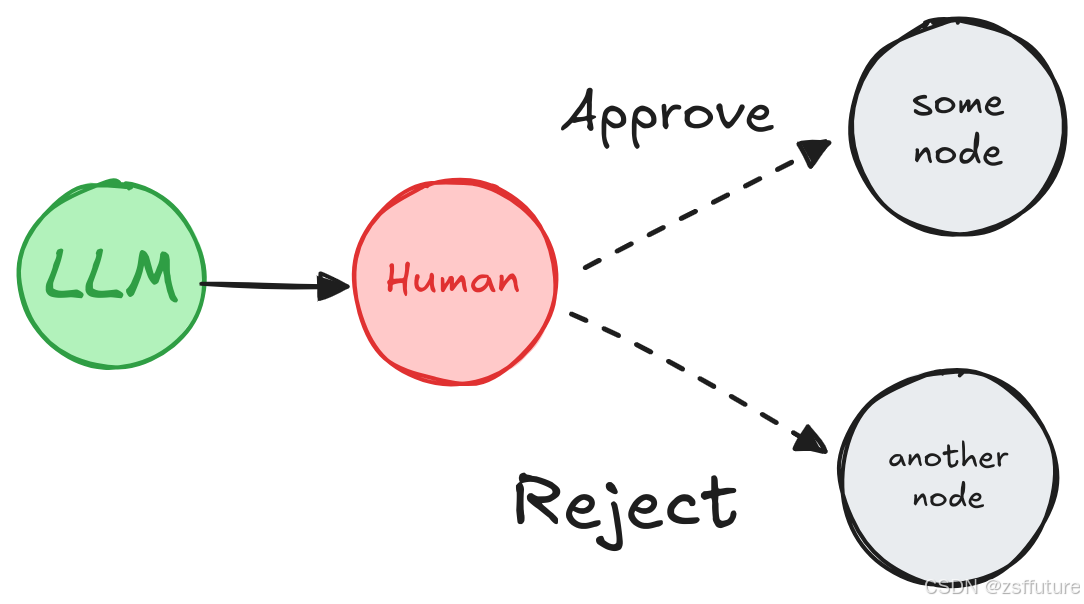

中断通过在特定节点暂停图形,向人类呈现信息,并使用他们的输入恢复图形,来实现人在回路工作流。它对于审批、编辑或收集其他上下文等任务很有用。使用提供人类响应的命令对象恢复图形从上面可以发现Interrupt的参数其实就是发送给客户端提醒用户的,中断返回的结果就是Command命令输入的,即人工参与过程。再看看一个例子是一个特殊的键,如果图形被中断,则在运行图形时将返回该键。在 0.4.0 版本中增加

本文深入解析了瑞芯微(Rockchip)NPU部署深度学习模型时的8位量化技术,重点对比了RKNN支持的三种量化算法(norm/mmse/kl)和两种量化粒度(layer/channel)。量化通过缩放因子建立FP32与INT8的线性映射,在可控精度损失下实现模型体积缩减75%和推理速度提升4~8倍。norm算法计算简单但精度中等,mmse通过最小均方误差优化精度,kl算法精度最高但计算复杂。量化

1. 创建计算相关的mcp : math_mcp_server.py。上面调用方法是直接调用python执行文件,还可以流式调用,后面讲。2. 创建计算体脂率相关的mcp。

本节开始深度学习的第一个算法BP算法,本打算第一个算法为单层感知器,但是感觉太简单了,不懂得找本书看看就会了,这里简要的介绍一下单层感知器:图中可以看到,单层感知器很简单,其实本质上他就是线性分类器,和机器学习中的多元线性回归的表达式差不多,因此它具有多元线性回归的优点和缺点。单层感知器只能对线性问题具有很好的解决能力,但是非线性问题就无法解决了,但是多层感知器却可以解决非线性问题,多层感...

上一节我们详细推倒了BP算法的来龙去脉,请把原理一定要搞懂,不懂的请好好理解BP算法详解,我们下面就直接把上一节推导出的权值调整公式拿过来,然后给出程序流程图,该流程图是严格按照上一节的权值更新过程写出的,因此称为标准的BP算法,标准的BP算法中,每输入一个样本,都要回传误差并调整权值,这种对每个样本轮回训练权值的调整方法称为单样本训练,下面先给出权值调整公式,然后给出流程图:程序流程图 ...

从今天开始进入深度学习领域,深度学习我在前两年的理论学习过程中,体会颇深,其中主要有两个算法CNN和RNN,但是本人喜欢追本溯源,喜欢刨根问题。最重要的是每个算法并不是拍脑袋想出来的,是根据当时的研究进程和研究环境有关,因此想要深入理解深度学习的精髓,我们需要去了解,深度学习因为什么被提出来的,解决了什么问题,为什么能解决问题以及这个算法和机器学习有什么本质的区别等等。想要回答这些问题,就

另在一篇文章中,我们介绍了随机梯度下降的细节以及如何解决陷入局部最小值或鞍点等问题。在这篇文章中,我们看看另一个困扰神经网络训练的问题,即病态曲率。虽然局部最小值和鞍点可以阻止我们的训练,但是病态曲率可以使训练减慢到机器学习从业者可能认为搜索已经收敛到次优极小值的程度。让我们深入了解病理曲率是什么。病态曲率考虑以下损失轮廓。 ...

thrust#include <stdio.h>#include <thrust/host_vector.h>#include <thrust/device_vector.h>#include <thrust/sort.h>#include <iostream>using namespace std;__host__ __device__

前两节我们详细讨论了退火算法和玻尔兹曼分布,本节将使用这两个算法和Hopfield神经网络结合构成新的神经网络即随机神经网络又叫玻尔兹曼机,这个神经网络是模拟能量的特性,从能量角度出发,构造和能量过程类似的神经网络,之所以这样构建和Hopfield神经网络有很大的关系,稍后我们会看到和Hopfield神经网络的异同点。另外这个神经网络不具有实用性,因为计算量太大了,但是我们为什么还要