简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

LongChain + Deepseek + Faiss 打造RAGLongChain的功能跟大模型中的 Function Call 类似。

(1)为什么能实现成本低,计算速度快架构设计方面DeepSeek MoE架构:在推理时仅激活部分专家,避免了激活所有参数带来的计算资源浪费。ML架构:MLA通过降秩KV矩阵,减少了显存消耗。训练策略方面多token预测(MTP)目标:在训练过程中采用多token预测目标,即在每个位置上预测多个未来token,增加了训练信号的密度,提高了数据效率。混合精度训练框架:在训练中,对于占据大量计算量的通用

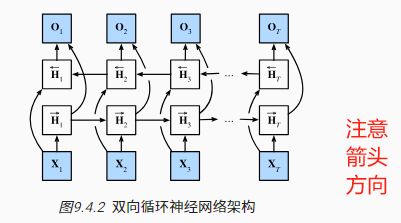

将前向隐状态 和反向隐状态连接起来, 获得需要送入输出层的隐状态H在双向循环神经网络中,每个时间步的隐状态由当前时间步的前后数据同时决定。双向循环神经网络与概率图模型中的“前向-后向”算法具有相似性。双向循环神经网络主要用于序列编码和给定双向上下文的观测估计。由于梯度链更长,因此双向循环神经网络的训练代价非常高。双向层的使用在实践中非常少,并且仅仅应用于部分场合。例如,填充缺失的单词、词元注释(例

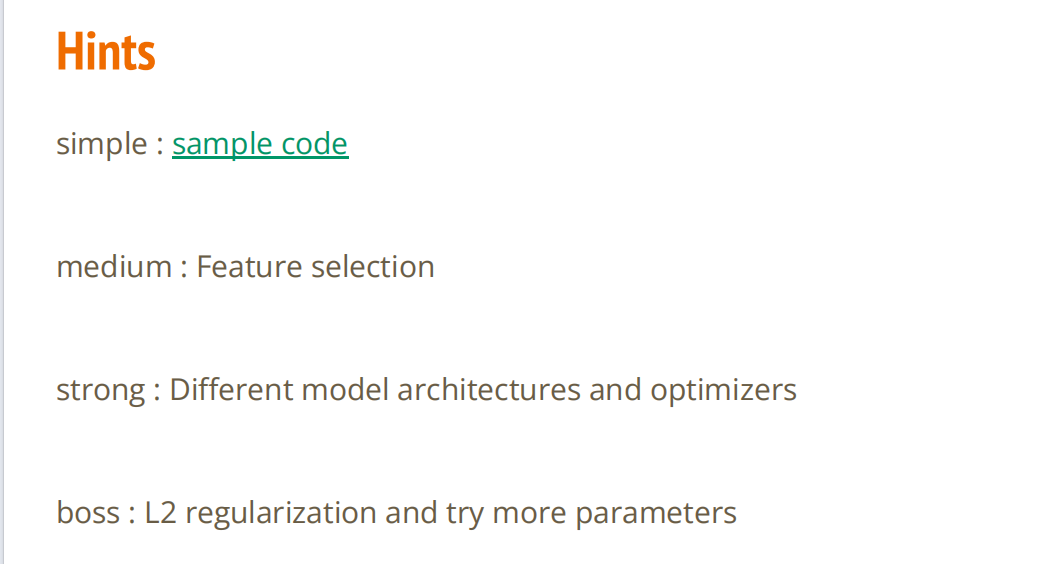

分为 simple baselinemedium 、strong、boss上一篇 : simple:https://editor.csdn.net/md/?articleId=134950253

分为 simple baselinemedium 、strong、boss上一篇 : simple:https://editor.csdn.net/md/?articleId=134950253

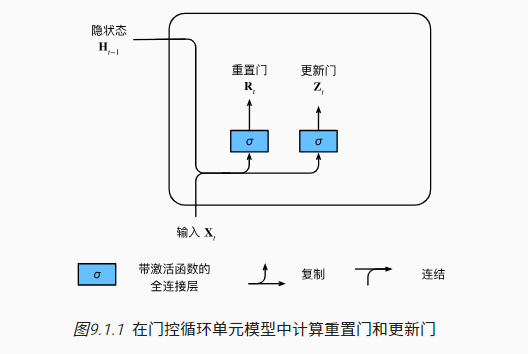

门控循环单元与普通的循环神经网络之间的关键区别在于: 前者支持隐状态的门控。这些机制是可学习的,并且能够解决了上面列出的问题。例如,如果第一个词元非常重要, 模型将学会在第一次观测之后不更新隐状态。同样,模型也可以学会跳过不相关的临时观测。最后,模型还将学会在需要的时候重置隐状态。下面我们将详细讨论各类门控。

embedding 过程中,神经网络的输入=单词,输出=输出 = 单词(作为邻居)的概率Q:怎么把调用模型API改为服务器部署好的大模型,另外知识库单个文件改为文件夹现在使用的是 dashscope 接口,我们也可以部署自己的大模型,通过 http serivce,按照dashscope/openai 接口进行返回内容server填写自己的 api url即可faiss。

embedding 过程中,神经网络的输入=单词,输出=输出 = 单词(作为邻居)的概率Q:怎么把调用模型API改为服务器部署好的大模型,另外知识库单个文件改为文件夹现在使用的是 dashscope 接口,我们也可以部署自己的大模型,通过 http serivce,按照dashscope/openai 接口进行返回内容server填写自己的 api url即可faiss。

分为 simple baselinemedium 、strong、boss上一篇 : simple:https://editor.csdn.net/md/?articleId=134950253

读取excel 文件时,python读取的文件路径,路径前多了-$,一直报错。原来是该文件被打开了,没有关掉。关掉该文件,重新读取,即成功了。