简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

图神经网络(Graph Neural Network,GNN)是一类用于处理图结构数据的深度学习模型。图结构数据中的实体以节点的形式表示,实体之间的关系以边的形式表示。GNN的目标是从图结构数据中学习有用的表示,并利用这些表示进行各种任务,例如节点分类、图分类、链接预测等。本文将详细介绍图神经网络的原理、数学公式、Python代码实现以及各部分的原理分析。内容将分为以下几个部分:一、图神经网络的基

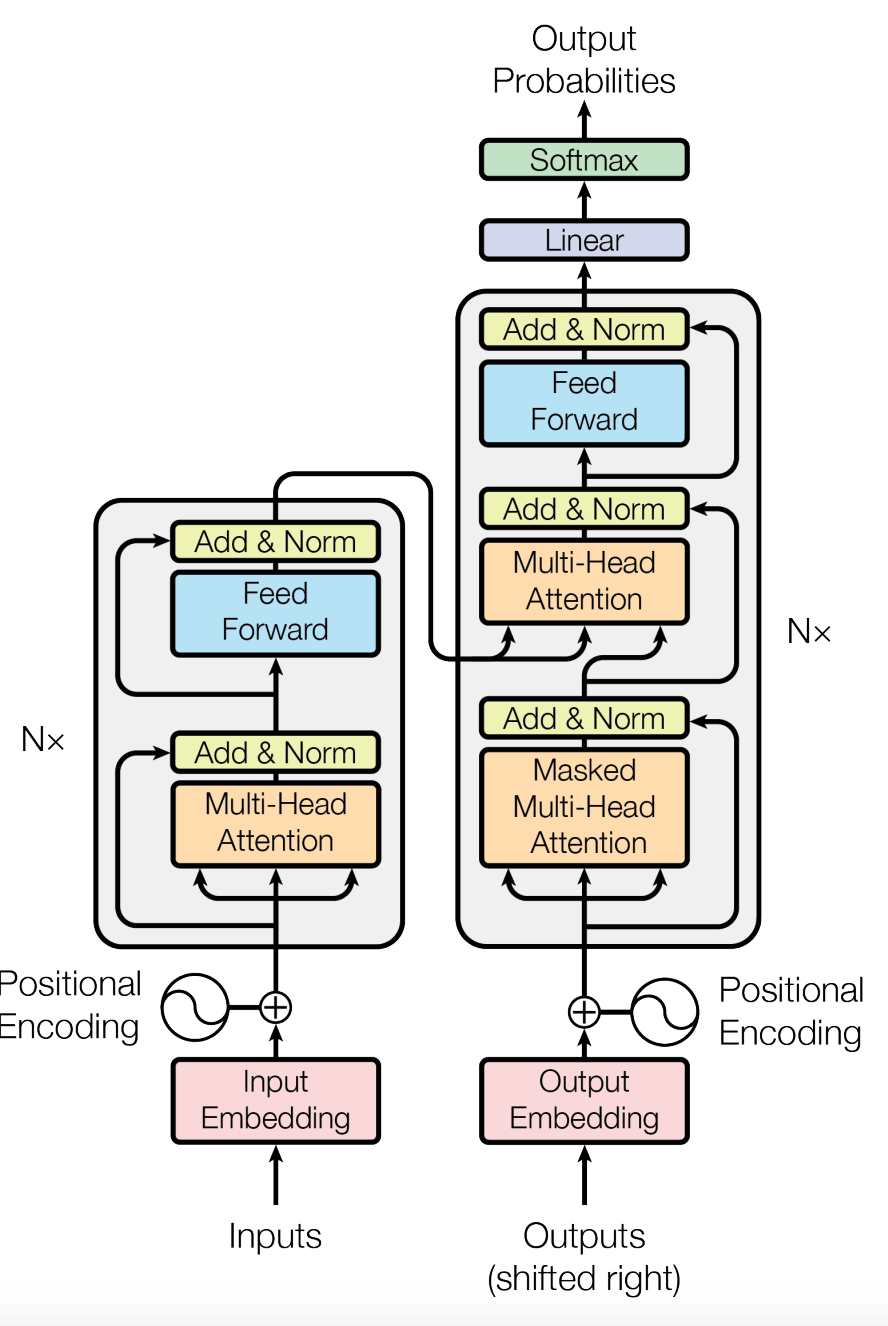

序列到序列(Seq2Seq)模型是一种端到端的深度学习模型,用于处理输入序列和输出序列的对应关系。Seq2Seq模型广泛应用于机器翻译、语音识别、文本摘要等任务。注意力机制(Attention Mechanism)是一种用于提升神经网络性能的技术,它允许模型在处理序列数据时关注输入序列中的某些部分。注意力机制在自然语言处理、计算机视觉和语音识别等领域有广泛应用。

图神经网络(Graph Neural Network,GNN)是一类用于处理图结构数据的深度学习模型。图结构数据中的实体以节点的形式表示,实体之间的关系以边的形式表示。GNN的目标是从图结构数据中学习有用的表示,并利用这些表示进行各种任务,例如节点分类、图分类、链接预测等。本文将详细介绍图神经网络的原理、数学公式、Python代码实现以及各部分的原理分析。内容将分为以下几个部分:一、图神经网络的基

GPT(Generative Pre-trained Transformer)是一种生成预训练模型,它使用Transformer模型的解码器部分进行预训练和微调。GPT模型在自然语言生成、文本分类、问答系统等任务中表现出色,并成为了许多先进模型的基础,例如GPT-2、GPT-3等。BERT(Bidirectional Encoder Representations from Transformer