简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

通过Qt+opencv,连接USB摄像头,将摄像头画面在界面上进行显示,主要思想是在Widget类中定义一个计时器,在计时结束时触发信号,连接至读取摄像头画面的槽函数对显示的QLabel进行更新。

1、基本概念:训练集,测试集,特征值,监督学习,非监督学习,半监督学习,分裂,回归2、概念学习:人类学习概念(婴儿):鸟,狗;车,房子;黑匣子和计算机定义:概念学习是指从有关某个布尔函数(是或否)的输入输出训练样例中推断出该布尔函数3、决定小明是否享受运动c(x)=1,当享受运动时;c(x)=0当不享受运动时,c(x)也可作为yx:每一个实例(每一行数据6个属性的值)X:样例,所有实例的集合学习目

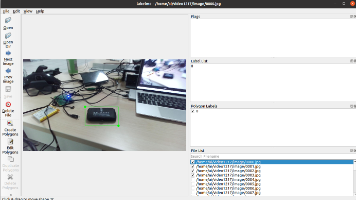

本文介绍了使用Yolov5训练自定义数据集并进行目标检测的全过程。主要内容包括:1)数据集制作,通过getframe.py提取视频帧图像,使用Labelme标注后转换为YOLO格式;2)训练阶段,配置yaml文件并运行train.py进行模型训练;3)推理测试,使用detect.py加载训练好的权重进行实时检测。文中提供了详细的代码实现和配置说明,展示了从视频帧提取到最终检测的全流程,包括Open

在win10平台,通过Qt5.12以及Dlib库,制作一个UI界面用于,实现人脸识别并统计现图像中人脸数量。该界面能够显示当前识别的图像,并显示当前图像中的人脸的个数。本实验目的在于,实现dlib库在win10平台的Qt上运行,不同于在python环境下的dlib库的使用,直接就能直接调用,非常简单便捷。在Qt(C++)中调用dlib,需要在相应的平台下先编译dlib源码,进行相关配置,在这之间还

在win10平台,通过Qt5.12以及Dlib库,制作一个UI界面用于,实现人脸识别并统计现图像中人脸数量。该界面能够显示当前识别的图像,并显示当前图像中的人脸的个数。本实验目的在于,实现dlib库在win10平台的Qt上运行,不同于在python环境下的dlib库的使用,直接就能直接调用,非常简单便捷。在Qt(C++)中调用dlib,需要在相应的平台下先编译dlib源码,进行相关配置,在这之间还

在win10平台,通过Qt5.12以及Dlib库,制作一个UI界面用于,实现人脸识别并统计现图像中人脸数量。该界面能够显示当前识别的图像,并显示当前图像中的人脸的个数。本实验目的在于,实现dlib库在win10平台的Qt上运行,不同于在python环境下的dlib库的使用,直接就能直接调用,非常简单便捷。在Qt(C++)中调用dlib,需要在相应的平台下先编译dlib源码,进行相关配置,在这之间还

Qt通过重新封装QPushButton类,实现自定义(异形)按钮,并且实现鼠标点击后的上下跳动特效,将QPushButton默认的方形按钮换为“AVIC”异形图标按钮,鼠标点击后先向下跳动20像素,然后再向上跳动20像素。......

1、基本概念:训练集,测试集,特征值,监督学习,非监督学习,半监督学习,分裂,回归2、概念学习:人类学习概念(婴儿):鸟,狗;车,房子;黑匣子和计算机定义:概念学习是指从有关某个布尔函数(是或否)的输入输出训练样例中推断出该布尔函数3、决定小明是否享受运动c(x)=1,当享受运动时;c(x)=0当不享受运动时,c(x)也可作为yx:每一个实例(每一行数据6个属性的值)X:样例,所有实例的集合学习目

在基于Qt做一个界面应用时,往往会出现在一个窗口中切换不同显示内容的需求,在显示A界面后,点击A界面上的按钮button_1将切换到B界面,点击B界面上的按钮button_2将返回A界面。有不少人通过窗体的A->hide()以及B->show()的手段进行切换,但这样做其实是新建了窗口,窗口的左上角的窗体名称发生变动,且由于窗口A的隐藏,以及窗口B的显示,会有一定程度的闪烁现象。本篇博客通过QSt

1、基本概念:训练集,测试集,特征值,监督学习,非监督学习,半监督学习,分裂,回归2、概念学习:人类学习概念(婴儿):鸟,狗;车,房子;黑匣子和计算机定义:概念学习是指从有关某个布尔函数(是或否)的输入输出训练样例中推断出该布尔函数3、决定小明是否享受运动c(x)=1,当享受运动时;c(x)=0当不享受运动时,c(x)也可作为yx:每一个实例(每一行数据6个属性的值)X:样例,所有实例的集合学习目