简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

ABSTRACT现有深度学习架构的局限性。

现象发生在某次 win10 更新之后。之前也尝试过如何禁止 win10 更新的操作,或许跟这些设置改动有关?不清楚。解决方案:1. 右键 点击任务栏的 windows标志,出现下面一些选项,选择 windows PowerShell (管理员)(A)。2. 此时会出现以下窗口,分别输入指令:输入:net localgroup Administrators /add networkservicene

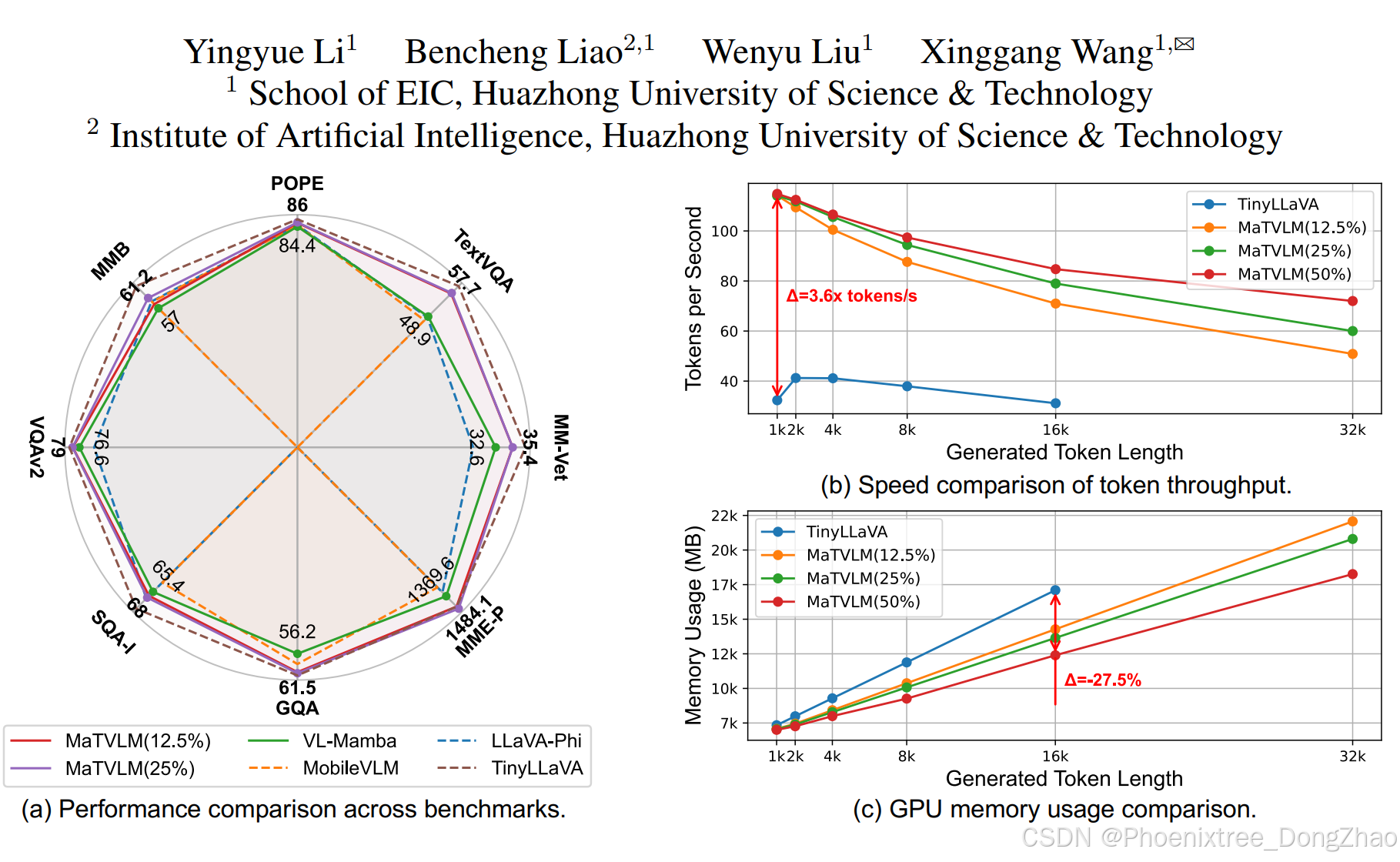

随着线性复杂度的RNN模型的发展,Transformer的二次复杂度挑战有望被克服。值得注意的是,新兴的Mamba-2展示了卓越的性能,缩小了RNN模型与Transformer之间的差距。值得注意的是,与大多数需要复杂多阶段训练的VLMs不同,。,将预训练的VLM作为教师模型,将知识迁移到MaTVLM中,进一步提升收敛速度和性能。通过利用预训练知识,本文的方法加速了收敛,提升了模型性能,并增强了

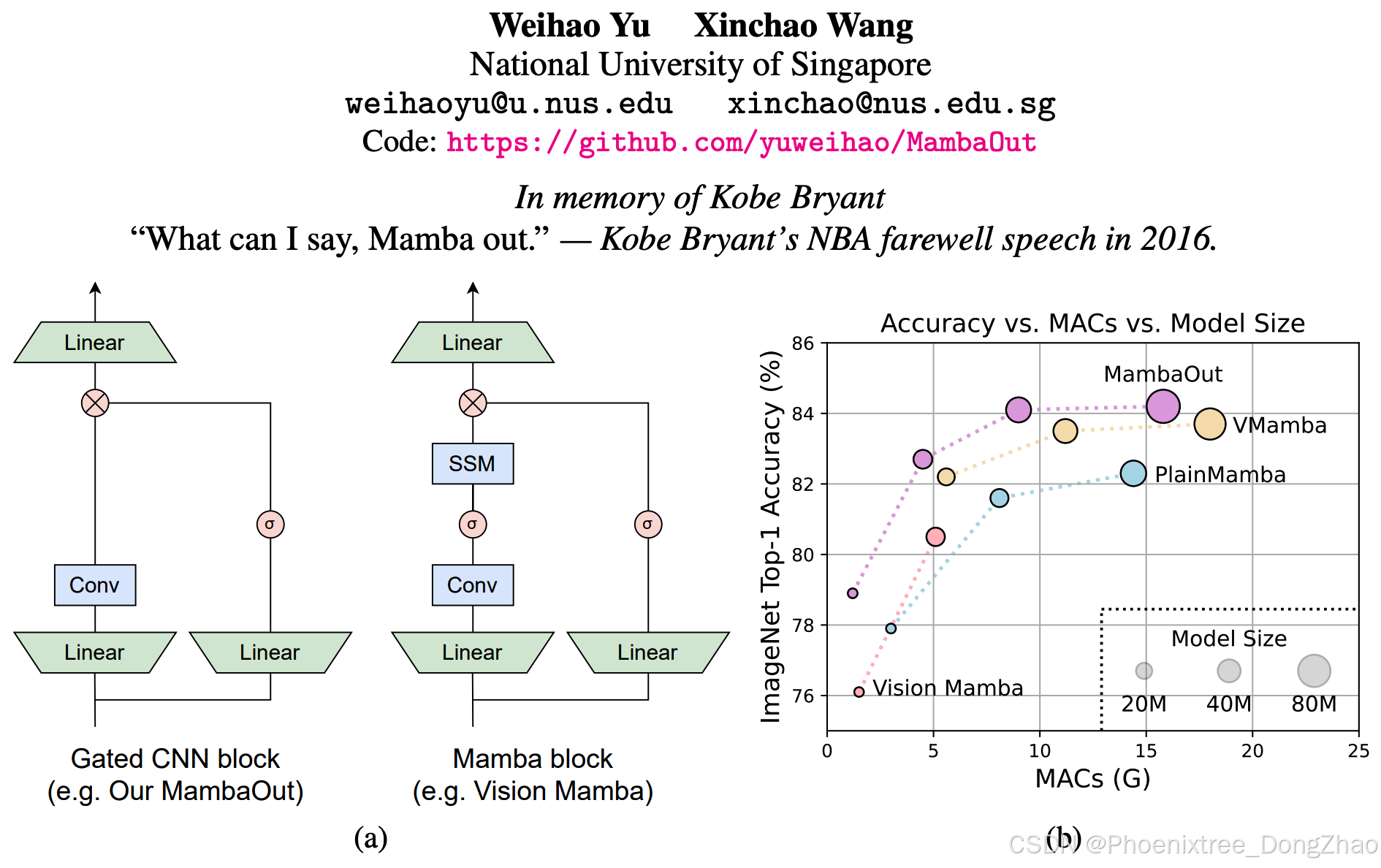

本工作声明, Mamba 对图像分类任务冗余,表现不如去除SSM的Mamab——MambaOut好;但在检测与分割任务中,MambaOut 无法匹敌前沿视觉 Mamba 模型,揭示 Mamba 在长序列视觉任务中的潜在价值。

AAAI 2020EEMEFN: Low-Light Image Enhancement via Edge-Enhanced Multi-Exposure Fusion NetworkMinfeng Zhu1 2∗, Pingbo Pan2 3†, Wei Chen1‡, Yi Yang21State Key Lab of CAD&CG, Zhejiang University2The R

cvpr2020 | 图像增强与恢复论文盘点[转自] https://www.cnblogs.com/yijun009/p/13223175.html有论文题目、代码和摘要,参考https://blog.csdn.net/moxibingdao/article/details/107054319,机翻,介意勿看。图像与视频增强(Image&Video Enhancement)零参考深度曲线

香浓信息量这里以连续随机变量的情况为例。设为随机变量X的概率分布,即为随机变量在处的概率密度函数值,随机变量在处的香农信息量定义为:这时香农信息量的单位为比特,香农信息量用于刻画消除随机变量在处的不确定性所需的信息量的大小。如果非连续型随机变量,则为某一具体随机事件的概率。为什么是这么一个表达式呢?想具体了解的可以参考如下的讨论:知乎-香农的信息论究竟牛在哪里?香农信息量_weixinhum-CS

Disentangled Image Generation Through Structured Noise InjectionYazeed Alharbi King Abdullah University for Science and Technology (KAUST) yazeed.alharbi@kaust.edu.saPeter WonkaKAUST本文提出了一个Structured

本文的核心动机是解决现有 MLLMs 在动态推理中的效率瓶颈。尽管混合专家(MoE)架构已被证明可以有效平衡模型容量与推理效率,但大多数研究集中于设计全新的稀疏模型,而非充分利用现有 MLLMs 的潜力。作者观察到,现有 MLLMs 的不同层对于不同样本的贡献存在显著差异,这表明其内部知识可能以类似 MoE 的方式分布。因此,探索如何在现有 MLLMs 中实现动态路由成为一项重要且具有挑战性的任务

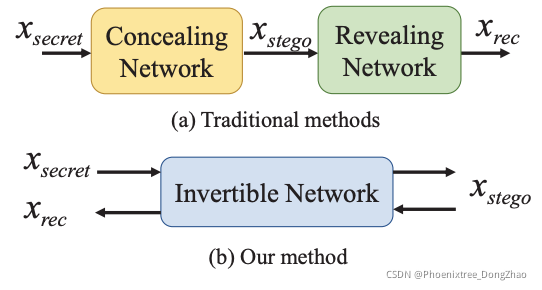

HiNet: Deep Image Hiding by Invertible Network[pdf] [github]Figure 1. The illustration of difference between our image hiding method and the traditional methods [5, 23, 32].AbstractImage hiding aims t