简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

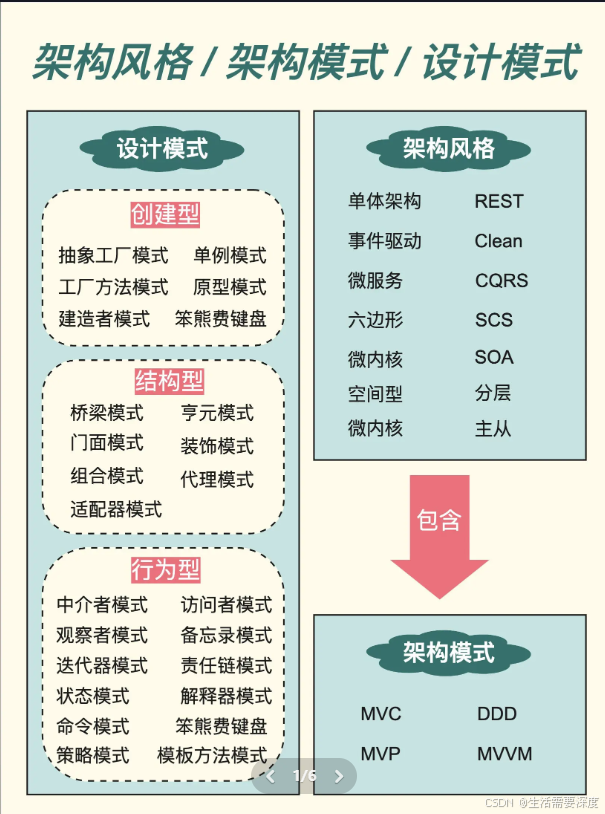

它描述了在特定上下文中,如何组织和设计软件系统的结构和组件之间的关系。架构模式提供了一套可重用的设计原则和指导,用于解决常见的架构问题。常见的软件架构模式有MVC模式、MVP模式、MVVM模式、黑板模式等。软件架构模式关注的是系统的结构和组件之间的关系,以及如何解决特定的设计问题。常见的设计模式包括单例模式、工厂模式、观察者模式、策略模式等。设计模式关注的是类和对象之间的关系和交互方式,以及如何实

DRAM 则提供了更大的存储空间,用于存储 GPU 计算所需的大量数据。如上图所示,最上面是共享的 L1 缓存,每个时钟周期可以执行 4 个 Warp 指令,下属 4 个独立的 Sub Core 的数据是不进行缓存的,但是每个 Sub Core 里有两个 Tensor Core, 这两个 Tensor Core 中的数据是可以共享的,再往下有一个共享内存,每个时钟周期可以传输 128B 的数据,当

函数说明:void cv::drawContours( InputOutputArray image, InputArrayOfArrays contours, int contourIdx, const Scalar &color, int thickness = 1, int lineType = LINE_8, InputArray hierarchy = noArray(), int ma

再次回到这张图,这张图的横轴的0.5,1.5,2,2.5表示几个标准差大小,0.5即0.5个标准差大小,具体数值等于0.5sigma。这个分布可以一直取值,不停地向两边延伸,但是分了方便计算以及精度的考量,当我们取-3sigma到3sigma区间内时,此时该段区间内占整个分布的99.8%,我们就大致认为该段分布已经包含了所有的情况。这9个点的权重总和等于0.4787147,如果只计算这9个点的加权

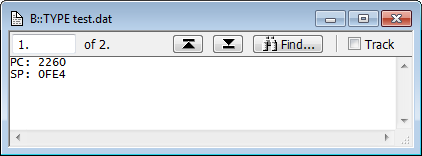

在每次启动 TRACE32 时,都会覆盖以前的自动启动日志文件,并生成一个新日志文件。块是命令的集合,这些命令始终同时执行。实际上,宏名称总是以一个符号(“&”)开头,后跟一系列字母(az、a-Z)、数字(0-9)和下划线符号(“&”)。双击 PRACTICE 宏(例如 &val1)会将其插入到 TRACE32 命令行中,您可以在其中修改 PRACTICE 宏的参数。双击 PRACTICE 宏(例

clock子系统在linux中属于一个比较简单,且容易理解的模块。时钟和电源是系统及各模块的基础,也是电源管理中比较重要的一部分。时钟对应着系统的动态功耗,会让各硬件IP做逻辑反转,从而带来能量消耗。涉及到时钟的电源管理主要是clk gate和调频,通过停止或者调整时钟做到:满足功能的前提下,尽可能减少功耗。时钟对于系统的作用就像心脏对于人的作用,可见时钟对系统的重要作用。

cpufreq driver提供调频调压的机制,cpufreq governor提供不同的策略,cpufreq core对通用的调频逻辑做抽象,为上层提供功能、接口封装,对下层调用抽象封装的硬件控制接口,此外,还借助频率电压对opp(operating performance points)功能,clk driver、regulator driver对频率及电压做时钟及电压的调整。但是仅调频的话,

文章目录前言一、巴特沃斯低通滤波器(BLPF)二、代码三、说明前言数字图像处理c++ opencv(VS2019 opencv4.53)持续更新一、巴特沃斯低通滤波器(BLPF)D 2 ( u , v ) 为 距 离 中 心 点 的 距 离 平 方 , D 0 为 设 置 半 径 , 通 过 n 的 值 来 调 整 滤 波 器 D^2(u,v)为距离中心点的距离平方,D_0为设置半径,通过n的值来

原文链接:https://blog.csdn.net/qq_44785013/article/details/121636545。

我们来看看主流的自动驾驶芯片的算力。理论上来说 training 和 inference 有类似的特征,但是以目前的情况来说,在运算量差别大,精度差别大,能耗条件不同和算法也有差别的情况下,training 和 inference 还是分开的状态。:在原始层把数据都融合在一起,融合好的数据就好比是一个超级传感器,而且这个传感器不仅有能力可以看到红外线,还有能力可以看到摄像头或者RGB,也有能力看到