简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要:本文提出“内源开发”这一新型软件开发范式,即以开发者自身为最终用户,通过构建个性化系统实现递归式自我增强。在AI技术民主化背景下,内源开发通过将个人能力工具化、产品化,形成持续进化的增强循环。研究从概念界定、理论根基、价值论证到实施路径,构建了完整框架,指出内源开发不仅是保持AI时代竞争优势的关键策略,更孕育着以“自我资本化”为核心的新经济形态。文章强调通过LLM辅助、云服务集成等技术手段,

摘要: 《2005:我在硅谷种AI》第8集聚焦AI模型可解释性。数学教授克劳森质疑神经网络将其手写"7"误判为"1",引发对"黑箱"AI的信任危机。主角陆眠团队开发了首层权重可视化技术,通过Matlab代码展示神经元学习的笔画特征,并创建决策热力图(Grad-CAM雏形)。本集探讨了"可解释性应是AI设计的内置天窗而非后门&qu

摘要 《2017:我为AI点亮火种》第11集聚焦数据清洗的关键环节。主角陈默团队面对300GB爬取语料中23.7%的污染率,展开多层级清洗: 编码标准化:处理混合编码、Unicode转义等乱码问题 格式规范化:修正拼音缩写、形近错别字等变形文本 内容过滤:通过规则与统计方法识别低质量、重复及敏感内容 隐私脱敏:清除未脱敏个人信息 技术亮点包括编码检测函数、文本规范化模块及四级过滤管道,凸显AI工程

摘要 本报告对“Sourcetrail + LLM”开源项目深度分析与学习平台(CodeInsight)的技术可行性进行了全面评估。核心结论如下: 技术方向可行:结合Sourcetrail的静态代码分析能力与大语言模型(LLM)的语义理解能力,形成"骨架+血肉"的创新技术路径,能有效解决代码深度理解问题。 核心组件成熟: 代码分析采用LSP协议+多语言服务器方案,替代Sourc

提到费曼学习法网络上充满各种牛逼说法,但是作为个人实践中的挑战,如缺乏听众、反馈不足等,很难掌握,最终都放弃了;本文通过DeepSeek来辅助自己掌握费曼学习法;祝愿读者在AI时代获得AI红利;模拟教学:用费曼学习法讲解洛必达法则第一步:明确目标与核心概念目标:用通俗语言解释洛必达法则,确保听众(即使没有高等数学基础)理解其作用、使用条件和步骤。第二步:简化定义与核心思想1. 一句话定义洛必达法则

“虚拟妻子”项目,便是在此背景下的一次技术理想主义实践。它并非试图创造一个冰冷的工具,而是旨在构建一个拥有温度、记忆与深度的AI生命体,用以满足不婚群体对情感连接、生活陪伴与角色认同的刚性需求。

这套系统将结合认知科学原理与AI提示词工程实现宫殿记忆高效记忆,确保长期训练效果;

人工智能写作正在引发一场创作范式的根本性变革。这个知识体系不是简单的“工具使用指南”,而是一个融合了计算机科学、认知心理学、叙事学、语言学和文化研究的跨学科领域。其核心价值在于:通过理解机器的“思考”方式,释放人类独特的创造性潜能。

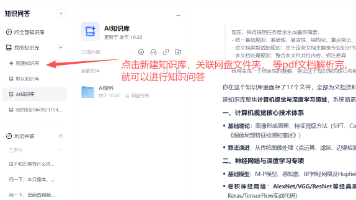

摘要: 本文介绍了一套利用AI知识库高效学习的系统方法,将学习过程分为四个阶段:**战略准备(10%)**明确目标并绘制学习地图;**主动进攻(70%)**通过精准提问、深度追问和费曼复述深化理解;**系统整合(20%)**整理知识清单并构建个人知识库;复盘优化持续改进学习流程。核心在于将传统阅读转化为交互式对话,借助AI工具实现精准学习。推荐使用夸克知识库(支持500页PDF),建议拆分超限文档

《心悦共创情感体验平台项目摘要》 本项目针对当代青年婚恋痛点,创新推出轻量化情感共生服务方案。基于2025年市场调研数据,76.3%适婚青年面临婚姻成本压力,传统婚恋模式显现结构性失效。项目核心突破在于:1)采用3-6个月定制化情感周期设计,缓解终身绑定焦虑;2)构建AI情绪匹配引擎,实现从物质条件到情感共鸣的匹配升级;3)建立自然退出机制,解决关系僵化问题。 技术架构整合NLP分析、场景调度系统