简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

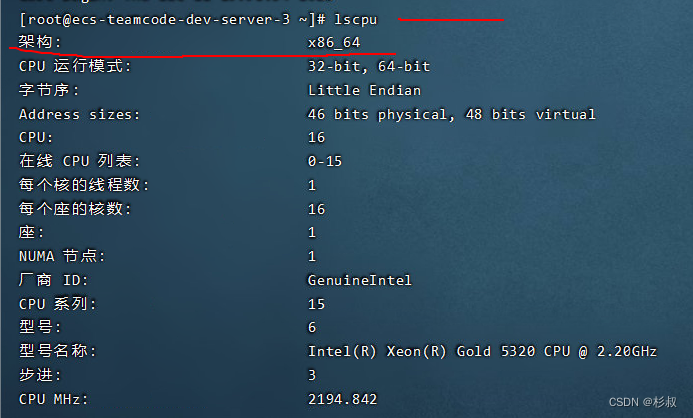

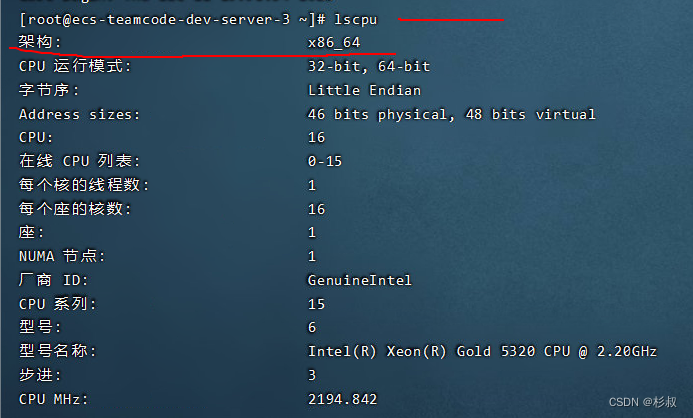

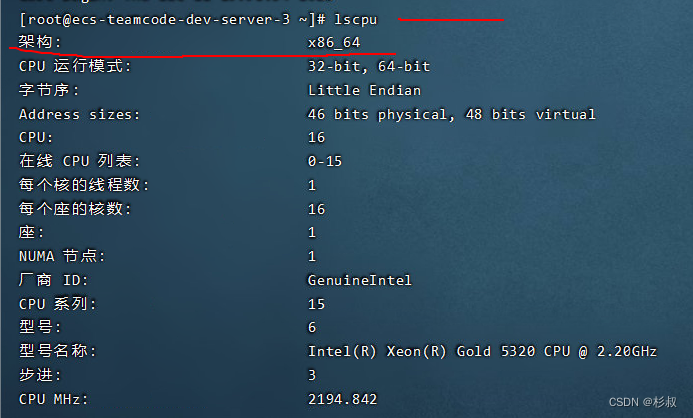

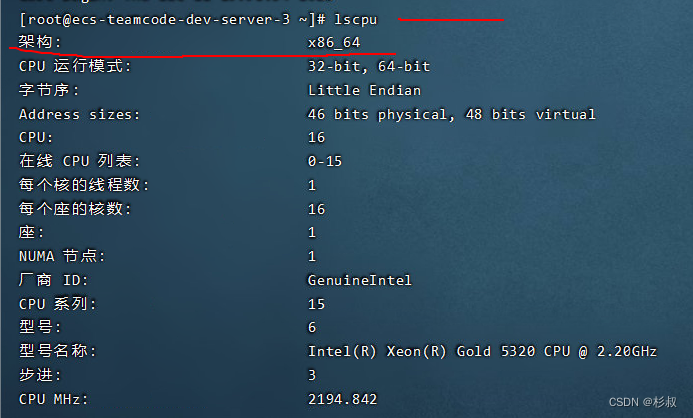

在线安装地址https://ollama.com/download选择服务器系统,按照步骤完成安装。下载地址 https://github.com/ollama/ollama/releases/总共需要修改两个点,第一:Ollama下载地址;第二:Ollama安装包存放目录。我下载的是Ollama的v0.1.31版本,后面均以此版本为例说明。修改后的install.sh文件,v0.1.31版本。第

下载qwen3-8b的模型,下载完成后拷贝到内网服务器。

在线安装地址https://ollama.com/download选择服务器系统,按照步骤完成安装。下载地址 https://github.com/ollama/ollama/releases/总共需要修改两个点,第一:Ollama下载地址;第二:Ollama安装包存放目录。我下载的是Ollama的v0.1.31版本,后面均以此版本为例说明。修改后的install.sh文件,v0.1.31版本。第

org.springframework.data.redis.RedisConnectionFailureException: java.net.SocketException: Connection reset; nested exception is redis.clients.jedis.exceptions.JedisConnectionException: java.net.Socket

docker环境安装mysql8.0

在docker上安装gitlab。

下载qwen3-8b的模型,下载完成后拷贝到内网服务器。

【代码】springboot3.0集成spring authorization server1.2.0启动报错。

在线安装地址https://ollama.com/download选择服务器系统,按照步骤完成安装。下载地址 https://github.com/ollama/ollama/releases/总共需要修改两个点,第一:Ollama下载地址;第二:Ollama安装包存放目录。我下载的是Ollama的v0.1.31版本,后面均以此版本为例说明。修改后的install.sh文件,v0.1.31版本。第

在线安装地址https://ollama.com/download选择服务器系统,按照步骤完成安装。下载地址 https://github.com/ollama/ollama/releases/总共需要修改两个点,第一:Ollama下载地址;第二:Ollama安装包存放目录。我下载的是Ollama的v0.1.31版本,后面均以此版本为例说明。修改后的install.sh文件,v0.1.31版本。第