简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

CSDN不能搜自己的博客太难受了,就是能简单contains都行啊,被迫把自己的list都列在这,下次直接在这个页面find就行git merge和git rebase的区别和反思STL源码剖析——deque的实现原理和使用方法详解poj 2420 广义费马点Powershell 美化笔记Pycharm 关闭文件右侧检查 disable the highlighting level fo...

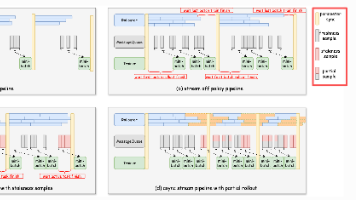

来自RollPacker:Mitigating Long-Tail Rollouts for Fast,Synchronous RL Post-Training。

关于dropout的问题,其实还真有人研究过,让他的不一致行为分布变得一致,也就是alpha dropout,但这玩意,也只是尽力而已,现在很多框架已经把把这个放进去了,但大家用的还是不多,在一致性和效率,稳定性上多多少少还有些问题,或者按下葫芦起了瓢。比如回归等数值和分布敏感的问题上,有两个经典的trick,一个是标签转换(把销量预测的值域转换到0到1,这玩意连lightgbm都有用),一个就是

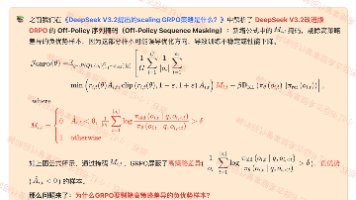

转载自 https://www.zhihu.com/question/588325646/answer/3357252612?

转载自https://arxiv.org/pdf/2512.02556

系统性解决幻觉需构建“数据-模型-知识-评估”的闭环:通过RAG和CoT增强事实性,动态知识库减少信息滞后,多智能体路由提升专业性,解码控制抑制语义漂移。未来需进一步探索模型自我纠错能力与跨模态证据融合,以实现更高可靠性。要系统性解决大模型的“幻觉”问题(即生成看似合理但实际错误的信息),需从数据优化、模型训练、知识管理、推理控制等多层面构建闭环解决方案。

本文比较了vLLM和HuggingFace在语言模型推理时的输出差异。代码首先使用vLLM生成文本并记录token概率,然后使用HuggingFace Transformers重新计算相同输入的logits。通过对比两者的logprobs和概率值,发现存在一定差异:在概率低于0.9时,相对误差可能超过10%。统计结果显示,vLLM与HuggingFace之间的logprob相对误差均值约为0.00

常用的CoT(Chain-of-Thought,思维链)方法通过引导大语言模型生成中间推理步骤,显著提升了复杂任务的解决能力。

Lexical Retrieval:给定一个文本,获取语言模型最后一层上所有位置的隐状态,每个位置对应原始文本中的一个token,依次将每个位置的隐状态通过一个全连接层+Relu函数得到该token的权重,将所有每个token的隐状态*对应的权重再求和作为文本的稀疏表征(如果文本包含两个以上相同的token,则该token的权重取其中最大的权重值)。很熟悉的感觉吧,很像tfidf,也跟RetroM

PRM的核心创新在于通过逐步骤反馈优化模型推理路径,而ORM更注重最终结果的质量评估。当前研究趋势聚焦于降低PRM的标注成本(如隐式学习、自动标注)和提升ORM的稀疏信号利用效率。未来方向可能包括多模态PRM、动态奖励调整机制,以及面向工业场景的端到端优化框架。如需具体论文链接或进一步解读,可参考上述文献的原始出处。