简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

凌晨3点的机房里,李鸣盯着屏幕上刺眼的红色报错提示,手心全是冷汗——他的团队耗时两个月训练的金融大模型,在第17天突然崩了。当李鸣的团队在80G显存的服务器上加载130B参数的模型时,还没意识到问题所在。——他们的服务器使用PCIe 4.0互联,实际传输带宽仅64GB/s,而采用NVLink3.0的机器带宽高达600GB/s。「我们以为买了最好的显卡,却栽在最基础的连接器上。某自动驾驶公司升级到N

作为从业者,我们既要拥抱技术红利,更需警惕潜在风险,在创新与合规的平衡中,共同开启人机共生的新纪元。:聚焦制造业,为汽车厂商提供 “预测性维护 + 供应链优化” 双引擎 Agent,设备停机时间减少 58%,库存周转率提升 35%。:提出 “AIOS” 操作系统级整合方案,在医疗影像分析中通过视频 - 文本 - 代码混合推理,诊断准确率较传统方法提升 37%。:某金融机构建立 “人机协作 SOP”

Manus未必是“下一个DeepSeek”,但它标志着AI技术从认知智能迈向行动智能的关键一步。正如海尔周云杰所言:“所有行业都将被AI重塑”,DeepSeek与Manus的并存,恰恰证明了中国AI生态的多样性。从简历筛选到旅行规划,从股票分析到PPT制作,Manus以通用型AI Agent的定位,试图重新定义人机协作的边界。,通过降低算力成本(仅为传统架构的十分之一),推动AI技术的普惠化。,通

32B - 70B 参数量的模型,已经属于大型模型的范畴,对硬件的要求也随之大幅提升,其中32B的模型需要一张4090,而70B模型则需要2张4090。让我们一起深入探究一下。对于小企业而言,可以考虑部署deepseek70b的版本,成本大概在7-10w左右,而70b以下的本地部署意义不大,还不如直接到官网访问网络版本的,针对中大型企业则是可以考虑部署671b版本的,成本估计在100w,也能承受,

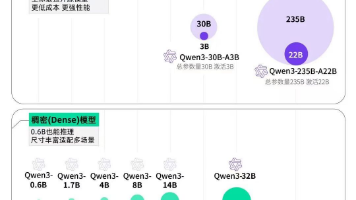

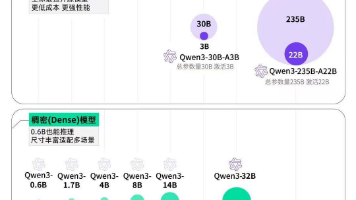

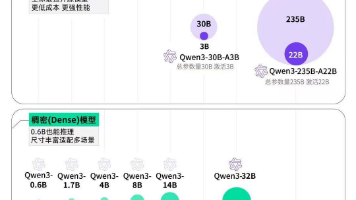

支持多步推理,通过“思维链”逐步拆解复杂问题。实测中,Qwen3-235B-A22B在解答“如何将2米长的甘蔗搬入1.5米宽的门”时,通过三维建模推导出“倾斜甘蔗使其对角线小于门宽”的方案,逻辑严谨性媲美人类专家。:包含2款MoE模型(30B/235B)和6款Dense模型(0.6B/1.7B/4B/8B/14B/32B),满足科研、移动端、企业级等多样化需求。:输入一段描述“星空下的城堡”的文字

Qwen-3 的发布标志着 AI 服务器选型从「算力竞赛」转向「价值驱动」:性能优先:H100 / 昇腾 910B 仍是千亿参数训练的首选,但需配套液冷和异构计算。成本敏感:CPU 推理服务器 + 混合架构可满足 80% 的企业需求,初期投资降低 60%。长期布局:边缘计算、绿色算力和端侧智能是未来三大方向,企业需提前规划技术路线。建议结合 Qwen-3 的混合推理特性,优先选择经过市场验证的解决

如FP16和FP32主要用于人工智能的训练阶段,而FP16和INT8主要用于人工智能的推理阶段,因此我们要关注的算力指标是不一样的,又比如一些计算卡如A100,它的FP16指标和RTX4090差不多,但是它有专门用于深度学习的TF16指标,这个速度就比4090快很多了。计算能力:决定了你训练模型的速度,你是花4个小时才能跑完模型还是得花8个小时甚至更久,常见的有FP16、FP32、TF16等这些指

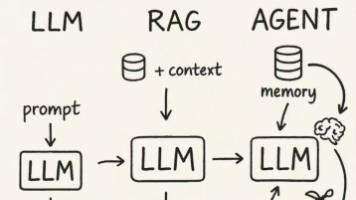

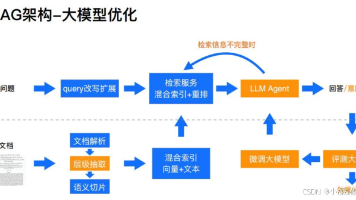

从Token的经济账到RAG的精准性,从量化的效率革命到智能体的自动化突破,这些术语背后折射出AI技术的演进逻辑。对于从业者而言,理解这些概念不仅是技术对话的入场券,更是设计产品、评估方案、洞察趋势的关键。:Token是AI处理文本的最小单位,相当于自然语言中的“字词片段”。:大模型“蒸馏”技术是把大语言模型中的能力和知识迁移到更小的模型的技术,目的是在于构造出来资源高效和性能优异的小模型,未经过

Qwen-3 的发布标志着 AI 服务器选型从「算力竞赛」转向「价值驱动」:性能优先:H100 / 昇腾 910B 仍是千亿参数训练的首选,但需配套液冷和异构计算。成本敏感:CPU 推理服务器 + 混合架构可满足 80% 的企业需求,初期投资降低 60%。长期布局:边缘计算、绿色算力和端侧智能是未来三大方向,企业需提前规划技术路线。建议结合 Qwen-3 的混合推理特性,优先选择经过市场验证的解决

然而因为访问人数过多,deepseek的服务器有时候相应不过来,因此把它部署到本地,以便获得更好的体验,作为一名ai爱好者,我最近尝试在单卡和双卡NVIDIA RTX 4090上本地部署了DeepSeek70B,并对其效果进行了实测。这个速度很一般,基本不能使用,生成一篇300字的短文,大概要1分多钟,远远赶不上官方生成的速度。:版本为≥2.0,这是一个基于 Python 的科学计算包,广泛应用于