简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

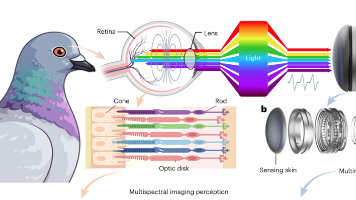

在机器人领域,“触觉”一直是个棘手的难题:传统传感器要么分辨率低到摸不清纹理,要么只能测压力却辨不出温度。近日,清华大学丁文伯团队联合无界智航(Xspark AI)及多所国内外科研机构在《Nature Sensors》上发表的,直接打破了这个僵局——借鉴鸽子的多光谱视觉原理,把多光谱成像、摩擦电传感、惯性测量揉进,不仅能精准识别纹理、材质、温度,还能预判碰撞和滑动,分类准确率超94%。

在机器人领域,“触觉”一直是个棘手的难题:传统传感器要么分辨率低到摸不清纹理,要么只能测压力却辨不出温度。近日,清华大学丁文伯团队联合无界智航(Xspark AI)及多所国内外科研机构在《Nature Sensors》上发表的,直接打破了这个僵局——借鉴鸽子的多光谱视觉原理,把多光谱成像、摩擦电传感、惯性测量揉进,不仅能精准识别纹理、材质、温度,还能预判碰撞和滑动,分类准确率超94%。

这并非追求那种“时而惊艳、时而失效”的演示性智能,而是构建一种趋近工程系统的智能特质:遇到分布外能自救,遇到遮挡能重建,遇到风险能收敛,遇到失败能把失败变成下一轮的训练数据。假设我们有足够强的验证手段,能把这个模块丢进各种地形、光照、传感器噪声、不同机器人平台里跑一轮,进而将暴露出的失败案例持续纳入回归测试集予以追踪和修复,该领域的进步无疑需要新的模型、新的策略、新的世界模型。然而,当我们将同样的

这并非追求那种“时而惊艳、时而失效”的演示性智能,而是构建一种趋近工程系统的智能特质:遇到分布外能自救,遇到遮挡能重建,遇到风险能收敛,遇到失败能把失败变成下一轮的训练数据。假设我们有足够强的验证手段,能把这个模块丢进各种地形、光照、传感器噪声、不同机器人平台里跑一轮,进而将暴露出的失败案例持续纳入回归测试集予以追踪和修复,该领域的进步无疑需要新的模型、新的策略、新的世界模型。然而,当我们将同样的

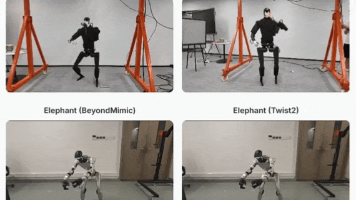

Deep Whole-body Parkour 提供了一个“如何让机器人既会做精细全身动作,又能适应环境变化”的可行路径。以前的人形控制,要么是“感知强、动作弱”,要么是“动作强、感知弱”,这次的融合思路,其实更贴近人类的运动模式——我们做跑酷动作时,也是边看障碍物边调整手、脚的位置,而不是先背一套动作再硬套。当然,这条融合路径未来要走的路还很长:比如如何让机器人自主选择动作?如何处理弹性、可变形

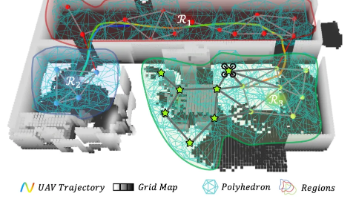

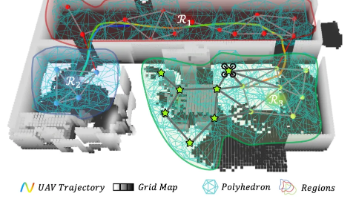

值得注意的是,论文将“变形状态”和“飞行模型”统一纳入系统建模中,使机器人在抓取物体、受到外界干扰时,依然能够保持稳定飞行,这是后续复杂操作能够顺利完成的关键基础。无人机执行一些飞行巡航任务,已经很成熟了,航拍、测绘、巡检,几乎成了默认工具,在第一项工作之中,无人机甚至能够找到我们所需要的物体。不同于常见的体素地图或稠密点云,这里使用的是一种基于 多面体扩展 的方法:无人机在局部占据栅格中,以当前

值得注意的是,论文将“变形状态”和“飞行模型”统一纳入系统建模中,使机器人在抓取物体、受到外界干扰时,依然能够保持稳定飞行,这是后续复杂操作能够顺利完成的关键基础。无人机执行一些飞行巡航任务,已经很成熟了,航拍、测绘、巡检,几乎成了默认工具,在第一项工作之中,无人机甚至能够找到我们所需要的物体。不同于常见的体素地图或稠密点云,这里使用的是一种基于 多面体扩展 的方法:无人机在局部占据栅格中,以当前

BitNet b1.58 2B4T 不仅是一款模型,更是一场范式革命。它让 AI 走进资源受限的边缘设备,助力中小企业与个人开发者拥抱先进技术;能耗降低 90%,为绿色 AI 树立标杆;开源生态降低技术门槛,激发全球创新。这款模型质疑了全精度权重的必要性,或将引领模型压缩新潮流。未来,BitNet b1.58 有望向更大规模扩展,支持多语言和多模态任务,结合专用硬件释放更大潜力。尽管在知识任务和硬

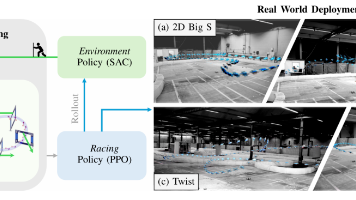

在控制层面,可微分仿真与强化学习的结合显著提升了四足与飞行机器人在极端动态下的适应性;实验证明,该框架在训练速度上实现了7倍以上的提升,且仅需不到20%的样本量即可在分钟级时间内完成基于纯视觉特征的四足平稳控制,成功实现了从仿真到真实世界的零样本迁移。该方法通过将可微MPC嵌入Actor-Critic架构,利用RL自动学习MPC的代价函数,有效解决了模型失配和复杂任务描述的难题,在保持RL灵活性的

▲真机实验演示,也是最关键的落点:H-GPT 在 4090 工作站上把语言指令变成全身动作,再经过动作重定向交给机器人,机器人端由 H-ACT 控制策略负责把动作“做稳”。,靠H-GPT的 CoT 推理把模糊指令,转化为人体动作序列;FRoM-W1 用 H-GPT 解决“语言到全身动作”的生成问题,用 H-ACT 解决“动作到真实稳定执行”的落地问题,并开源整套系统。,模型在给定指令后,会先产出