简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

我们使用DeepSeek在线服务的时候,经常会遇到服务器忙的情况,非常影响体感和效率。为了解决这个问题,我们部署DeepSeek本地模型,通过Ollama提供API支持、Chatbox提供UI界面,实现断网也能使用DeepSeek!

Stable diffusion是一个基于 Latent Diffusion Models(潜在扩散模型,LDMs)的文图生成(text-to-image)模型。具体来说,得益于 Stability AI 的计算资源支持和在 LAION-5B 的一个子集数据支持训练,用于文图生成。Latent Diffusion Models 通过在一个潜在表示空间中迭代“去噪”数据来生成图像,然后将表示结果解码

上一篇博文我们学习了Stable Diffusion的原理,这一篇我们继续深入了解Stable Diffusion的应用实践和分析。

在人工智能和机器学习领域,生成模型的应用越来越广泛。Stable Diffusion 作为其中的佼佼者,因其强大的图像生成能力而备受关注。今天,我的开源项目 **Dive Into Stable Diffusion v3.5** 已经正式发布!这个项目旨在总结我在开发过程中所学到和用到的知识和工具,同时帮助其他开发者更好地理解和应用 Stable Diffusion v3.5 模型。目前,项目提供

本文详细介绍HunyuanVideo的部署、应用以及源码分析。不得不说,生成的视频很真实生动!

强化学习(Reinforcement Learning, RL)是一种智能体在与环境互动过程中,通过试错和奖励机制学习如何达成目标的算法。在这个过程中,智能体会不断探索环境,采取行动,并根据环境反馈的奖励或惩罚调整自己的行为策略,最终学习到最优策略。因此,反复实验(trial and error)和延迟奖励(delayed reward)是强化学习最重要的两个特征。

RAG(Retrieval-Augmented Generation,检索增强生成) 是一种结合了信息检索技术与语言生成模型的人工智能技术,该技术通过从外部知识库中检索相关信息,并将其作为提示(Prompt)输入给大型语言模型(LLMs),以增强模型处理知识密集型任务的能力,如问答、文本摘要、内容生成等。RAG模型由Facebook AI Research(FAIR)团队于2020年首次提出,并迅

Tokenization(分词) 在自然语言处理(NLP)的任务中是最基本的一步,把文本内容处理为最小基本单元即token 用于后续的处理。如何把文本处理成token呢?有一系列的方法,基本思想是构建一个词表通过词表一一映射进行分词,构建合适的词表。

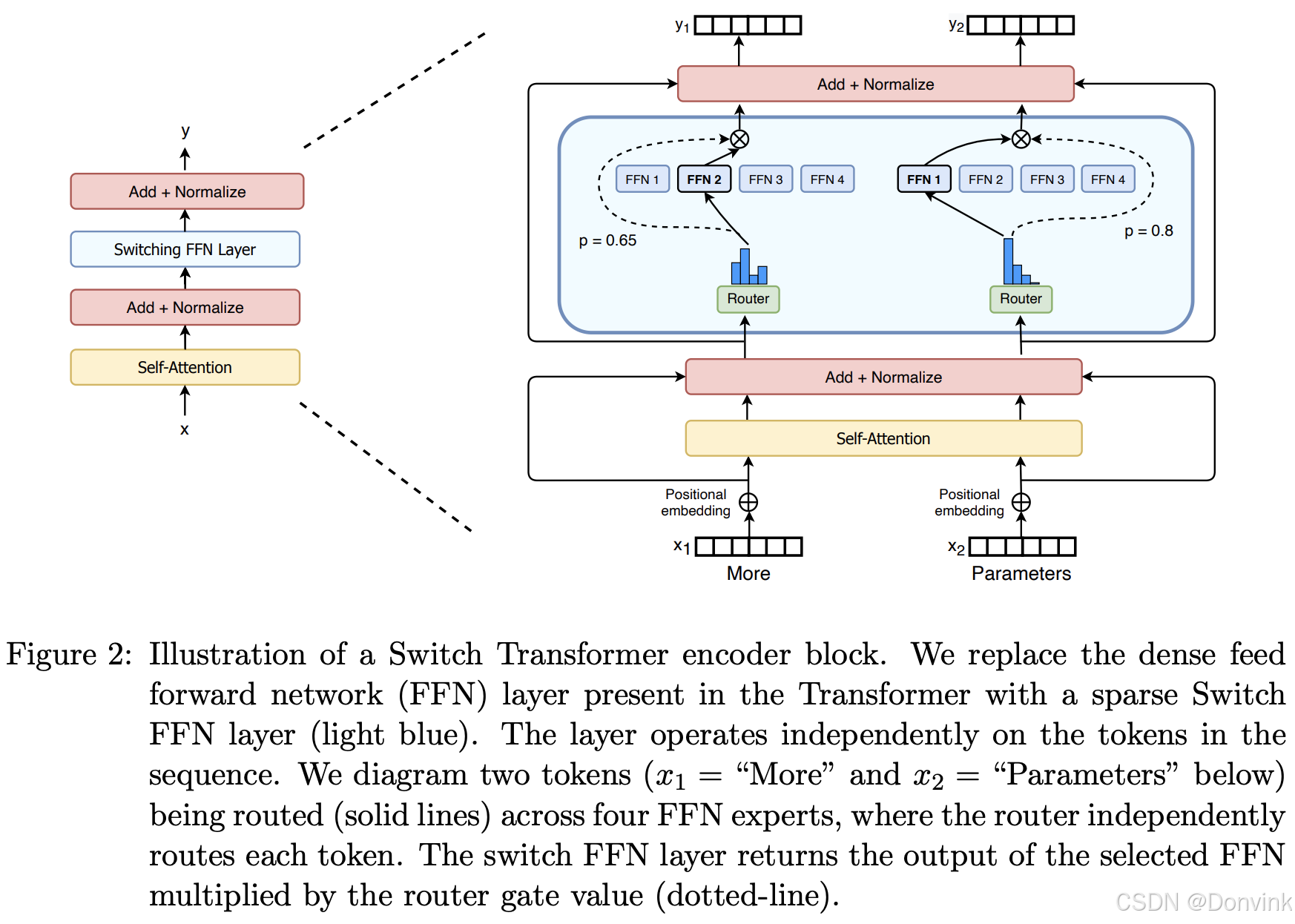

模型规模是提升模型性能的关键因素之一。在有限的计算资源预算下,用更少的训练步数训练一个更大的模型,往往比用更多的步数训练一个较小的模型效果更佳。混合专家模型 (Mixed Expert Models,简称 MoEs) 的一个显著优势是能够在远少于稠密模型所需的计算资源下进行有效的预训练。这意味着在相同的计算预算条件下,可以显著扩大模型或数据集的规模。特别是在预训练阶段,与稠密模型相比,混合专家模型

在 AI 训练中,“冷启动”(Cold Start) 这个概念类似于刚买了一部新手机,开机后发现什么都没有,必须先安装应用、下载数据,才能正常使用。DeepSeek-R1 的训练过程也类似,如果直接用强化学习(RL)进行训练,那么 AI 一开始就会像一个“什么都不会的孩子”,不断犯错,生成一堆毫无逻辑的答案,甚至可能陷入无意义的循环。为了解决这个问题,研究人员提出了“冷启动数据”的概念,即在 AI