简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

下载d2lzh_pytorch直接百度云:链接:https://pan.baidu.com/s/1ndV7qloDG7vIGrZmEdasWw提取码:hwn4将文件夹 d2lzh_pytorch 【记住这个是 小写 L 不是 数字 1 】 放到anaconda 你自己创建的环境下:C:\ProgramData\Anaconda3\envs\pytorchzc\Lib\site-packages重点

下载d2lzh_pytorch直接百度云:链接:https://pan.baidu.com/s/1ndV7qloDG7vIGrZmEdasWw提取码:hwn4将文件夹 d2lzh_pytorch 【记住这个是 小写 L 不是 数字 1 】 放到anaconda 你自己创建的环境下:C:\ProgramData\Anaconda3\envs\pytorchzc\Lib\site-packages重点

文章目录1. 保存模型 - 权重参数2. 保存模型 - 整个模型3. 保存模型 - checkpoints1. 保存模型 - 权重参数2. 保存模型 - 整个模型3. 保存模型 - checkpoints

因各种原因导致在 anaconda 自创的虚拟环境中输入命令 pip install pandas ,苦等了半个小时还是无法安装,网上一顿狂搜后发现,输入 :pip --default-time=100 install pandas 这个命令后,效果还行,希望大家试试。...

文章目录1. True 和 False1. True 和 False我们可以通过true和false 来抽取矩阵中的元素抽取相关位置的元素,放在一个张量中import torchinput = torch.arange(9).reshape(3, 3)print(f"input_before={input}")# 定义一个跟input相同大小的矩阵,True表示提取,False表示不用处理mask

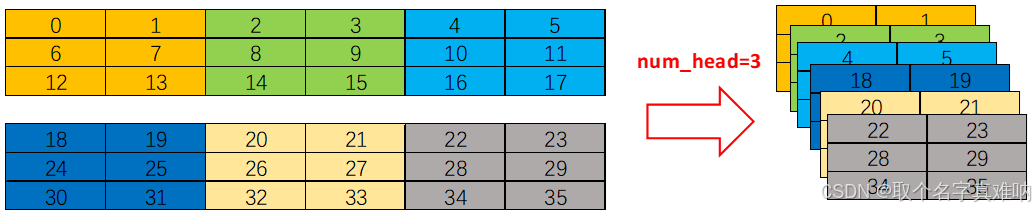

在transformer中我们需要将自注意力q,k,v进行注意力attention计算,但有时候,我们用一个行向量表示一个样本的时候,发现行向量太长了,这样整体的计算匹配机制比较差,为了提高注意力匹配率,我们引入了多头注意力。

文章目录1. Transformer的特点2. Transformer的使用类型3. Transformer的结构1. Transformer的特点1.1 无先验假设(例如无局部关联性假设,无有序建模)1.2 核心计算在于自注意机制,呈现平方复杂度1.3 数据量的要求与先验假设的程度成反比2. Transformer的使用类型2.1 Encoder Only : Bert , 分类任务,非流式任务

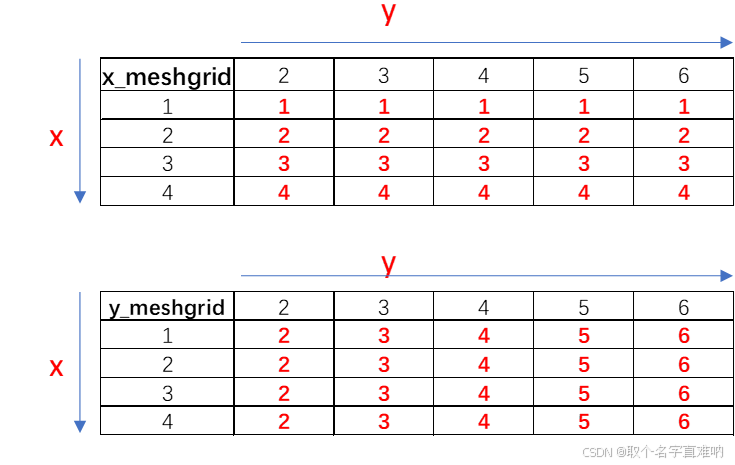

x_meshgrid,y_meshgrid=torch.meshgrid(x_tensor,y_tensor) 函数的功能是根据x_tensor,y_tensor来生成网格矩阵x_meshgrid,y_meshgrid,注意这里的x_tensor和y_tensor的方向和实际方向相反,具体如下描述。

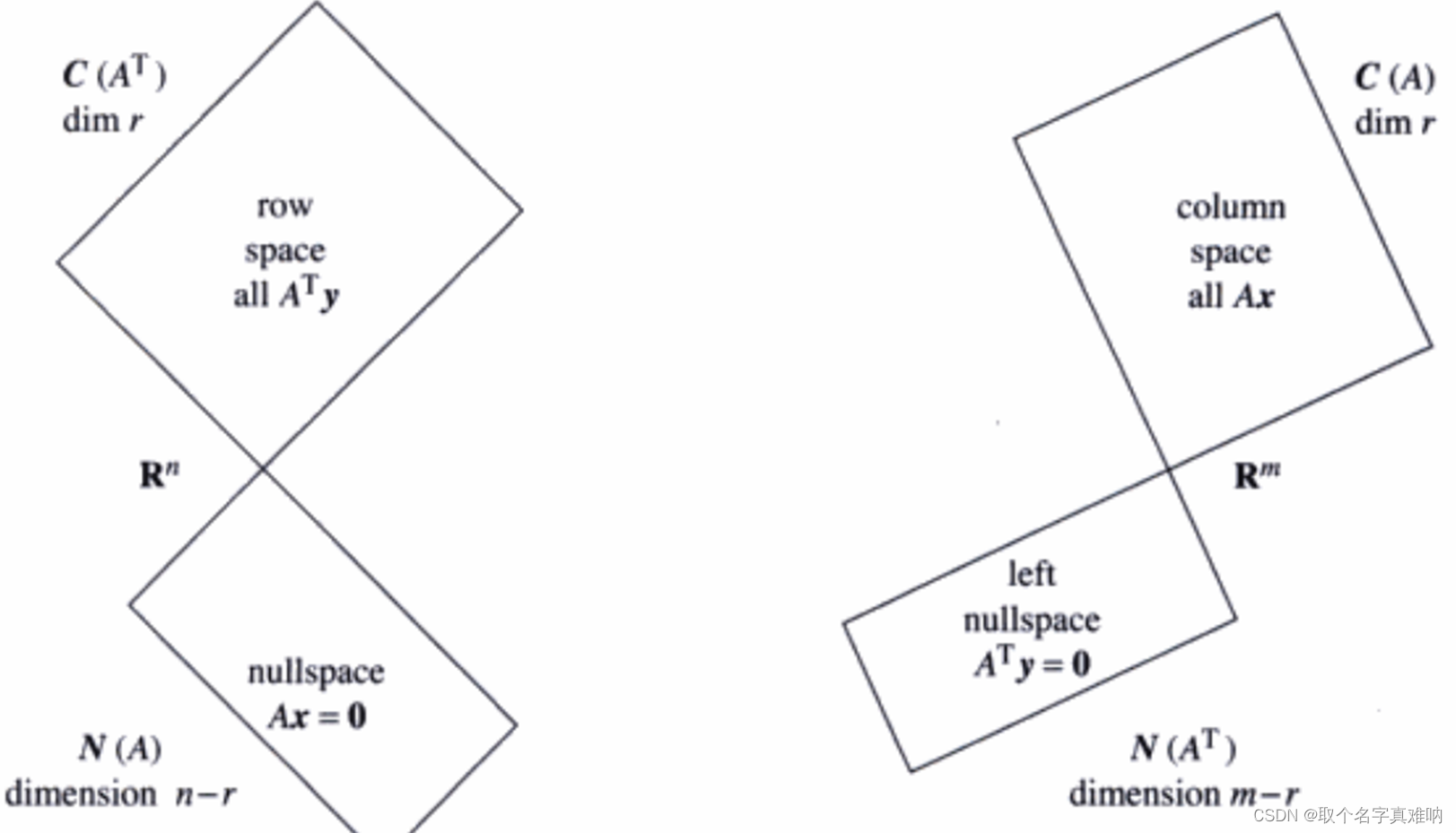

假设我们有一个m行n列的矩阵A,秩为r,当 r = n时,求矩阵A的左逆矩阵。假设我们有一个m行n列的矩阵A,秩为r,当 r = m时,求矩阵A的右逆矩阵。

文章目录1.导入相关库2.加载MNIST数据集3.查看下载数据的大小4.每个像素的大小28 X 285.获取标签名字和对应的序号6.定义函数show_images显示标签图片1.导入相关库注:运行环境:jupyter notebook%matplotlib inline #jupyter notebook里面用,如果pycharm那么就直接注释掉import torchfrom torch.uti