简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

websocat是一个非常轻量级且功能强大的 WebSocket 工具,适用于测试、调试和进行 WebSocket 通信。通过安装并使用websocat,你可以快速与 WebSocket 服务器建立连接,并进行双向数据传输。

更深的视觉骨干 + 相对动作空间 + 强正则化的后训练,是当前解决人形机器人长程任务(Long-horizon tasks)的最优解。虽然多任务泛化仍然是一个持续的挑战,但 N1.6 已经让我们看到了人形机器人走进实验室外、处理复杂现实工作的曙光。

本文基于个人理解 如有误欢迎大家讨论指正。

更深的视觉骨干 + 相对动作空间 + 强正则化的后训练,是当前解决人形机器人长程任务(Long-horizon tasks)的最优解。虽然多任务泛化仍然是一个持续的挑战,但 N1.6 已经让我们看到了人形机器人走进实验室外、处理复杂现实工作的曙光。

这篇文章记录一个在 VLA 视频数据训练里非常常见、也非常折磨人的问题:训练跑着跑着内存持续增长,最后随机触发 av.error.MemoryError: [Errno 12] Cannot allocate memory、或者某个 rank 先挂掉引发 DDP 的连锁退出。更坑的是:明明del了对象、甚至加了,内存还是不降。

这篇文章记录一个在 VLA 视频数据训练里非常常见、也非常折磨人的问题:训练跑着跑着内存持续增长,最后随机触发 av.error.MemoryError: [Errno 12] Cannot allocate memory、或者某个 rank 先挂掉引发 DDP 的连锁退出。更坑的是:明明del了对象、甚至加了,内存还是不降。

这个很简单,只要创建一个自己的code,具体就是create-code-+new notebook就可以然后点击三个小点选择accelerator或者右边notebook option也可以选择注意:要注册验证手机号才能用,在主页头像点进去的个人账号这个地方里面验证,如果还是用不了可以尝试退出登录。

,避免对旧任务的破坏,也就是不依赖于更新最后一层的权重,而是使用示例样本的特征均值进行分类即使新任务的学习导致表示变化,只要示例样本的特征均值保持一致,分类性能就不会显着下降。

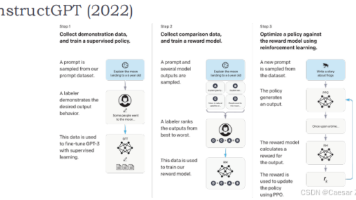

现有的RLHF方法可能难以扩展到更大的应用范围,研究如“RLAIF vs. RLHF: Scaling Reinforcement Learning from Human Feedback with AI Feedback”提供了可能的解决途径。为了降低成本,可能会采取可疑的数据收集实践,如利用低薪劳动力识别有毒内容,或通过免费源获取数据,这可能导致偏见或低质量的数据。微调目标:使用RL微调的目的

这个很简单,只要创建一个自己的code,具体就是create-code-+new notebook就可以然后点击三个小点选择accelerator或者右边notebook option也可以选择注意:要注册验证手机号才能用,在主页头像点进去的个人账号这个地方里面验证,如果还是用不了可以尝试退出登录。