简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

LLVM 16+ 已全面转向New Pass Manager,建议新开发直接采用New PM。代码生成后端(CodeGen)目前仍部分使用Legacy PM [[17]]。(优化管线默认采用),其核心改进是分离Pass与Analysis,支持更灵活的pipeline组合 [[18]]。在使用FUN PASS的时候,如果涉及到整个module 的更改,应将其转换为modulePASS。此设计使LLV

摘要: BF16和FP16作为主流16位浮点格式,在AI领域各有优势。BF16(1-8-7位结构)具有与FP32相同的指数范围,适合大模型训练,能有效避免梯度问题;FP16(1-5-10位结构)精度更高,适合推理和视觉任务。LLM训练中,BF16混合精度可减少50%内存占用并提升30-40%速度;FP16在推理时能保持更好输出质量。多模态领域,视觉分支适合FP16,文本分支适合BF16。实际应用需

选购建议(按预算 & 需求) 目标推荐显卡价格区间(人民币)理由说明预算有限,只想体验 AI 玩玩RTX 2080 Ti(魔改 22GB)¥2,000 – ¥3,000性价比极高;显存魔改后(22GB)可运行多数 LLM 推理(如 7B 模型量化版),适合入门学习。但架构较老(Turing),无 FP8/BF16/TF32 原生支持。中等预算,追求稳定 & 性能平衡RTX 30

记录下关于显卡的知识。

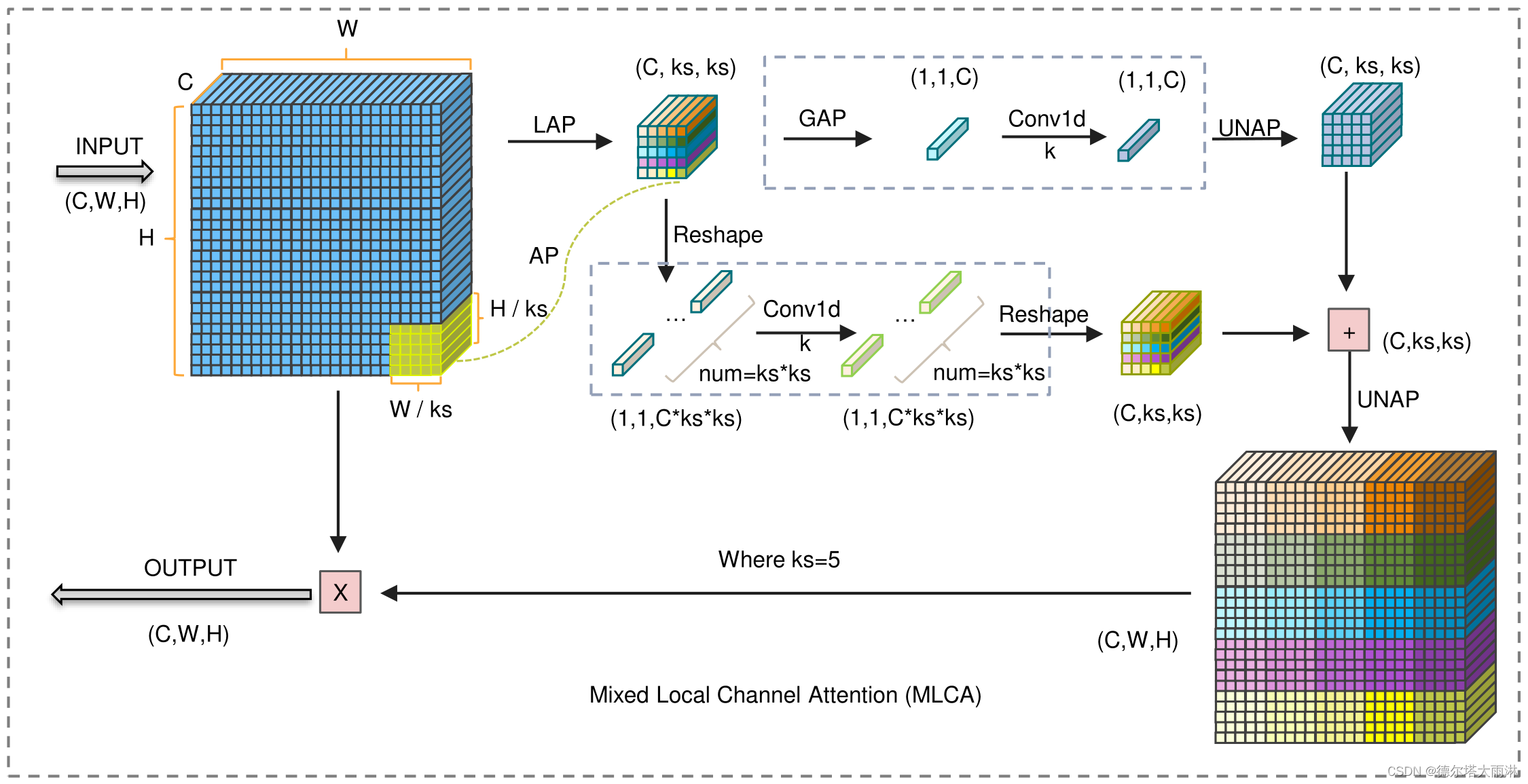

本文章介绍了一种轻量级的 Mixed Local Channel Attention (MLCA) 模块,该模块同时考虑通道信息和空间信息,并结合局部信息和全局信息以提高网络的表达效果。基于该模块,我们提出了 MobileNet-Attention-YOLO(MAY) 算法,用于比较各种注意力模块的性能。在 Pascal VOC 和 SMID 数据集上,MLCA 相对于其他注意力技术更好地平衡了模

一个月就录用了,审稿速度也蛮快的。