简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

短视频是流量入口,私域才是利润池。短视频引流 → 私域承接 → 信任培育 → 持续转化 → 长期复购私域GMV = 客户数量 × 转化率 × 客单价 × 复购频次。

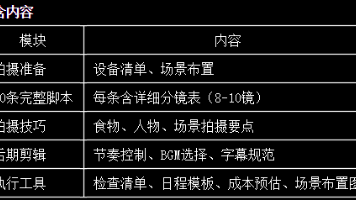

做了10年刺身,我为什么要做配送》时长:40-45秒风格:人设向、真诚讲述20条完整拍摄脚本:覆盖用户激活四阶段详细分镜表:每条脚本8-10个镜头拍摄技巧指南:食物、人物、场景后期剪辑要点:节奏、BGM、字幕实用工具模板:检查清单、日程安排、成本预估按照本文档执行,可在4周内完成新号启动的全部内容拍摄。

目的:建立专业背书选题方向“做了10年刺身,我为什么要做配送”“前日料店主厨,现在专门送刺身”“这些年,我只做一件事”脚本示例【开头 - 身份亮相】我叫xxx,做刺身 10 年了。【中间 - 经历背书】以前在日料店做主厨,每天处理上百斤深海鱼。什么鱼新鲜、什么鱼能生吃,闭着眼睛都知道。后来发现,很多人想在家吃好刺身,但市面上的品质参差不齐。所以我出来做配送,把日料店的品质,送到你家里。【结尾 -

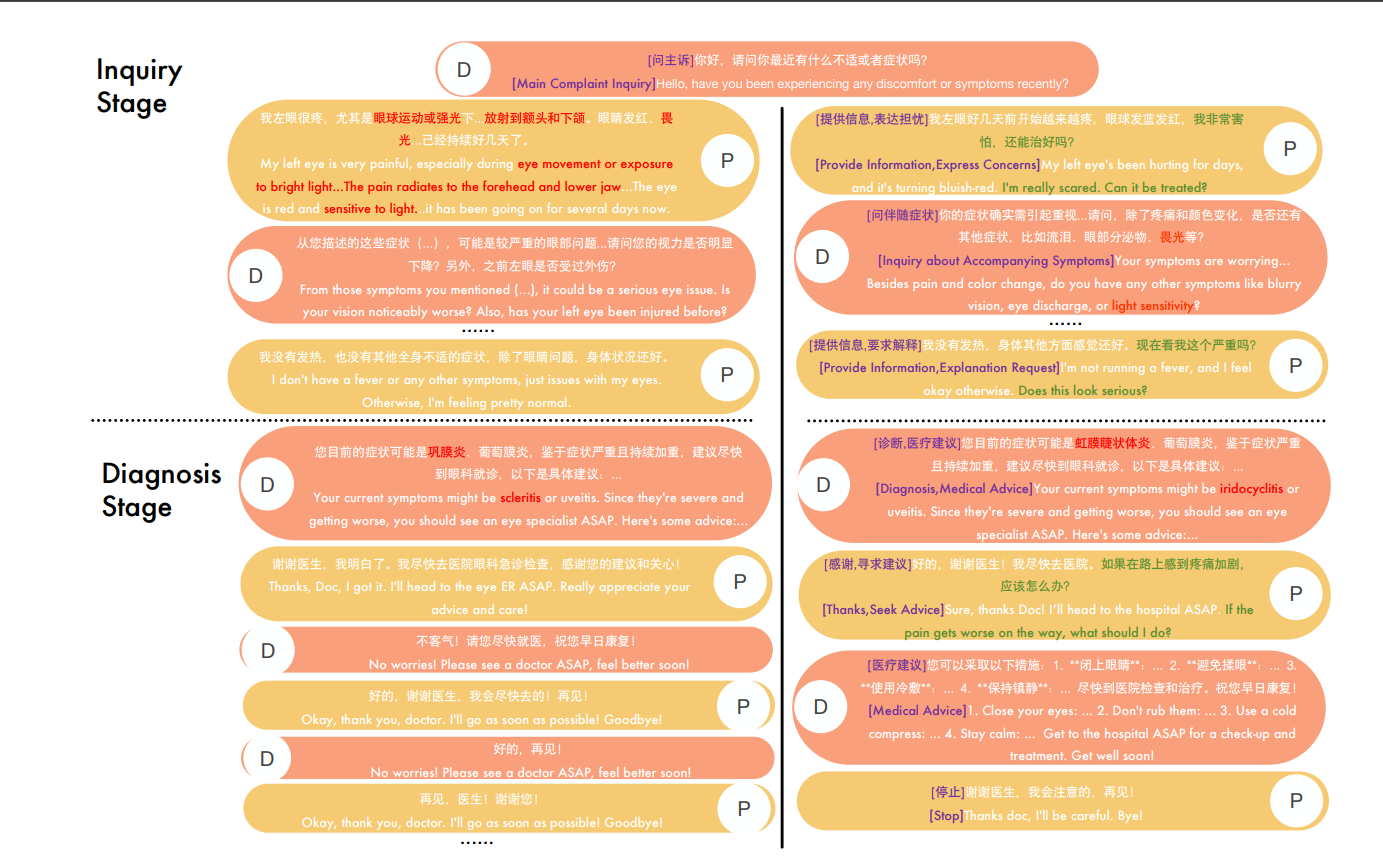

特征/原因:真实患者的对话往往包含情绪化、主诉、提问等多种策略;定义这些“对话策略标签”后,可以更系统地指导模型学习、合成较为真实的对话。之所以用该子解法,是因为:需要将原始对话中难以直接量化的患者行为标注出来,例如“表达焦虑”“主动询问”等策略,为模型的监督训练打下标注基础。(A) 研究背景与动机线上医疗问诊场景:医生只能通过“问诊”收集病人信息,缺乏体格检查及辅助诊断工具,如何在有限的轮数中收

直接在简单明确的奖励标准下进行强化学习,而不再借助传统的“奖励模型”作为中介。这种“去奖励模型”的做法,可以让模型在微调过程中,直接面向真实目标(如解数学题是否正确、编写代码是否能运行)进行自我优化,大幅提升推理和解题能力。

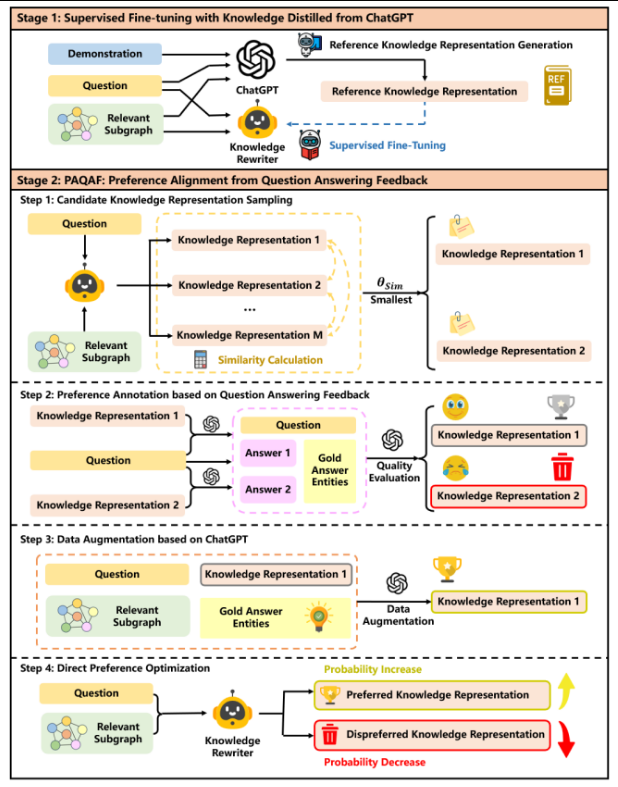

对应特征:LLMs 对一次性的大段“摘要”或“线性拼接的三元组”理解可能有限,要想兼顾复杂问题的多跳信息、又要剔除冗余,就需要一个能够分步地推理、再分步地总结的机制。之所以用这个子解法,是因为问题往往是多跳、且检索到的子图中有大量不相关或冗余信息。若一次性将所有三元组简单拼接(或一次性做一个概括性总结),可能会遗漏关键细节或加入许多无关内容,从而影响回答准确率。简要技术/公式令表示第步的已生成内容

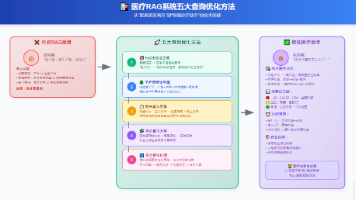

各种“图式检索增强生成(Graph RAG)”方法,弄清楚它们各自的与,并对未来改进提出建议。把检索过程拆成很多原子(操作符),例如:检索节点操作符(根据问题关键词或向量匹配找节点),检索关系操作符(根据相关实体的关系或者一跳邻居),检索社区操作符(从聚类好的社区里找最相关部分),检索子图操作符(如k-hop path、Steiner tree等)。这样就能。

不是这个医生在给你看病,而是医学界的「当前科学理解」在给你看病!

标题:从「金鱼记忆」到「时序推理」——AI智能体记忆的结构化进化核心问题:全文上下文检索导致信息淹没、时序混乱、延迟高核心解法:三层时序知识图谱(Episode→Semantic→Community)+ 双时序边失效机制技术支撑:BGE-m3嵌入、Neo4j图数据库、Cross-encoder重排、标签传播社区检测最终成果:准确率 +18.5%,延迟 -90%,Token -98.6%本质升华:将

❌ 张阿姨的困惑: "我肚子胀,吃不下饭,没劲儿,这是怎么回事?" → 系统返回:一堆不相关的碎片信息→ 患者更困惑: "到底是什么病?我该怎么办?