简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

1 关联规则产生的原因:购物篮问题关联规则最初是为了解决购物篮问题而产生。上世纪九十年代,美国的沃尔玛超市发现,啤酒和尿布这两种完全不着边际的商品竟然有很高的概率一起被购买。在一段时间之后,他终于分析出了原因:在美国有婴儿的家庭中,一般是母亲在家中照看婴儿,年轻的父亲去超市买尿布。父亲在购买尿布的同时,往往会顺便为自己购买啤酒。所以尿布和啤酒一起出现的概率就很高。2 关联规则关联规则是形如X→Y的

1 逆向强化学习的基本设定1.1 智能体&奖励IRL 假设智能体可以与环境交互,环境会根据智能体的动作更新状态,但是不会给出奖励。这种设定非常符合物理世界的实际情况。——>比如人类驾驶汽车,与物理环境交互,根据观测做出决策,得到上面公式中轨迹,轨迹中没有奖励。是不是汽车驾驶问题中没有奖励呢?——>其实是有奖励的。避免碰撞、遵守交通规则、尽快到达目的地,这些操作背后都有隐含的奖励

Double DQN 见:DQN笔记:高估问题 & target network & Double DQN_UQI-LIUWJ的博客-CSDN博客 每个 Worker 节点本地有独立的环境,独立的经验回放数组,还有一个 DQN 和一个目标网络。设某个 Worker 节点当前参数为。第 k 号 Worker 节点重复下面的步骤:

噪声网络 (Noisy Net)是一种非常简单的方法,可以显著提高 DQN 的表现。噪声网络的应用不局限于 DQN,它可以用于几乎所有的强化学习方法。1 噪声网络的原理把神经网络中的参数 w 替换成 µ+σ◦ξ。此处的 µ、σ、ξ 的形状与 w 完全相同。µ、σ 分别表示均值和标准差,它们是神经网络的参数,需要从经验中学习。ξ 是随机噪声,它的每个元素独立从标准正态分布 N (0, 1) 中随机抽

噪声网络 (Noisy Net)是一种非常简单的方法,可以显著提高 DQN 的表现。噪声网络的应用不局限于 DQN,它可以用于几乎所有的强化学习方法。1 噪声网络的原理把神经网络中的参数 w 替换成 µ+σ◦ξ。此处的 µ、σ、ξ 的形状与 w 完全相同。µ、σ 分别表示均值和标准差,它们是神经网络的参数,需要从经验中学习。ξ 是随机噪声,它的每个元素独立从标准正态分布 N (0, 1) 中随机抽

用SDE的形式表示,Ornstein-Uhlenbeck过程为:从SDE的角度看,随机过程包含两块:如果我们考虑离散形式,记单步step为τ:形式上就是,也即自回归形式AR(1)通过上一小段,不难发现Ornstein-Uhlenbeck过程是时序相关的【且满足马尔科夫性,后一步的噪声仅受前一步的影响】,所以在强化学习的前一步和后一步的动作选取过程中可以利用Ornstein-Uhlenbeck过程产

using JSON'''导入了五个模块/库:`JSON(处理JSON数据)`DataStructures(提供数据结构)`NearestNeighbors(最近邻搜索)`Serialization(序列化和反序列化对象)`ArgParse(命令行参数解析)'''endend'''使用 ArgParse 库定义并解析命令行参数。定义了一个命令行参数 --datapath,其类型为字符串,并为其提供

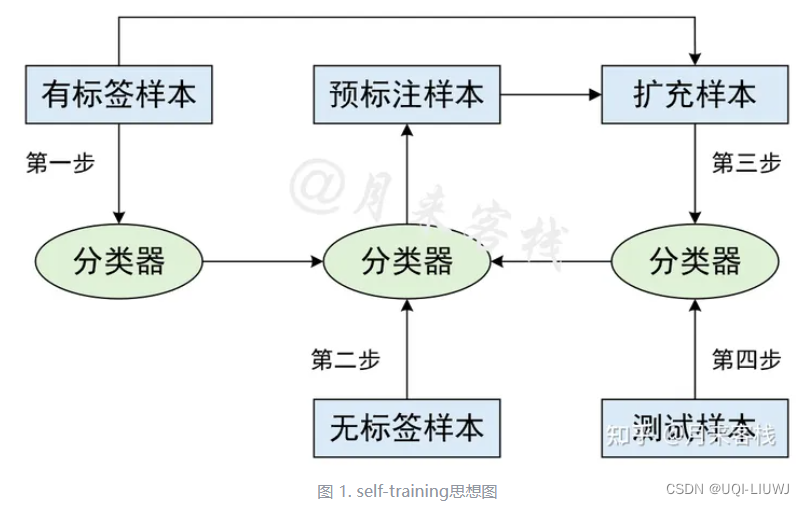

自训练需要迭代多次,且几乎所有的发现高置信度无标记样本的方法都需要排序置信度值,排序过程增加了计算时间,所以计算时间会较长。

backup diagram(备份图),图示的关系构成了更新或备份操作的基础,而这些操作是强化学习方法的核心。这些操作将价值信息从一个状态(或状态-动作对)的后继状态(或状态-动作对)转移回来。1 Value function的备份图我们这里有两层加和:第一层加和就是这个叶子节点,往上走一层的话,我们就可以把未来的价值(状态s'的价值) backup 到黑色的节点。即:第二层加和是对 action

0 复习由于actor-critic 是 policy gradient 和DQN的一个结合,所以我们先对这两个进行一个简单的复习:0.1 policy gradient强化学习笔记:Policy-based Approach_UQI-LIUWJ的博客-CSDN博客在policy network中,我们使用梯度上升的方法更新参数。梯度计算方法如下:(这里的N是采样次数,我们为了更新θ,采样N次)这