简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

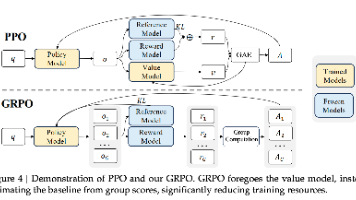

DeepSeek团队提出的GRPO(Group Relative Policy Optimization)是对PPO算法的改进,主要应用于大语言模型训练。GRPO通过采样多个输出的平均奖励作为baseline,替代了传统PPO中需要单独训练Value Model的计算方式,显著降低了训练资源消耗。与PPO相比,GRPO直接在损失函数中引入KL散度惩罚项,并使用无偏估计方法计算KL散度。这一改进简化

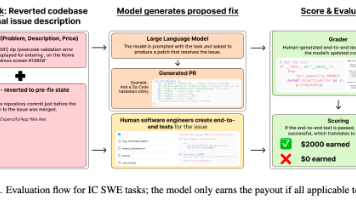

OpenAI推出SWE-Lancer评测集,包含1,400多个真实自由软件工程任务,总价值100万美元。任务分为两类:独立工程任务(IC SWE)和管理任务(SWE Manager)。IC SWE任务通过端到端测试严格评估,需完全通过才能获取报酬;SWE Manager任务则需选择最佳提案方案。测试结果显示,当前模型在真实任务中的表现仍有提升空间,pass@k曲线呈现显著上升趋势。该评测集为评估L

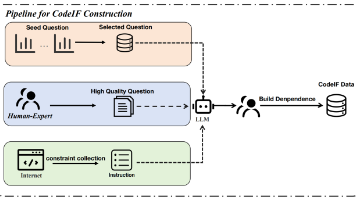

CodeIF提出了一种新的代码生成评估框架,将代码生成任务分解为50种细粒度原子能力,并通过组合这些能力构建复杂指令。数据集包含1200个任务,覆盖Java、Python等语言,并根据难度分为"简单"和"困难"两级。评估采用自动化方式,使用GPT-4进行原子能力的二分类判断(Yes/No),并与人工评估结果高度一致(皮尔逊系数0.87)。提出了CSR、SSR

打开之后可能会发现一堆报错,不慌,因为版本的问题,里面有一些python语言的不兼容,开头加上这句一般agent文件目录都这么设置,朴实无华tools:包含base tool等一系列基础组件,接下来就是一个个tool了,最终会把tool做collection送给模型规定的格式,最终模型think后作出判断输出tool的name,collection根据name策略模式来选择对应的tool执行loo

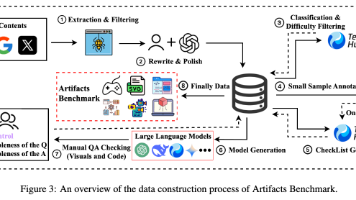

腾讯混元开源ArtifactsBench基准测试,填补LLM代码生成中视觉交互评估的空白。该基准包含9大类应用场景,通过多阶段数据处理流程(提取筛选、分类分级、样本注释等),构建了1000+题目的评价体系,重点关注可视化代码的功能性、美学品质等维度。其创新在于突破传统仅关注算法正确性的局限,首次系统性地评估代码的视觉保真效果和交互完整性。

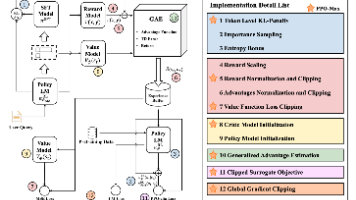

本文探讨了PPO算法在训练中的稳定性问题及改进策略。文章指出RL训练中常见的"训练崩溃"现象,即策略模型通过欺骗奖励系统获得高分却偏离实际需求。针对这一问题,作者介绍了PPO-MAX框架,包含三种关键改进:1)参数重置(奖励缩放、归一化和裁剪);2)策略限制(token级KL散度惩罚和熵奖励);3)预训练初始化(用参考模型和奖励模型初始化策略和评论家模型)。实验结果表明,这些改

strict”= true的时候更能保证json output的输出,这个参数感觉大家用的很少,实际上为true和false,对于tool的parameters写法很多都可以等价。这个是我们平时很爱写的写法,看到的基本上都是这种,只会把一定需要的参数写为required中,但openai的"strict"= true, 对type做一下修改是一样的效果。claude也是一样的,就是传入参数 req

本文主要快速总结Agent的初步形成的范式, 从COT,self-ask,Plan-and-execute agents,到ReAct目前相对来说比较广泛应用的范式。

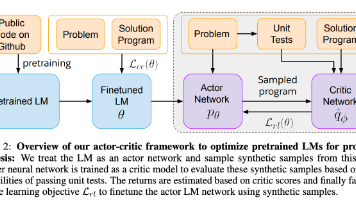

Salesforce的CodeRL提出了一种结合预训练和强化学习的代码生成方法。该方法首先使用GitHub代码预训练CodeT5模型,然后通过Prompt-response任务进行微调,最后采用Actor-Critic强化学习框架优化模型。其中,reward机制基于代码编译测试结果(编译错误、运行时错误、测试失败/通过),critic网络作为错误预测器。该方法在程序合成任务中表现出色,能有效提升代

name工具名字description工具描述Input types 输入参数类型和说明output type输出类型写一个模型下载的tool@tool"""Args:"""一定要存在 类型的 定义以及 注释,注释中要有 Args主要用继承的方式比如创建 VLLM模型, 继承模型 + 重新实现 “call"""import gcself,**kwargs,**kwargs,messages,els