简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了使用LLaMA-Factory框架微调大模型的详细流程。首先准备虚拟环境并安装LLaMA-Factory及相关依赖,然后下载基座模型和训练数据集。文章提供了两种微调方式:通过Web页面可视化操作或命令行执行。最后演示了如何测试微调后的模型,包括Web界面和命令行两种方式。整个过程涵盖环境搭建、数据准备、参数配置到模型推理的全流程,相比Unsloth框架更简单易用。

Openclaw对Windows 原生环境并不太友好,特别是老旧的Windows10,本文介绍基于Windows10+WSL部署openclaw的全过程。

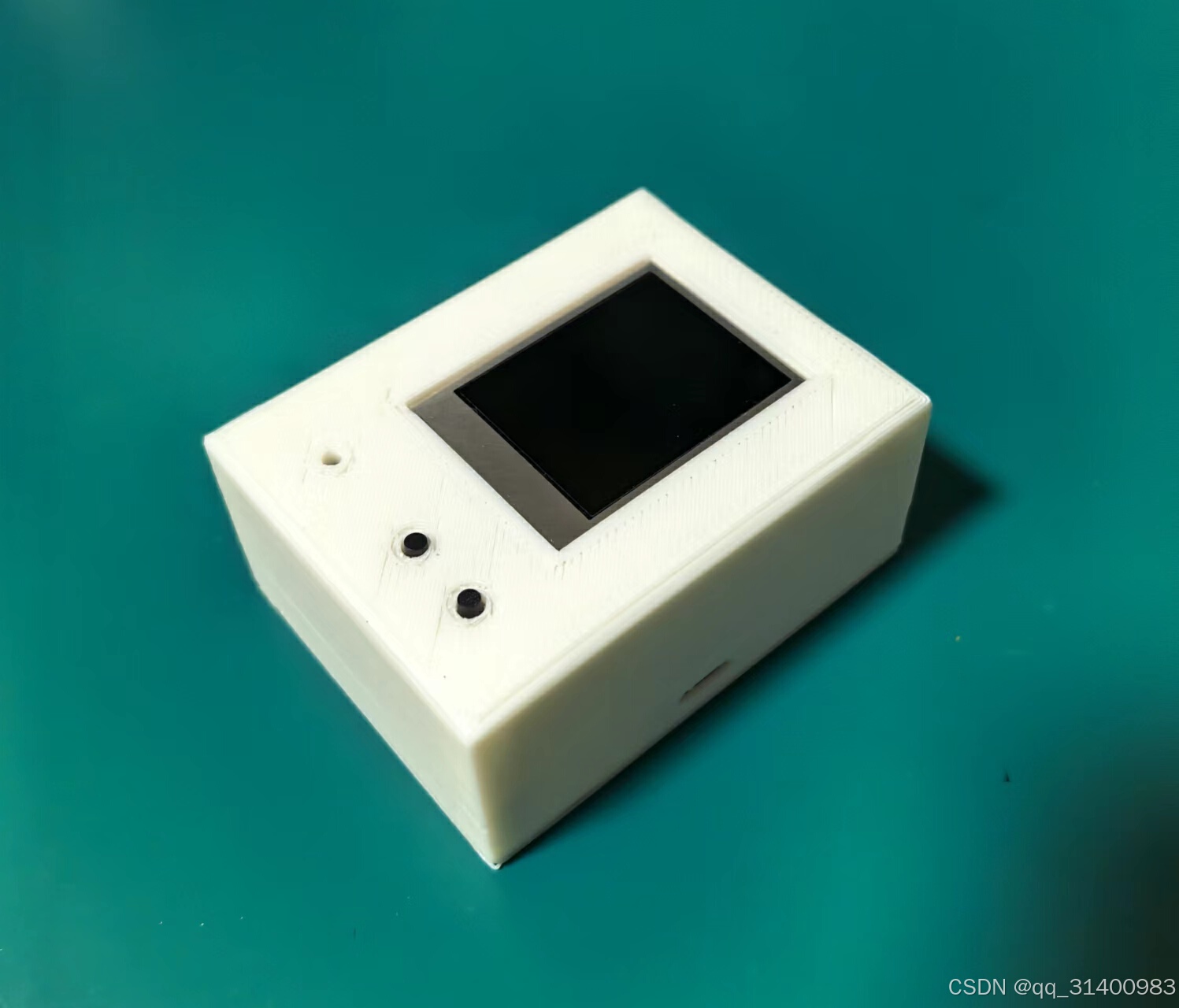

这是一款用ESP32制作的聊天机器人,可连接国内主流大模型,可自定义唤醒词,支持角色定义。

应用RAG(Retrieval Augmented Generation,检索增强生成)构建本地知识库,并与LLM(大模型)相结合,可有效解决LLM知识更新难问题,已成为专业领域智能问答的首选,下面就以Ollama+Deepseek+RAGFlow为例构建本地知识库应用。

关于使用Unsloth微调大模型的文章不少,但大部分都使用了云主机环境和厂商提供的工具平台,本着DIY精神,笔者在普通PC上进行了手搓微调实践。

完成设置后回到主页面,可以看到顶部的4个页面。“探索”页面提供了模板应用程序,用户可参考模板定制自己的应用程序。“工作室”页面用户可创建自己的应用,包括聊天助手、智能体、工作流。“知识库”页面用户可以通过上传自己的文本数据创建知识库增强 LLM 的上下文。“工具”页面是Dify本身集成第三方工具,用户也可自定义工具。

本文介绍了使用LLaMA-Factory框架微调大模型的详细流程。首先准备虚拟环境并安装LLaMA-Factory及相关依赖,然后下载基座模型和训练数据集。文章提供了两种微调方式:通过Web页面可视化操作或命令行执行。最后演示了如何测试微调后的模型,包括Web界面和命令行两种方式。整个过程涵盖环境搭建、数据准备、参数配置到模型推理的全流程,相比Unsloth框架更简单易用。

介绍一下如何在保留旧版本Dify配置和应用的情况下升级到新版本。

应用RAG(Retrieval Augmented Generation,检索增强生成)构建本地知识库,并与LLM(大模型)相结合,可有效解决LLM知识更新难问题,已成为专业领域智能问答的首选,下面就以Ollama+Deepseek+RAGFlow为例构建本地知识库应用。

本文介绍了使用LLaMA-Factory框架微调大模型的详细流程。首先准备虚拟环境并安装LLaMA-Factory及相关依赖,然后下载基座模型和训练数据集。文章提供了两种微调方式:通过Web页面可视化操作或命令行执行。最后演示了如何测试微调后的模型,包括Web界面和命令行两种方式。整个过程涵盖环境搭建、数据准备、参数配置到模型推理的全流程,相比Unsloth框架更简单易用。