简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这是一个很容易出现的问题,网上很多内容将mysql驱动包上传到不对的路径导致出现问题。cloudera manager添加hive时报错找不到jdbc driver报错JDBC driver cannot be found. Unable to find the JDBC database jar on host把包放入这个目录,注意文件名要保持一致 网上又很多需要把这个驱动包放到cp ...

一共有四种情况使用memcpy,对于使用&还是不适用什么时候使用一直很困惑,虽然现在仍未全部清除,不过初步已经了解一些。果然还是对指针不熟悉,否则会理解的更好。使用memcpy 拷贝数组int res2[5] = { 0 };int res2_dest[5] = { 1, 1,1,1,1 };for (int i = 0; i < 5; i++){...

这是一个很容易出现的问题,网上很多内容将mysql驱动包上传到不对的路径导致出现问题。cloudera manager添加hive时报错找不到jdbc driver报错JDBC driver cannot be found. Unable to find the JDBC database jar on host把包放入这个目录,注意文件名要保持一致 网上又很多需要把这个驱动包放到cp ...

需要注意的是pandas处理数据,数字格式的null 会被显示为nan,所以需要简单的处理一下:str_obj.replace("nan", "null")完整代码如下:# -*- coding: utf-8 -*-import pandas as pdfrom datetime import datetimefrom impala.dbapi import connectfrom impala.

selectday,dayofweek(day)as dw1,date_add(day,1 - dayofweek(day))as Su_s -- 周日_start,date_add(day,7 - dayofweek(day))

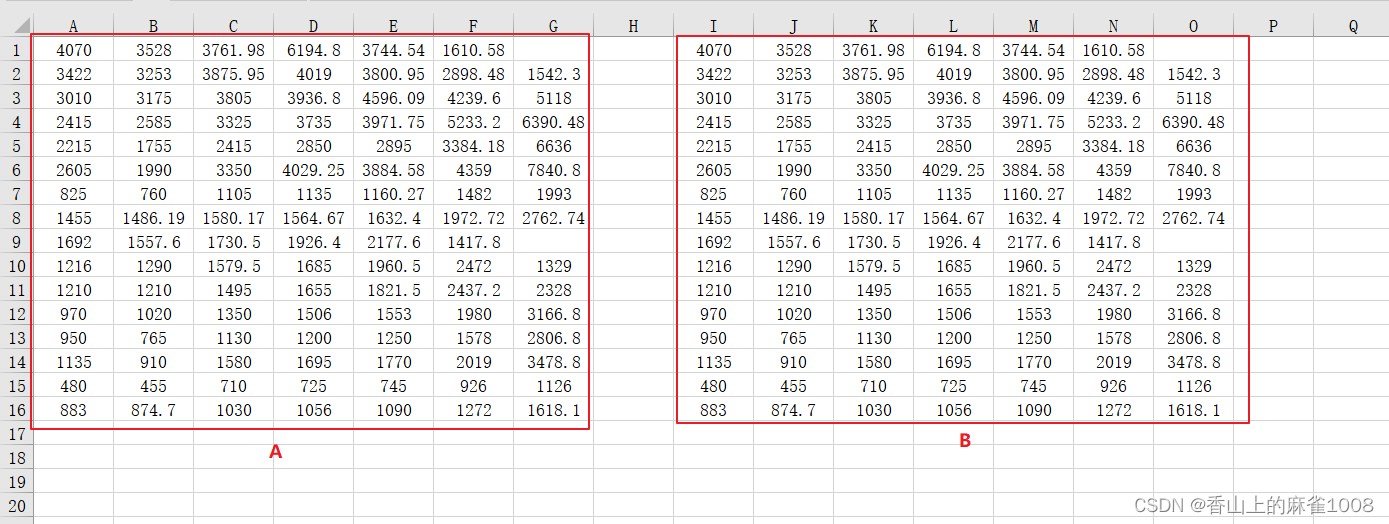

下面是常用的在Excel中比较两个Excel表格数据的方法,

如果不加FORCE,删除分区则是临时删除,并不会立马释放存储空间,如果需要立即释放这些分区所占用的磁盘空间,那就要执行DROP PARTITION FORCE,此时系统不会检查分区中是否有未完成的事务,分区会被直接删除,且无法恢复。

业务数据保存在mysql中,定期用Sqoop导入到HDFS的ODS层,DWD层的业务数据进行简单的数据清洗并降维(退化维度)需求1:求GMV成交总额思路:在ADS层建每日GMV总和表ads_gmv_sum_daydrop table if exists ads_gmv_sum_day;create table ads_gmv_sum_day(`dt` string COM...

一共有四种情况使用memcpy,对于使用&还是不适用什么时候使用一直很困惑,虽然现在仍未全部清除,不过初步已经了解一些。果然还是对指针不熟悉,否则会理解的更好。使用memcpy 拷贝数组int res2[5] = { 0 };int res2_dest[5] = { 1, 1,1,1,1 };for (int i = 0; i < 5; i++){...

Hive报错:Error: Error while processing statement: Cannot modify mapreduce.job.name at runtime.It is not in list of params that are allowed to be modified at runtime (state=42000,code=1)解决方法:在hive-site.x