简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

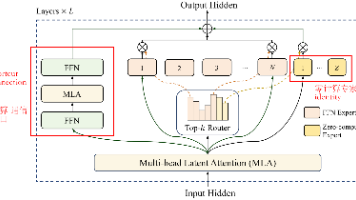

美团近期推出的龙猫大模型(LongCat-Flash)引发关注,这是一个560B参数的MoE架构模型。其核心创新包括:1)引入零计算专家机制,通过动态分配计算资源提升效率,平均每个token激活27B参数;2)提出ScMoE架构优化通信开销;3)采用方差对齐技术解决模型扩展性问题。该模型在30天内完成20T token训练,推理速度达100 token/秒,成本低至每百万token 0.7美元。通

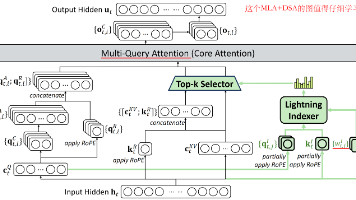

本文介绍了DeepSeek的稀疏注意力机制DSA,包含Lighting Indexer和Token Selection两个模块。DSA采用FP8低精度计算、ReLU激活和更少头数来降低复杂度,并通过top-k选择重要token。训练分为两步:CPT阶段先预热Indexer使其接近原始attention分布,再训练模型适应稀疏模式;后训练阶段结合专家蒸馏和混合RL训练(GRPO算法),融合推理、工具

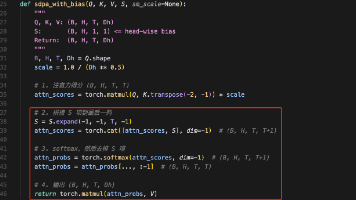

摘要:GPT-OSS模型针对大模型推理中的attention sink问题提出创新解决方案,通过可学习bias项修正注意力机制。该方法在QK计算后添加head-wise的bias token,调整softmax分母,有效规避无效的初始token过度关注现象。同时采用分层混合策略,交替使用全注意力(GQA)和滑动窗口注意力(window=128),在120B大模型中实现高效推理。数学上相当于给注意力

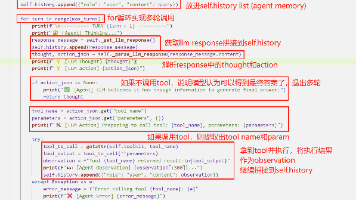

本文介绍了Agent的基本概念及其实现方式。Agent是一种能够感知环境并自主决策的实体,具备任务规划、记忆和工具调用等能力,模仿人类的决策流程。文章重点讲解了ReAct推理模式(Reasoning->Action->Observation),并展示了如何使用LangChain框架构建一个ReAct Agent。具体包括:1)Agent作为调度器的核心组件;2)规范定义工具的方法;3)

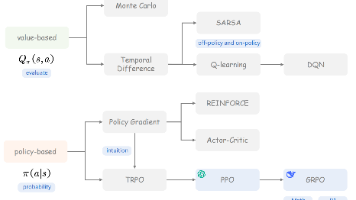

本文介绍了强化学习中的策略模型(Policy/Actor)、价值模型(Critic/Value)、奖励模型(Reward)和参考模型(Reference)等核心概念。重点对比了监督学习和强化学习的区别,并详细分析了基于策略的强化学习方法,特别是PPO和GRPO算法。PPO采用Actor-Critic架构,通过优势函数和clipping机制实现稳定训练;GRPO则简化结构,利用组内相对奖励作为优势估

Function Calling和MCP是增强大模型能力的两种方案。Function Calling赋予大模型解析工具列表、选择工具、处理结果的能力,通过代码实现工具调用逻辑。MCP则是一套协议规范,通过MCP Host和Server架构实现外部工具调用,无需大模型直接参与协议。两种方法都能解决大模型知识时效性问题,Function Calling侧重模型能力,MCP强调标准化协议。实际应用中,F

LLM是加载和推理大模型的包,SamplingParams是生成时采样参数。

MoE在每次推理时选择性地激活部分模型参数,在不成比例增加计算成本的情况下,可以扩展模型参数。在DeepSeek-V2中就提出了用于FFN层的DeepSeekMoE,DeepSeek-R1在DeepSeek-V2基础上进一步优化。

【代码】ValueError: Converting from Tiktoken failed, if a converter for SentencePiece is available。

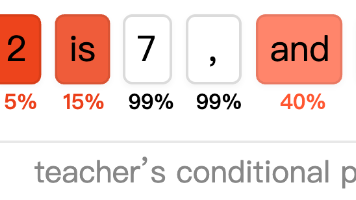

《On-Policy Distillation》结合在线策略与知识蒸馏的后训练方法,提出了一种新型大模型优化范式,通过融合强化学习的在线策略(on-policy)和知识蒸馏的密集奖励信号,有效解决了传统方法的局限性。相比纯在线策略的稀疏反馈问题,以及离线策略(off-policy)的误差累积缺陷,该方法让学生模型基于自身生成的推理轨迹(rollout),借助教师模型对每个token进行评分,使用反