简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文主要分享如何使用 LLaMAFactory 实现大模型微调,基于 Qwen1.5-1.8B-Chat 模型进行 LoRA 微调,修改模型自我认知。本文的一个目的:基于模型进行微调,修改模型自我认证。修改前对于模型,用户问你是谁?时模型一般会回答我们希望在微调之后,对于同样的问题,模型能回答。

刚刚在知名同性交友平台发现了一个或许能让你致富的开源项目——“Streamer-Sales 销冠”。正如其名字所言,这是一个卖货主播LLM大模型,旨在让你成为销冠。根据介绍,“Streamer-Sales 销冠”能够根据商品特点进行解说,通过生成的细腻、独到的解说词,激发用户的购买欲望。功能亮点:技术栈方面,该模型据称用 xtuner 在 InternLM2 的基础上指令微调而来,部署集成了 LM

互联网上的数据质量参差不齐,无论是OpenAI 联合创始人Andrej Karpathy 在微软Build 2023的报告,还是当前的一些研究都表明,训练数据的质量对于大语言模型效果具有非常重要的影响。因此,如何从收集到的数据中删除低质量数据成为大语言模型训练中的重要步骤。大语言模型训练中所使用的低质量数据过滤方法可以大致分为两类:基于分类器的方法和基于启发式的方法。基于分类器的方法目标是训练文本

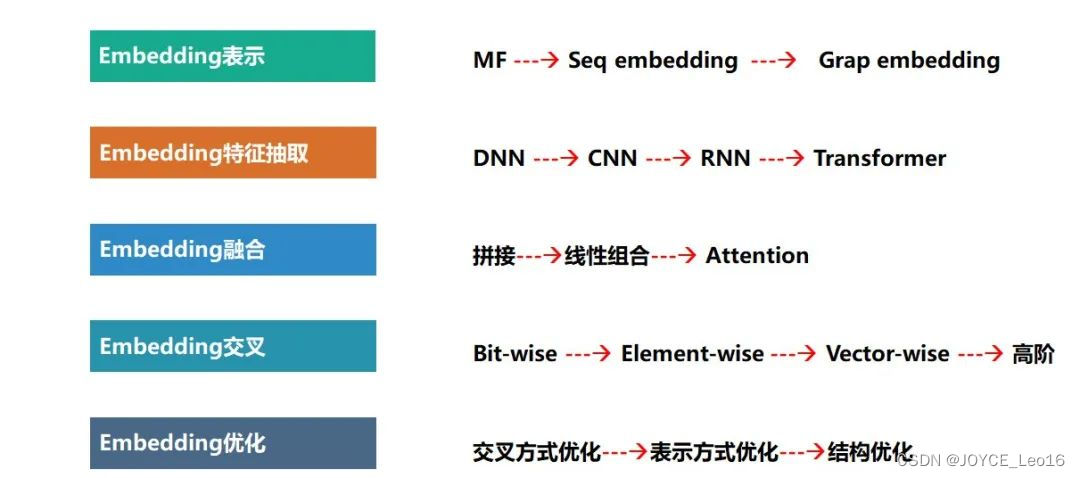

本文将从 Embedding 的本质、Embedding的原理、Embedding的应用三个方面,详细介绍Embedding(嵌入)。

传统的预训练数据清洗和优化方法主要依赖人工设计的规则,虽然这些规则能够有效过滤低质量数据,但无法针对每个样本进行更细粒度的处理。这种方式难以处理复杂的多样化数据,最终可能导致模型性能的瓶颈。Program-Every-Example (ProX) 的出现旨在改变这一局面,它通过。

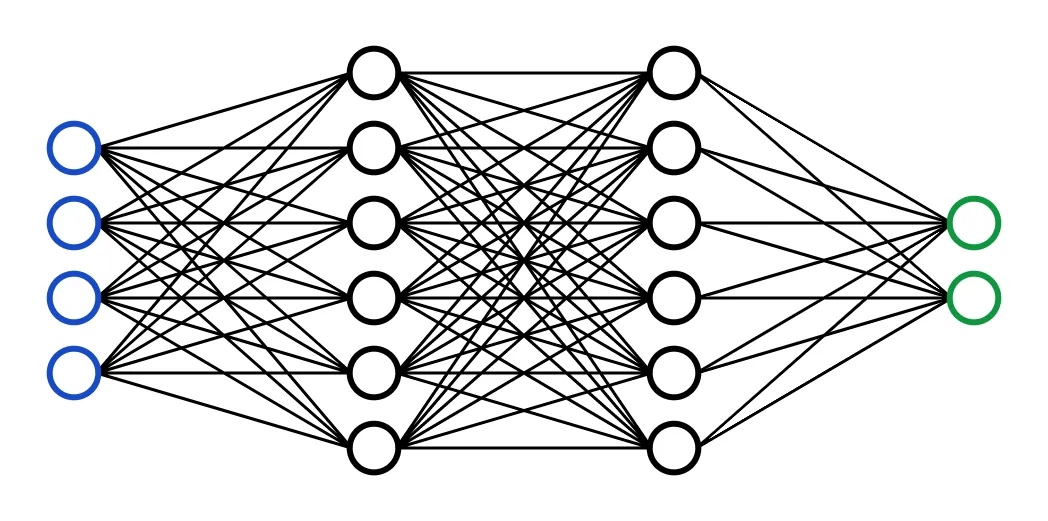

神经网络是深度学习算法的基本构建模块。神经网络是一种机器学习算法,旨在模拟人脑的行为。它由相互连接的节点组成,也称为人工神经元,这些节点组织成层次结构。

Ollama是建立在llama.cpp开源推理引擎基础上的大模型推理工具框架。得益于底层引擎提供的高效模型推理,以及多硬件适配,Ollama能够在包括CPU、GPU在内的,不同的硬件环境上,运行各种精度的GGUF格式大模型。通过一个命令行就能拉起LLM模型服务。通过Ollama,开发者可以更好的使用GGUF模型。

今年整个 IT 界、甚至科技界最火爆的技术就是 AI 大模型了,没有之一。以 OpenAI 的 GPT 为代表、国内外一众大模型跟进,形成了百模齐奔的态势。围绕着大模型,各项周边的应用也在快速发展。在 2023 年年底的云栖大会上,论坛标题带有“大模型”的搜索一下,有三十个之多。搞技术的同学朋友一聊天,不提大模型,都没得可聊了。笔者从事 GIS 开发多年,现在在阿里云-政企事业部-解决方案研发部,

大模型微调,也称为 Fine-tuning ,是指在已经预训练好的大型语言模型 基础上(一般称为“基座模型”),使用特定的数据集进行进一步的训练,让模型适应特定任务或领域。经过预训练的基座模型其实已经可以完成很多任务,比如回答问题、总结数据、编写代码等。但是,并没有一个模型可以解决所有的问题,尤其是。

AI大模型,通常指的是使用大量参数和数据进行训练的深度学习模型。这些模型能够处理复杂的任务,如图像和语音识别、自然语言处理等。由于模型规模庞大,能够捕捉到数据中的更多细节和模式,因此在各种AI任务中表现出色。近年来,随着计算能力的提升和数据的积累,AI大模型的研究和应用取得了显著进展,成为人工智能领域的一大热点。:AI大模型如GPT-3和BERT被用于改进语言翻译、文本摘要、情感分析、问答系统等任