简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

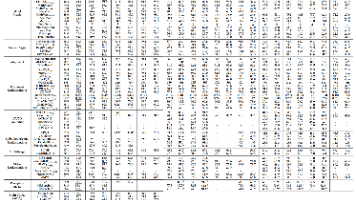

本文整合了Qwen3-VL系列大/中/小三种尺寸模型的评测结果,通过对比分析得出一些结论供读者参考。

Stable Diffusion 是用 LAION-5B 的子集(图像大小为512*512)训练的扩散模型。此模型冻结 CLIP 的 ViT-L/14 文本编码器建模 prompt text。模型包含 860M UNet 和123M 文本编码器,可运行在具有至少10GB VRAM 的 GPU 上。接下来实战一下本地部署。

检查命令行里的spider名字和class中一致,且spiders目录也有__init__.py,然而还是报错,于是经过一番探究...发现该spider里有个name变量...应该是和内置的name变量冲突了 改个名即可

描述了幻觉的定义、产生原因、评测方法;并从产品侧、数据侧、模型侧介绍如何缓解大模型幻觉,并介绍了通过高级 prompt 和 RAG 等方法进行大模型幻觉的缓解。

代码(by 字节跳动孔大佬):https://github.com/qiuqiangkong/piano_transcription_inference使用:1.安装packagepip install piano_transcription_inference2.下载预训练模型https://zenodo.org/record/40342643.运行代码from piano_transcript

参考教程:点这里目录一张图中画一条线与两条线设置坐标轴axLegend图例Annotation 标注tick 透明度scatter 散点图Bar 柱状图Contours 等高线图Image 图片3D数据多图合并显示分格显示图中图次坐标轴(左右都有轴)Animation 动画END一张图中画一条线与两条线import...

描述了幻觉的定义、产生原因、评测方法;并从产品侧、数据侧、模型侧介绍如何缓解大模型幻觉,并介绍了通过高级 prompt 和 RAG 等方法进行大模型幻觉的缓解。

描述了幻觉的定义、产生原因、评测方法;并从产品侧、数据侧、模型侧介绍如何缓解大模型幻觉,并介绍了通过高级 prompt 和 RAG 等方法进行大模型幻觉的缓解。

前言模型推理服务需要用Docker进行部署,所以记录了Docker学习过程中的八大问题。项目需求:将Flask服务用Docker打包成镜像。个人环境:Python 3.8(in WSL2)、VSCode(Docker插件)、Docker Desktop。概念理解:Docker的Image相当于一个装好运行环境和代码的虚拟机镜像,Container相当于基于镜像实例化运行的容器。一、Docker如何

之前一直用pip freeze > requirements.txt导出requirements.txt,优点是不用安装其他依赖,缺点是会将项目依赖的python环境中所有依赖都输出。替代方案:使用pipreqs导出。pip install pipreqspipreqs . --encoding=utf8 --force安装并执行,如上所示,就会将requirements.tx输出到执行命令