简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

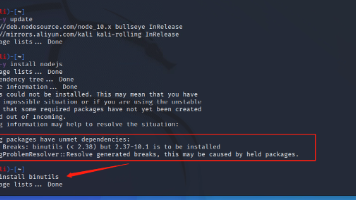

本文介绍了Node.js环境的安装流程及常见问题解决方法。首先通过curl命令获取Node.js 10.x版本的安装脚本并执行,然后更新系统并安装Node.js。若出现错误,建议安装binutils工具包。最后安装npm并通过npm全局安装reverse-sourcemap工具。文中特别强调步骤间的依赖关系,建议遇到错误时查看输出信息,并将错误命令和信息提交至kimi.com寻求解决方案后再继续后

ima.copilot是一款多功能AI助手工具,主要提供四大核心功能:1)AI笔记与内容创作;2)AI搜索与问答(支持浑元、DeepSeek模型及文生图);3)文件解析(支持PDF/Word等格式,单文件最大100M);4)本地知识库构建(支持上传论文、公众号文章等资料)。用户可创建个性化知识库用于专业学习(如网络安全、植物研究)或内容创作,支持PC客户端和微信小程序操作。相比同类产品(如知乎知识

网络安全风险摘要:网站源码泄露存在多种途径,包括phps/git文件、robots.txt、压缩包、版本控制文件(.git/.svn)、vim临时文件(.swp)等。敏感信息可能存在于网页源码、测试探针、前端JS代码、数据库文件(db.mdb/.sql)中。攻击方式包含目录扫描、DNS穿透、cookie泄露、邮箱信息收集等。防范要点:限制目录扫描权限、检查敏感文件权限、加密前端密钥、定期审计网页源

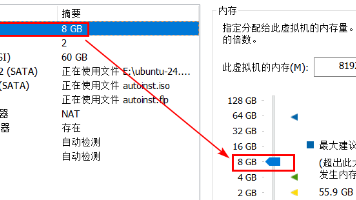

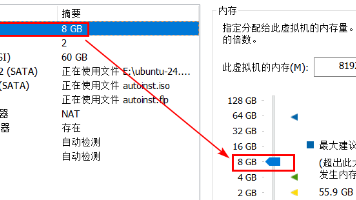

Dify是一个开源的生成式AI应用开发平台,支持低代码开发、多模型切换和RAG技术。用户可快速构建智能客服、内容生成等应用。部署时需准备Ubuntu+Docker环境(2核CPU/4GB内存以上),下载Dify源码后通过docker-compose启动。安装后需配置Ollama模型供应商并下载大语言模型(如千问7B)。平台支持调整上传文件大小限制(默认15MB),修改后需重启容器。虚拟机部署需注意

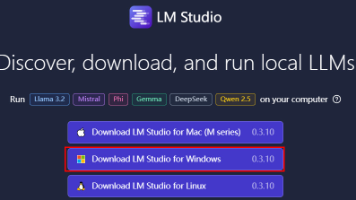

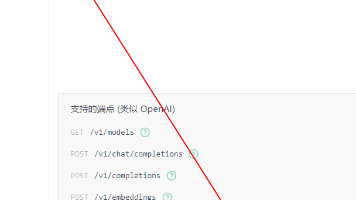

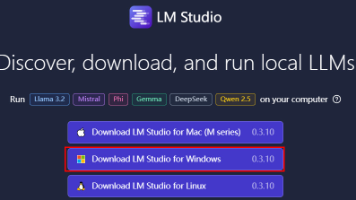

本文介绍了在Windows系统下本地部署DeepSeekR1模型API的方法。首先需要安装Python3和LMStudio,启动本地API服务后可通过http://localhost:1234访问。文章提供了两种调用方式:1)通用HTTP接口调用,使用requests库发送POST请求;2)OpenAI兼容方式调用,通过openai库实现。建议根据具体使用场景调整temperature参数值(0.

本地部署AI模型具有不受官方限制和保护隐私的优势,但性能较差且对硬件要求较高。推荐使用Windows10/11系统,配置至少8核CPU、16GB内存和8GB显存显卡。介绍了LMStudio等部署工具和常见模型如Qwen2-7B、DeepSeekR1等。详细说明了LMStudio的安装步骤、模型下载方法及配置要求。指出本地推理速度远慢于网页版,同时推荐了其他开源模型如secgpt-mini。适合开发

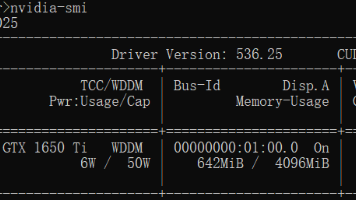

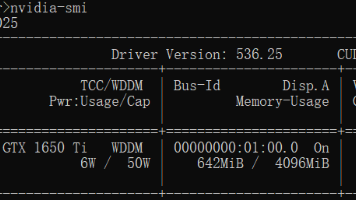

摘要:CUDA是NVIDIA推出的并行计算平台,支持GPU加速深度学习计算。安装步骤包括:1)确认显卡支持CUDA;2)从官网下载对应系统版本的CUDA工具包;3)通过PyTorch官网或迅雷加速安装支持GPU的PyTorch包(需匹配Python和CUDA版本);4)验证安装结果。成功安装后,运行测试代码将显示CUDA可用状态(True)及相关版本信息。该环境可显著提升大模型微调效率,充分利用G

摘要:CUDA是NVIDIA推出的并行计算平台,支持GPU加速深度学习计算。安装步骤包括:1)确认显卡支持CUDA;2)从官网下载对应系统版本的CUDA工具包;3)通过PyTorch官网或迅雷加速安装支持GPU的PyTorch包(需匹配Python和CUDA版本);4)验证安装结果。成功安装后,运行测试代码将显示CUDA可用状态(True)及相关版本信息。该环境可显著提升大模型微调效率,充分利用G

Dify是一个开源的生成式AI应用开发平台,支持低代码开发、多模型切换和RAG技术。用户可快速构建智能客服、内容生成等应用。部署时需准备Ubuntu+Docker环境(2核CPU/4GB内存以上),下载Dify源码后通过docker-compose启动。安装后需配置Ollama模型供应商并下载大语言模型(如千问7B)。平台支持调整上传文件大小限制(默认15MB),修改后需重启容器。虚拟机部署需注意

本地部署AI模型具有不受官方限制和保护隐私的优势,但性能较差且对硬件要求较高。推荐使用Windows10/11系统,配置至少8核CPU、16GB内存和8GB显存显卡。介绍了LMStudio等部署工具和常见模型如Qwen2-7B、DeepSeekR1等。详细说明了LMStudio的安装步骤、模型下载方法及配置要求。指出本地推理速度远慢于网页版,同时推荐了其他开源模型如secgpt-mini。适合开发