简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

贝叶斯神经网络通过引入参数的概率分布来描述模型的不确定性。与传统的确定性神经网络不同,BNNs 通过学习参数的后验分布来对模型进行建模,从而在预测中提供。让xθ↦gθx定义的gX×Θ→Y作为神经网络(NN),其中gθx是由x和θ确定的函数。贝叶斯神经网络(BNNs)的主要假设是通过一个简单的分布来近似参数g的后验分布pθ∣D,该分布在参数空间Θ⊆RP上编码了不确定性。

要求在指定端口接收来自客户的HTTP请求并且根据其中的URL地址访问该地址所指向的HTTP服务器(原服务器),接收HTTP服务器的响应报文,并将响应报文转发给对应的客户进行浏览。要求能缓存原服务器响应的对象,并能够通过修改请求报文(添加头行),向原服务器确认缓存对象是否是最新版本。,支持如下功能:网站过滤:允许不允许访问某些网站;用户过滤:支持不支持某些用户访问外部网站;网站引导:将用户对某个网站

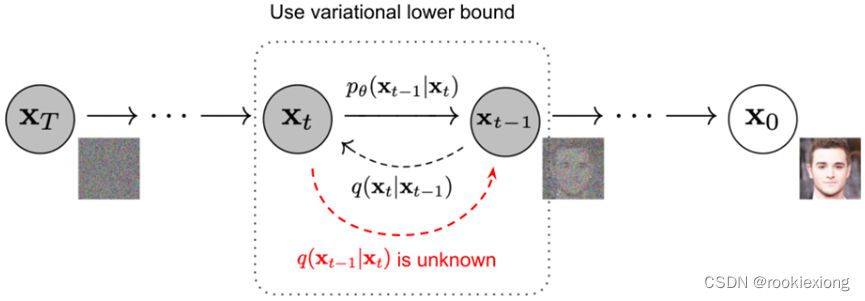

DDPM实际上是VAE而不是扩散模型。

扩散模型Diffusion model | DDIM论文原文:Denoising Diffusion Implicit Models有关DDPM的解释可以参考我的上一篇博客:扩散模型Diffusion model | DDPMDDPM的贝叶斯解释直接根据贝叶斯定理我们有p(xt−1∣xt)=p(xt∣xt−1)p(xt−1)p(xt)p(\boldsymbol{x}_{t-1}|\boldsymb

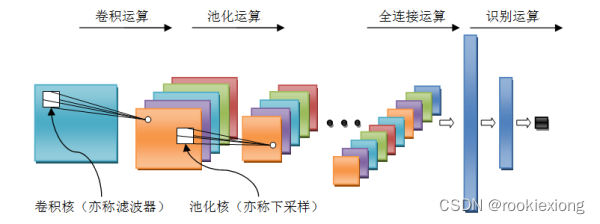

采用任意一种课程中介绍过的或者其它卷积神经网络模型(例如LeNet-5、AlexNet等)用于解决某种媒体类型的模式识别问题。

贝叶斯优化是一种优化方法,通过在每一步中利用先前的观测结果来选择下一次评估的点,以尽可能地提高目标函数的值。它结合了贝叶斯统计模型和优化算法,能够在非凸、高维、噪声和有约束的情况下进行高效优化。假设fX→YfX→Y是一个函数,其分析上难以处理和/或评估代价很高。我们希望(不失一般性)找到x∗argmaxx∈Xfxx∗argmaxx∈Xfx。

定理3 设f:X→Y,g:Y→Z,若f和g都是可逆的,则gf也是可逆的且(gf)-1=f-1g-1,(f–1)-1=f。若|S|=n,则S上的置换称为n次置换。:设f:X→Y,A⊆X,由f和A可以唯一的确定Y 中的一个子集,记为f(A),f(A)={f(x)|x。A,h(x)=g(f(x)),则称h为映射f与g的合成。1.限制与扩张:设f:X→Y,A⊆X,当把f的定义域限制在A上时,就得到了一个j

要求在指定端口接收来自客户的HTTP请求并且根据其中的URL地址访问该地址所指向的HTTP服务器(原服务器),接收HTTP服务器的响应报文,并将响应报文转发给对应的客户进行浏览。要求能缓存原服务器响应的对象,并能够通过修改请求报文(添加头行),向原服务器确认缓存对象是否是最新版本。,支持如下功能:网站过滤:允许不允许访问某些网站;用户过滤:支持不支持某些用户访问外部网站;网站引导:将用户对某个网站

集合论知识总结

贝叶斯神经网络通过引入参数的概率分布来描述模型的不确定性。与传统的确定性神经网络不同,BNNs 通过学习参数的后验分布来对模型进行建模,从而在预测中提供。让xθ↦gθx定义的gX×Θ→Y作为神经网络(NN),其中gθx是由x和θ确定的函数。贝叶斯神经网络(BNNs)的主要假设是通过一个简单的分布来近似参数g的后验分布pθ∣D,该分布在参数空间Θ⊆RP上编码了不确定性。