简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

QAAnything(QAnything) 是一个本地知识库问答系统,旨在支持各种文件格式和数据库,允许离线安装和使用。用户只需将任何本地存储的任何格式的文件拖放到系统中,即可获得准确、快速和可靠的答案。PDF(pdf)Word(docx)PPT(pptx)Eml(eml)TXT(txt)XLS(xlsx)CSV(csv)图像(jpg,jpeg,png)网页链接(html)数据安全,支持在整个过程

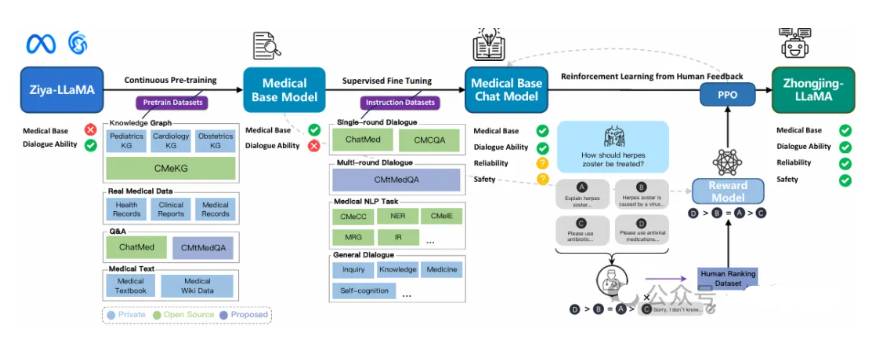

不愧是中了博后基金的佬团队的成果。与之前发过的TCMChat等相比,主要应用领域为中文医学而非中医药,但选取的基座模型LLaMA在中文NLP任务上的性能可能并非最优。发表日期:2023-08-07(AAAI 2024)摘要:大语言模型(LLM)的最新进展在理解和响应用户意图方面取得了显著突破。然而,在某些专业领域,如中文医学领域,它们的性能却落后于一般用例。将中文医学纳入 LLM 的现有努力依赖于

2025年11月Gemini 3的发布,与马斯克Grok 4 Fast的9月突袭,标志着大模型竞争进入"性能+速度+生态"的三维战争。Google用100万token上下文和72.1%事实准确性证明闭源模型的技术上限,xAI则以Grok 4的10倍速度提升和20万H100的暴力算力诠释"天下武功唯快不破"。这场竞赛的本质,已从单纯的参数军备赛,演变为"开源生态繁荣度×场景深度×硬件协同效率×响应速

PyTorch核心开发者教你使用 PyTorch 创建神经网络和深度学习系统的实用指南。这本书详细讲解整个深度学习管道的关键实践,包括 PyTorch张量API、用 Python 加载数据、监控训练以及对结果进行可视化。PyTorch核心知识+真实、完整的案例项目,快速提升读者动手能力。

虽然有人说DeepSeek摆脱了对GPU的依赖,导致英伟达的股价下跌,但这一说法并不准确。实际上,DeepSeek确实在一定程度上降低了对算力的依赖,但并非完全摆脱。从参数上看,R1总共有6710亿个参数,一次推理调用的参数只有370亿个,远低于GPT-4的1.76万亿个参数。而DeepSeek背后的投入也是巨大的,包括购买计算卡、搭建服务器等费用在内,总费用高达26亿美元。但即便如此,DeepS

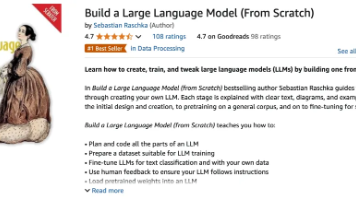

2025 年,人工智能依然是科技圈最热的风口。ChatGPT、Claude、DeepSeek 等模型层出不穷,不断刷新人们对 AI 能力的想象。而支撑这一切的,正是大语言模型(LLM)——这个曾经只是大厂的专属!但问题来了:构建一个属于自己的大模型,真的非得依赖大团队、大算力、大预算不可吗?其实未必!Build a Large Language Model (From Scratch) 这本书,正

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。这里给大家精心整理了一份全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

【声明】首先,这系列文章均基于自己的理解和实践,可能有什么不对的地方,欢迎大家指正。其次,这是一个入门系列,涉及的知识也仅限于够用,深入的知识网上也有许许多多的博文供大家学习了。最后,希望大家能够有所收获。前言新房的建造,首先肯定是从地基开始架构,那么我们该如何架构好呢,请看下一步。1、构造AudioRecord我们首先通过AudioRecord的构造器,来了解下需要的参数publicAudioR

做过三年framework,自身总结了一套学习方法,大致如下三点。勤加练习,一般性模块可以看的非常快。1、高度抽象,构建框架2、重要函数,深究细节3、善用工具,及时总结Android源码非常庞大,但设计很精妙。纵向分层,横向模块化,使得整个源码更易更新和维护。在手机厂商做framework的更倾向于说自己是做Android系统的,维护的模块主要包括ActivityManagerService、Wi

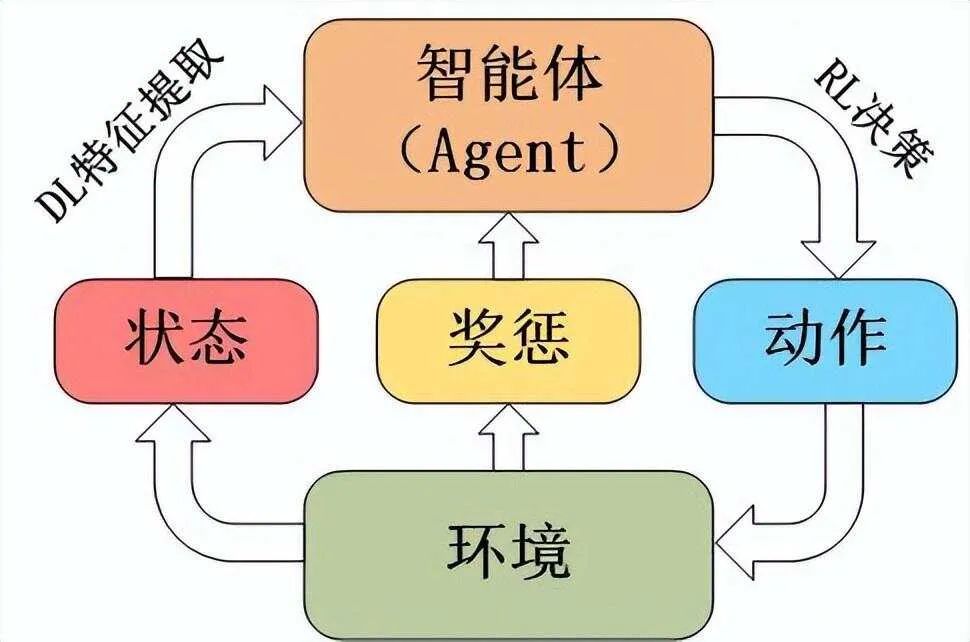

Q值函数,也称为动作价值函数(Action-Value Function),是一种特殊的价值函数,它估计了在给定状态下采取特定动作的预期回报。Q-Learning算法通过迭代更新Q值来逼近最优Q函数。算法流程包括初始化Q表、选择动作、执行动作、更新Q值等步骤。