简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这个阶段, 主要是带大家了解大模型的“前世今生”, 不用担心什么数学公式,咱就用大白话聊聊, 顺便上手操作一下。**学习目标:***• 搞懂大模型的基本概念,专业名词啥的都得略懂一二。*• 能用代码调通大模型接口就行,先别想着自己造轮子。*• 用最通俗易懂的方式,让你明白大模型到底是个啥。

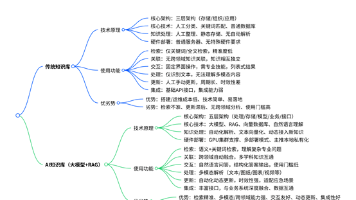

AI知识库与传统知识库的核心差异主要体现在技术原理、功能应用和优劣势三方面。技术层面,AI知识库采用大模型+RAG架构,具备语义理解、多模态处理能力;功能上支持自然语言交互、跨领域关联和动态更新;优势包括高精度检索和复杂问题解决能力,但部署成本较高。当前AI应用层人才缺口大,掌握RAG、Agent和微调技术将成为核心竞争力。建议开发者抓住AI技术转型机遇,通过系统学习实现职业跃迁。

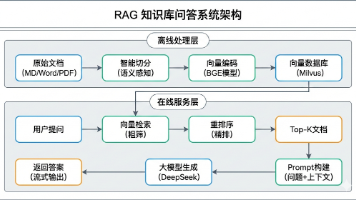

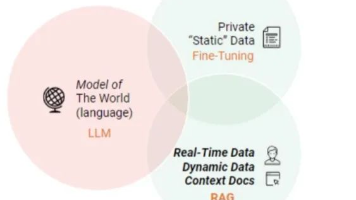

RAG(检索增强生成)技术通过三步解决大模型处理企业文档的局限性:文档切块(200-500字/块)、向量化存储、相似度检索。该方案突破模型上下文长度限制,支持知识实时更新,核心流程为:预处理阶段将文档分块并向量化存储;查询时检索相似片段作为上下文,与问题一并提交模型生成精准答案。技术实现涉及文本分割策略、Embedding API调用及向量数据库优化,可显著提升企业知识库问答系统的效果与时效性。当

本文系统分析了RAG技术在实际应用中的关键问题与优化策略。针对文档切分环节,作者提出基于语义结构的智能切分方法,通过保留标题层级和上下文路径,有效解决机械切分导致的语义断裂问题。在检索环节,采用两阶段检索机制(粗筛+精排)提升准确率。Prompt工程方面,设计包含上下文路径、检索评分等元信息的模板,显著改善大模型回答质量。文章还总结了上线后的运营经验,包括冷启动优化、文档更新同步等实践要点,为构建

本文介绍了如何利用Dify平台和ChatGPT构建小红书内容自动化生成工作流。该工作流通过7个步骤实现:1)收集用户输入的主题、背景和语气;2)生成吸引人的标题;3)创作正文内容;4)提取封面前言文字;5)调用imgrender.net生成封面图;6)处理封面图URL;7)整合输出最终内容。整个过程展示了如何结合大语言模型和外部API实现从文字到图片的一站式内容生产,大大提升了社交媒体运营效率。文

1.AI产品经理是什么回答这个问题前我们首先得理清楚什么是AI产品经理,它和传统的互联网产品经理有什么区别。1.1 AI产品经理职责主要职责一方面是规划如何将成熟的AI技术应用在各个领域不同场景中,提升原有场景的效率或效果等;

MIT团队提出GraphAgents框架,通过知识图谱引导的多智能体AI系统解决PFAS替代材料研发难题。该框架整合5个专业智能体,结合PFAS专用和通用材料知识图谱(共45万节点),采用4种图遍历算法实现跨域材料设计。实验表明,全组件系统在任务分解、创新性等6个维度全面领先单LLM基线,生成的设计方案兼具创新性和可验证性。这一突破为AI驱动的科学发现提供了可追溯、可验证的新范式,未来有望实现从数

RAG技术解析:提升大模型问答准确性的关键方案 摘要: 本文系统介绍了检索增强生成(RAG)技术,该方案通过结合检索与生成两大模块,有效解决了大语言模型(LLM)存在的幻觉、时效性和数据安全等问题。文章详细拆解了RAG的四大核心模块:版面分析、知识库构建、模型微调和知识问答,重点分析了文档解析、信息检索等关键技术实现。通过对比SFT方法,突出了RAG在可扩展性、准确性和安全性等方面的优势。最后提供

大模型在软件测试行业的应用已从概念验证走向规模化落地,成为提升测试效率与质量的关键技术。主要提效路径包括测试用例自动生成、智能缺陷预测、自动化脚本生成、测试结果分析和需求-测试追溯等。典型案例显示,天猫、中国邮政储蓄银行等企业通过大模型实现了40%-60%的效率提升。尽管存在幻觉、算力成本等挑战,大模型已成为测试行业的"最大变量"。未来趋势将向Agent化、多模态融合和垂直领域

笔者近期需要使用爬虫技术来爬取某网页上的数据,因此学习了一下Python爬虫技术,正好最近也在学习Javaweb和spring相关技术,借此过程巩固一下相关基础知识。