简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

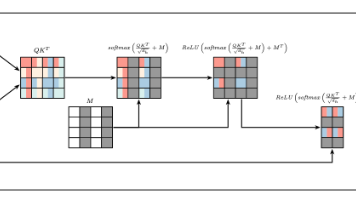

《Not Another Imputation Method: A Transformer-based Model for Missing Values in Tabular Datasets》

问题背景:表格数据中的缺失值问题创新点:特征专属的embedding处理缺失值方法改造的双重masked self-attention随机遮掩实验方法:在五个数据集上对比11个ML和5个DL模型应用三种imputation。

pytorch迁移学习+ResNet50实现猫十二分类

发现了一篇比较漂亮的resnet代码,借鉴,学习。

pytorch实现MNIST识别——全流程

主要实现1. 掌握pytorch自带数据集的导入2. 初步编写DataLoader3. 定义模型、损失和优化器4. 训练简单神经网络5. 将模型结果保存至本地

到底了