简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

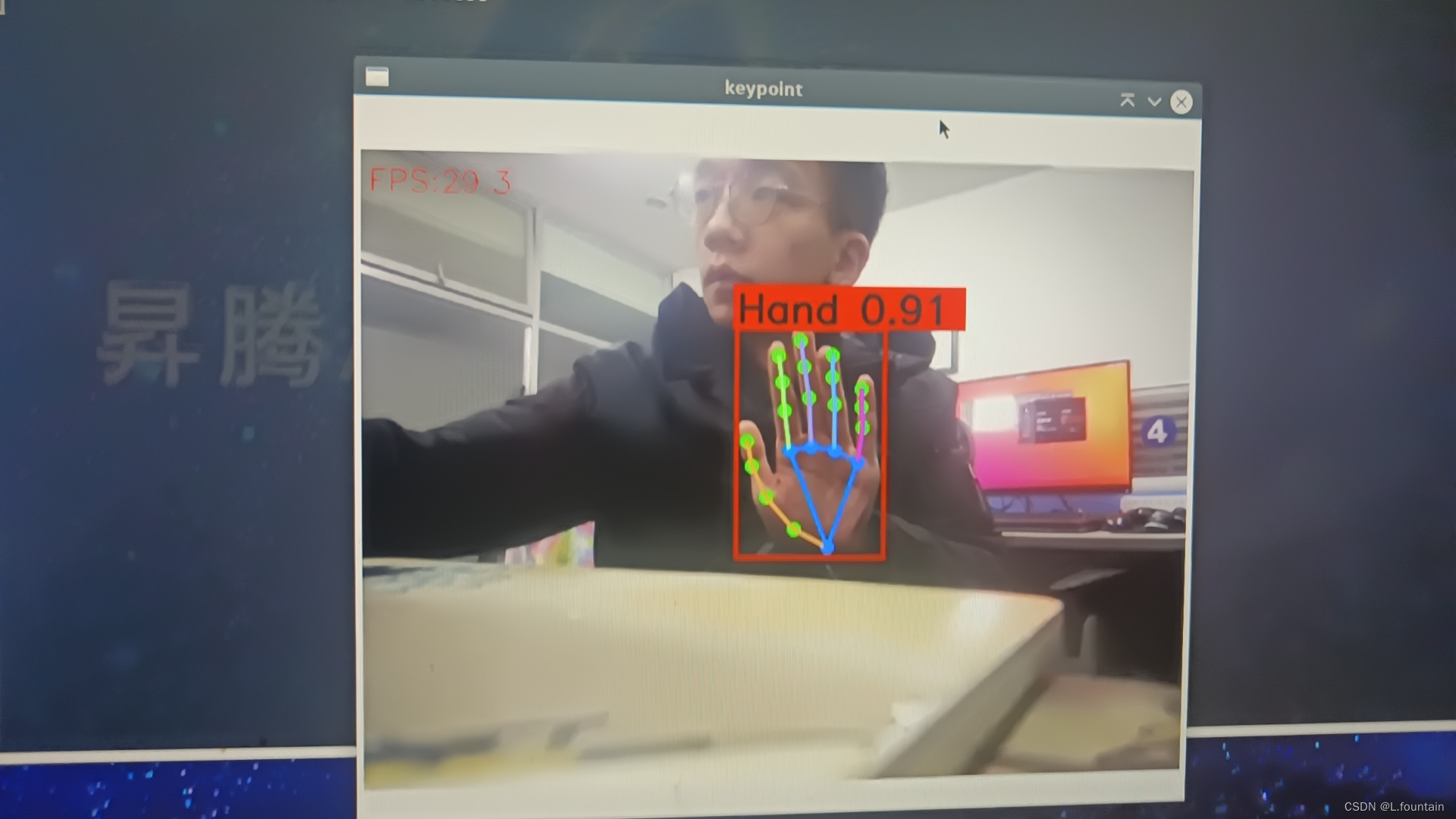

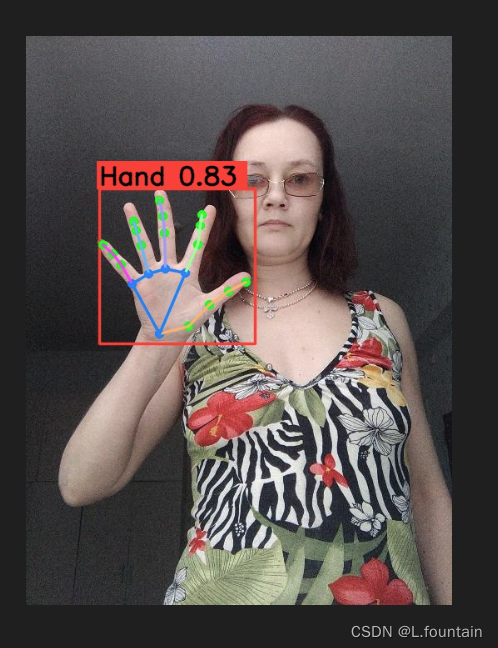

基于Atlas200 DK A2通过AIPP算子优化模型的预处理过程,使Yolov8n-pose模型在640*640 30fps的摄像头场景下达到了实时监测的水平。

本文在Atlas 200 DK A2上部署了Yolov8官方预训练的人体关键点检测模型,以及根据自制数据集训练的手部关键点检测模型,包含单张图片,摄像头视频帧,还有本地视频三种推理预测方式。

本文将动态外卖配送建模为马尔可夫决策过程,利用深度强化学习在有限骑手条件下联合优化实时派单、智能拒单与骑手重定位,实验表明该策略在合成与真实数据上均较基线显著提升期望总奖励、缩短平均送达时间,并给出不同订单频率下的最优骑手配置与鲁棒性验证。本文构建了一个融合拒单、多单合并与骑手重定位的 MDP 外卖模型,用八类 DQN 算法求解,在合成与真实数据上证明其可同时提升平台利润、缩短送达时间,并首次给出

这篇论文聚焦哥伦比亚外卖平台的“最后一公里”配送,提出基于 GRASP 的 MDRP 求解框架:动态整合骑手可用性、订单需求与地理位置,实现订单分配与路线优化。真实数据实验表明,GRASP 在解质量与计算速度间取得有利折中,较现有仿真优化方法在订单完成率和路径效率上均具竞争。

过去七年,外卖App把中国人的用餐方式彻底重写:早上睁开眼,68%的年轻人已把早餐交给手机下单,33%的人一周至少六次不与厨房照面。Meituan、饿了么这类平台把餐厅搬到线上,却把“最后三公里”的不确定留给了自己——它们不像麦当劳那样养一支全职骑手军团,而是让数百万众包骑手在时空缝隙里“快闪”接单。于是,午餐12:00-13:00与晚餐17:00-19:00的脉冲式订单洪峰一来,商圈瞬间“缺氧”

本文提出一种基于深度强化学习(DRL)的外卖即时配送优化策略PPO-IH,以应对高峰期运力紧张、延迟率高的问题。核心做法包括:建立考虑备餐时间、时间窗等约束的随机需求MDP模型,以最大化长期客户服务水平为目标;设计PPO-IH策略,结合PPO算法(融合注意力机制匹配订单-骑手)与插入启发式算法(优化骑手路径);实验表明,PPO-IH在多数场景中优于贪婪、最小差值等传统方法及两种DRL算法,显著提升

这是一篇综述类型的论文,系统梳理了在线外卖平台(ODP)实时配送运营中的各类问题,并对现有的运筹学模型进行分类。研究将ODP运营划分为“配送前”与“配送”两阶段,指出现有文献主要聚焦于后者(分单、路径、调度、发单)。建模方法以优化与机器学习并重,机器学习应用呈上升趋势;求解方法从传统算法/启发式转向问题专属的新颖方法;绩效指标体系亦日趋多元。综述统一术语、厘清研究脉络,为后续研究奠定基础。

本文介绍了截至2023年12月最新的华为Atlas200DK A2开发板合设开发环境的搭建方式。

基于外卖平台真实数据,这篇文章提出多目标 CNN-LSTM 深度网络,以单一模型逐小时、逐区域预测短期需求分布,显著优于历史均值和传统时序方法,为城市司机空间-时间调度提供精准决策支持。– 以“预测偏差>10/20/30 单”为阈值,CNN-LSTM 的高误差区域数量明显少于基线(例如 19 h 时段,>20 单误差区域减少一半)。• 区域级误差:在前 40 大需求区,CNN-LSTM 在多数区域