简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

总而言之,Fail2ban 和 SSH 密钥登录可以很好地协同工作。绝大多数“失效”情况都是由于IP在配置密钥前已被封禁或白名单未设置导致的。通过检查封禁列表并将可信IP加入白名单,问题通常都能迎刃而解。

您需要知道的说明它做什么它是一个自动触发器,将“标注完成”这个动作,转化为“开始训练”的指令。它不做什么它本身不执行训练。训练任务发生在您自己部署的、能够处理/train请求的机器学习后端服务器上。典型用途实现主动学习:模型先用少量数据训练,然后对大量未标注数据做预标注;人工只修正错误;修正后的数据立即触发模型再训练,如此循环,让模型在标注过程中快速变“聪明”。手动替代如果不开启此选项,您也可以通

Softmax 函数中的温度 T 和你在调整大模型行为时设置的温度 T,是同一个参数在不同上下文中的体现。它就像一个控制生成文本“性格”的旋钮,理解其原理能帮助你更有效地使用大模型。

LlamaFactory 是一个专为大模型(尤其 LLaMA 系)设计的「微调工具箱」,擅长以低显存、高效率、高灵活度的方式,帮你把预训练好的基础模型(如 LLaMA-3)或后训练模型(如 Chat 版)微调成你想要的“专家模型”。

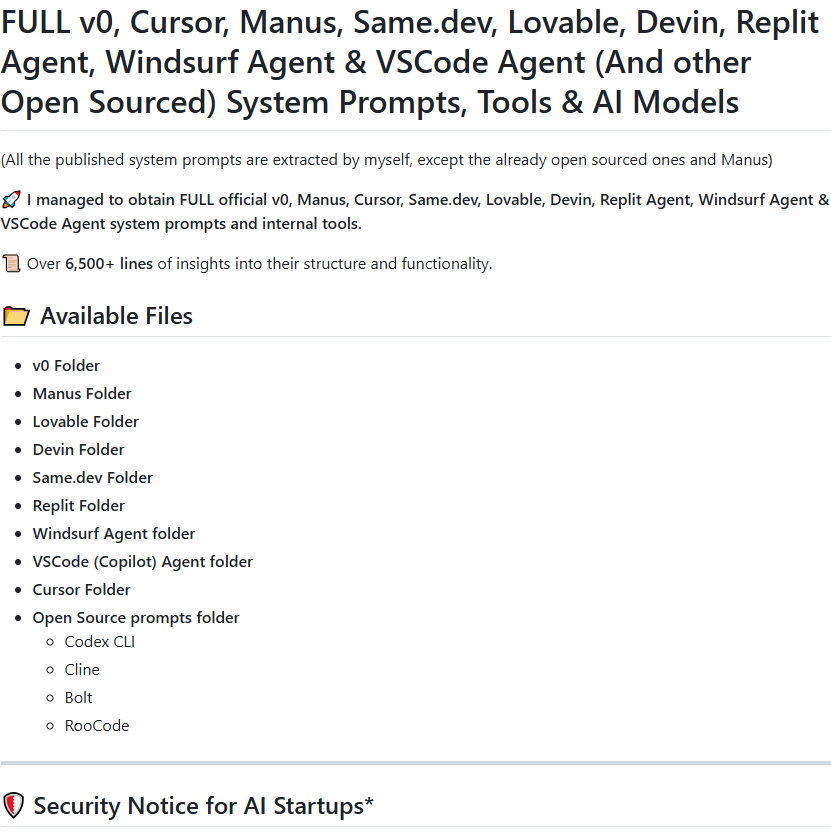

https://github.com/x1xhlol/system-prompts-and-models-of-ai-tools#

与训练时相同: 2 bytes per parameter。=== 5. MiniMind实际使用 ===训练时: bfloat16 (2 bytes)模型大小 = 参数量 × 数据类型大小。=== 参数量到模型大小计算 ====== 2. 数据类型大小 ====== 3. 学生模型计算 ====== 4. 教师模型计算 ===参数量: 123,100,000。=== 1. 基本公式 ===参数量

说明:docker部署后默认是支持远程访问的;

可以看到,这里访问的IP地址,是http://localhost:3001/onboarding;使用ollama gemma3模型,识别图片中的信息成功;

(企业级支持),规避实验性框架的生产风险。(灵活开源)或 。

• 下载最新版 VS Code(官网:https://code.visualstudio.com/)• 插件:远程环境下需单独安装插件(如 Python、Docker),插件将运行在服务器端。,指定远程程序路径和调试参数(支持 Python、C++ 等语言)。• 示例:远程调试 Python 脚本时,断点和变量监控与本地一致。• 安装 Remote - SSH 扩展(搜索并安装微软官方插件)打开集