简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在框回归问题中,高质量的 anchor 总是比低质量的 anchor 少很多,这也对训练过程有害无利。的增大,outliers 样本的梯度模值会被很大程度的抑制,高质量样本的梯度模值会降低,这并非期望的结果。为了让 EIoU Loss 更关注高质量样本,可以使用 EIoU loss 来代替上面公式中的 x。如图 4b 所示,Focal L1 Loss 可以提高 inliers 的梯度值,并根据。满

人工智能、机器学习、深度学习的关系1、 人工智能——机器推理利用计算机构建具有人类智力特征的复杂机器,即为通用人工智能或强人工智能,即让机器拥有人类的所有感觉、所有理智、像人类一样思考。要实现真正意义上的人工智能可能还有很长的路,但是在一些特定的领域,如图像识别、人脸识别、计算机视觉等方面已经实现了比人类更好的效果。这些被称为“狭义的人工智能”或“弱人工智能”。2、 机器学习—

GFLV2 非常轻量级,可以嵌入很多检测器中,提高约 2AP,带来的额外计算很少GFLV2 (Res2Net-101-DCN) 在 COCO 上获得了 53.3 AP通过可视化,可以看出在 NMS 过程中能起到很好的作用,能够更好的保留位置更准的框.........

One-stage 目标检测器基本上是将目标检测建模成了一个密集分类和定位的任务。分类任务一般使用 Focal Loss 来进行优化,定位任务一般是学习 Dirac delta 分布。如 FCOS 中就提出了一个估计定位质量的量:IoU score 或 centerness score,然后 NMS 排序的时候,将分类得分和框质量得分相乘。.........

一、数学期望、方差、协方差1、数学期望——反映随机变量平均取值的大小的统计量2、方差——度量随机变量与其数学期望之间的偏离程度或分散程度的统计量。数据越集中则方差越小,数据越分散则方差越大。3、协方差——衡量多维随机变量之间相关性的一种统计量方差是衡量一个变量与期望间的偏离程度,而协方差是衡量两个变量间的线性相关性,当X=Y时,协方差就等于方差。...

论文:Focal Loss for Dense Object Detection代码:https://github.com/facebookresearch/Detectron出处:原始论文出自 ICCV2017贡献:在当时的情况下,两阶段检测器处于统治地位,两阶段检测器是由两部分构成,第一阶段是 RPN 网络,进行候选框的生成,第二阶段输出检测结果。作者提出了一个问题:单阶段目标检测器能否达到类

第四章深层神经网络4.1 深度学习与深层神经网络4.1.1 线性模型的局限性4.1.2 激活函数实现非线性化4.1.3 多层网络解决异或问题4.2 损失函数4.2.1 经典损失函数1. 交叉熵(给定两个概率分布ppp和qqq)2. 均方误差(MSE,Mean Squared Error)4.2.2 自定义损失函数4.3 神经网络优化算法4.4 神经网络的进一...

一、写作建议顺序及注意事项1、提炼motivationMotivation是重中之重,intro和abstract都基于此最重要的Motivation往往只有一点即可,全文都围绕着一个最尖锐的问题,然后motivation就是基于该最尖锐的问题衍生而来2、题目关键字提炼题目关键字非常重要,题目的关键字也就是全文的关键字,abstract和intro等都会基于该关键字来展开描述3、写abstract

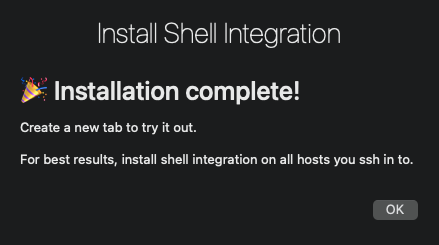

本文主要介绍如何使用 iterm2 来直接查看图片

作者认为,独立的给每个 gt 分配 pos/neg 不是最优的方法,缺失了上下文信息,当处理那些模棱两可的 anchor 时(如图 1 中的红色点,一个点处于多个 gt 中),上面的方法是靠手工的特征来选定属于哪个 gt 的(如 max-IoU、min-Area 等)在目标检测的上下文中,假设有 m 个 gt,n 个 anchor,把 gt 看做 positive labels 的供货商,供应 l