简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

【AI学习】快速了解YOLO模型的发展

小模型发展的核心逻辑:垂直场景的深度优化、计算效率的持续压榨、以及端侧部署的工程化创新

【AI学习】华为AgenticRAN架构调研

AgenticRAN是华为自智网络架构的最新演进阶段,经历了三个重要里程碑

【AI学习】几分钟了解一下Clawdbot

Clawdbot 代表了一种激进的去中心化 AI 路线——数据所有权归还用户、模型可插拔、能力可扩展。这与当前大厂主导的封闭生态形成鲜明对比。即使 Clawdbot itself 未能大众化,它提出的"Local-First Agent"理念也将深刻影响下一代 AI 产品设计。

【AI学习】TM Forum自智网络L4级标准体系

TM Forum通过IG1339(场景定义)、IG1251(架构标准)、IG150x(实施指南)、IG1256(价值量化)形成了完整的L4级自智网络标准体系。

【AI学习】TM Forum《Autonomous Networks Implementation Guide》快速理解

2025年6月,TM Forum联合75家全球领先的产业伙伴,共同发布了具有里程碑意义的自智网络白皮书7.0,定义了以自智网络智能体(AN Agent)为核心的自智网络Agentic功能架构和智能体架构,推动智能体、数字孪生技术与通信网络深度融。

【AI学习】李广密与阶跃星辰首席科学家张祥雨对谈:多模态发展的历史和未来

非常赞叹的一篇文章,说清楚了NLP、CV发展中的许多重大问题,读来醍醐灌顶!这样的文章,至少需要读三遍!

【AI学习】AI大模型技术发展研究月报的生成提示词

AI大模型技术发展研究月报生成提示词,以及在三个平台的使用效果

【AI工具】用大模型生成脑图初试

试用了一下通过大模型生成脑图,非常简单

【AI学习】大模型量化实践

按照教程尝试进行模型量化,将InternLM2-Chat-7B 模型进行4、8bit量化。很费劲,记录一下过程。

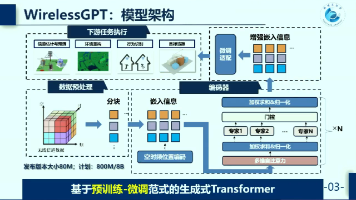

【AI学习】wirelessGPT多任务无线基础模型摘要

收看了关于WirelessGPT多任务无线基础模型的演讲视频,应该说,在无线通信大模型的探索方面,有一个非常有益的尝试。