简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在深度神经网络中,计算效率对于目标检测至关重要,尤其是在新模型更注重速度而非有效计算(FLOP)的情况下。这一演变某种程度上忽视了嵌入式和面向移动端设备的AI目标检测应用。在本文中,作者重点关注基于FLOP的高效目标检测计算的神经网络架构设计选择,并提出几项优化措施来提高基于YOLO模型的效率。1、首先,作者引入了一种受倒置瓶颈(inverted bottlenecks)和来自信息瓶颈(the I

A3C(异步优势演员评论家)算法,设计该算法的目的是找到能够可靠的训练深度神经网络,且不需要大量资源的RL算法。在DQN算法中,为了方便收敛使用了经验回放的技巧。A3C更进一步,并克服了一些经验回放的问题。如,回放池经验数据相关性太强,用于训练的时候效果很可能不佳。举个例子,我们学习下棋,总是和同一个人下,期望能提高棋艺。这当然是可行的,但是到一定程度就再难提高了,此时最好的方法是另寻高手切磋。

先讲下在线离线和同策略和异策略同策略()和异策略()的根本区别在于生成样本的策略和参数更新时的策略是否相同。对于同策略,行为策略和要优化的策略是同一策略,更新了策略后,就用该策略的最新版本对数据进行采样;对于异策略,其使用任意行为策略来对数据进行采样,并利用其更新目标策略。例如,Q学习在计算下一状态的预期奖励时使用了最大化操作,直接选择最优动作,而当前策略并不一定能选择到最优的动作,因此这里生成样

为了方便将img_scale设置为[(224,224)],此时的数据集中的图片会进行resize,并且将短边padding成32的倍数,按最长边与224的比例缩放最短边,即 x=短边 / (500/224),x即为缩放后的实际长度,比如输入时500*287(w*h)的图片,缩放后的短边长为287 * 224 / 500 = 129,由于输入的图像尺寸需要是32的倍数,此时需要向上取整,所以padd

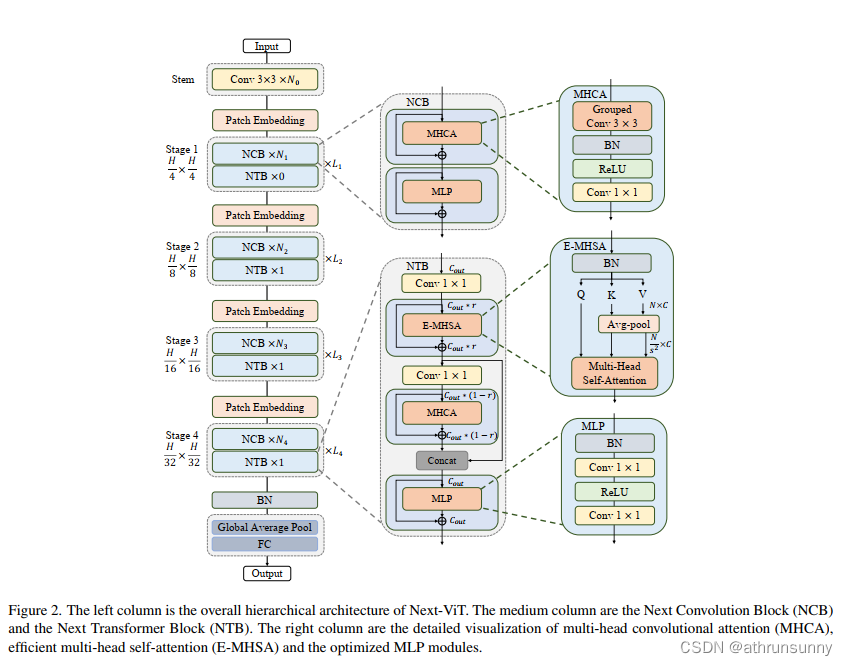

由于复杂的注意力机制和模型设计,大多数现有的ViTs在现实的工业部署场景中不能像CNNs那样高效地执行,例如TensorRT和CoreML。这带来了一个明显的挑战:视觉神经网络能否设计为与CNN一样快的推理和与ViT一样强大的性能?最近很多工作试图设计CNN-Transformer混合架构来解决这个问题,但这些工作的整体性能远不能令人满意。......

如果在python的类中定义了__next__()和__iter__()方法,生成的实例对象可以通过遍历来取class Test:def __init__(self, num, flower):self.num = numself.flower = flowerself.dict = dict()self.getDict()def getDict(self):for n, f in zip(

有些视频资源下载下来之后发现是.ts的文件,除了用下载它时用的工具或是浏览器才能看,那有没有将ts文件转换成更加通用视频格式的方法。如果是windows系统,可以新建一个.bat的批处理文件,并将如下代码写入。大多时候ts文件并不是单个存在的,这里就需要将其合并之后再转换成mp4。的形式保存在file_paths.txt中。几乎万能的音视频工具--ffmpeg登场。1、对于单个.ts文件,将其转换

在自己的项目中,常常会遇到数据集少的情况,但是网上有些标注好的数据,或多或少和自己的项目的标注要求有差别,又不想重新标注,只想微调一下,但是yolov5的原生格式修改起来不直观,这时候可以将yolov5格式的数据转成labelme的json格式,这样就方便对数据的标注进行微调,同时也不用花大心思去标注大数据,减少人工成本。转换的数据会根据train或valid生成在createjson文件夹下,之

最近遇到了跨语言的进行数据交互的问题,就是通过python客户端向c的服务端传输c的嵌套结构体。C的服务端:#define _WINSOCK_DEPRECATED_NO_WARNINGS#include <WinSock2.h>#include <iostream>using namespace std;#pragma comment(lib, "ws2_32.lib")#

文件夹中创建三个文件(predict,test,train_landmark),类似yolov5的分类和语义分割任务。最后在utils中增加facedataloaders.py用于数据集的读取。克隆下最新的yolov5,在根目录下创建landmark文件夹。utils/plots.py还有个函数需要修改。添加完以上三个文件后需要对源码进行一些修改。同时在以下两个函数中增加LmkDetect。1、D