简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

总结一下就是为跳板机创建隧道,为服务器创建代理,隧道和代理的端口要一致.前提假设:跳板机 主机地址为:A待登录服务器 主机地址为:Bstep 1、新建跳板机A会话1)连接名称:任意取(如:跳板机)主机:填写跳板机IP或跳板机服务器名称2)用户身份验证填写跳板机A的用户名和密码3)ssh-隧道建立类型:Dynamic(SOCKS4/5)侦听端口:可以自己设置,但必须与待连接服务器的配置一致,如此处假

VS Code的Error: Running the contributed command: '_workbench.downloadResource' failed解决1 问题描述2 解决方案1 问题描述此前,本人参考网上教程在VS Code中配置了“Remote SSH”插件(比如这个教程),本人是在Windows中使用VS Code来连接远程的Linux服务器。但是今天使用遇到了问题Err

用PyTorch加载已经保存好的模型参数文件时遇到一个bug:Unexpected key(s) in state_dict: “module.features. …”.,Expected “.features…”意思是从本地文件中加载模型的state_dict时,state_dict的key值不匹配。查了一些资料后,发现是PyTorch多gpu保存的问题,导致保存下来的state_dict中的k

内容参考:Tensorflow四种交叉熵函数计算公式:tf.nn.cross_entropyTensorFlow四种Cross Entropy算法实现和应用交叉熵(Cross Entropy)交叉熵(Cross Entropy)是Loss函数的一种(也称为损失函数或代价函数),用于描述模型预测值与真实值的差距大小,常见的Loss函数就是均方平方差(Mean Squared Error),定义如下。

问题描述:最近因为课题需要使用allennlp包,self.cp = Predictor.from_path("https://storage.googleapis.com/allennlp-public-models/elmo-constituency-parser-2020.02.10.tar.gz", cuda_device=self.device) 结果出现报错allennlp.commo

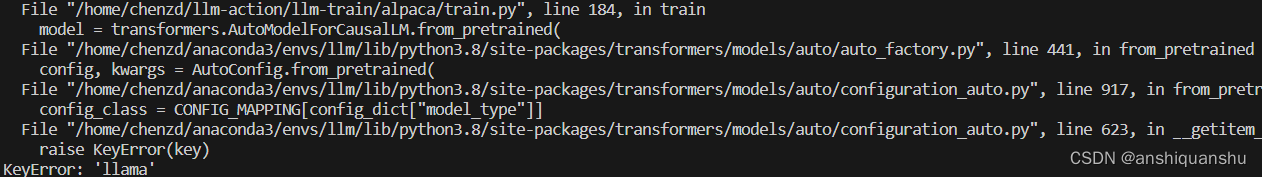

运行LLaMA-7b模型有时候会报错“configuration_auto.py in getitem raise。

#!/usr/bin/env python3import torch.nn as nnimport torch.nn.functionalimport numpy as npi#此案例来源于:https://pytorch.org/docs/master/nn.html#torch.nn.LSTMrnn = nn.LSTM(input_size=10,hidden_size=20,num_laye

1 背景前面一篇文章 NLP预训练模型2 – BERT详解和源码分析 中,我们从模型结构、实现源码、实验结果等角度,分析了预训练语言中大名鼎鼎的BERT模型。BERT大幅刷新的GLUE得分,提高了7.7个点之多,甚至有些中文NLP任务上达到了人类水平。那是不是在预训练模型方面就没法进行其他创新了呢,答案显然是否定的。前文中我们也提到了BERT存在的很多缺点,从预训练任务、模型结构、语料数据、模型轻

一、导入 在用python进行科学运算时,常常需要把一个稀疏的np.array压缩,这时候就用到scipy库中的sparse.csr_matrix函数和sparse.csc_matric函数。 其中csr_matrix:Compressed SparseRowmarix,而csc_matric:Compressed SparseColumnmarix。二、引例这里先放上一个官网的经典例子:fr

用google-research官方的bert源码(tensorflow版本)对新的法律语料进行微调,迭代次数为100000次,每隔1000次保存一下模型,得到的结果如下:将最后三个文件取出,改名为bert_model.ckpt.data-00000-of-00001、bert_model.ckpt.index、bert_model.ckpt.meta加上之前微调使用过的config.json以及