简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Milvus | 高性能向量数据库,为规模而构建Milvus 是一个为 GenAI 应用构建的开源向量数据库。使用 pip 安装,执行高速搜索,并扩展到数十亿个向量。

Cherry Studio AI 是一款强大的多模型 AI 助手,支持 iOS、macOS 和 Windows 平台。快速切换多个先进的 LLM 模型,提升工作学习效率。Cherry Studio - 全能的AI助手。cherry Studio官网。

使用阿里巴巴开源的ai框架,访问本地部署的大模型,本次采用llama3.2:1b的模型。修改配置文件,把Ollama的服务的API和端口设置,还有模型名称,启动即可。打开IDEA,下载好阿里的工程,我用的 ollama-chat-model。启动本地大模型,本文采用Ollama启动大模型。浏览器访问项目工程的URL,

Dify 是一个开源项目,可通过 GitHub 克隆仓库(https://github.com/langgenius/dify.git)进行部署。安装步骤包括进入目录、复制环境文件并使用 Docker Compose 启动服务。启动后会创建多个容器,包括 Web、数据库、Redis 等组件。成功运行后,可通过浏览器访问。整个过程简单快捷,适合快速搭建 AI 应用开发环境。

摘要:通过本地部署open-webUI连接Ollama服务,并接入Cloud云端大模型(如deepseek-v3.1),实现了快速响应微积分等复杂问题的能力。用户注册后可在本地环境直接调用云端模型资源,同时本地部署的dify平台也能实现相同连接。该方案兼顾了本地隐私性和云端算力优势,为开发者提供了灵活的大模型调用方式。(98字)

Open WebUI镜像可通过加速地址快速下载:https://docker.aityp.com/r/ghcr.io/open-webui/open-webui。官方部署教程详见Open WebUI官网文档:https://docs.openwebui.com/,提供从镜像拉取到应用部署的完整指南。该镜像托管在GitHub容器注册表,使用国内镜像加速服务可显著提升下载速度。用户只需按照官方文档步骤

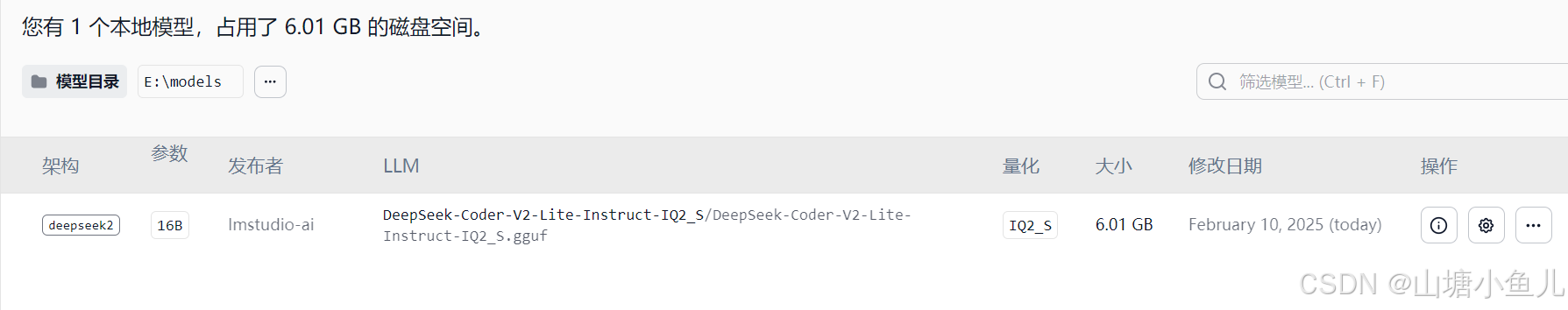

LM Studio 建立一个文件夹作为,模型目录,但是开始总也不显示下载的模型,后来才知道需要包两层文件夹的目录才行。如我下的是这个模型:DeepSeek-Coder-V2-Lite-Instruct-IQ2_S.gguf。这样再选择lmstudio-ai的上一层文件夹,作为模型目录就可以在LM Studio中显示了。直接讲重点,首先去官网下载.gguf的文件,下载后保存到一个目录里面。第二层目录

python爬虫框架:Scrapyd,Feapder,Gerapy。scrapy/scrapyd Git库。feapder Git 库。

配置openresty-1.21.4.1-win64.zip解压后的目录地址。1.openresty-1.21.4.1-win64.zip包的下载。3.编写build.xml,主要是配置项目路径和nginx路径。ant文件配置,选择项目中的build.xml,需要jdk环境。nginx服务就配置到Idea运行环境中去了。my.conf中配置hello.lua文件路径。nginx.conf中配置my

资源地址:https://download.csdn.net/download/airyearth/13182988本文只是做了一个小小的demo,针对于Mybatis插件的