简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

上传动作参考视频与目标图像,调整frame_num(帧数)与sample_guide_scale(动作强度),生成动态一致的新视频。划定编辑区域,调整参数--sample_shift(噪声调度)与guide_scale(提示词权重),生成局部修改后的连贯视频。,模型通过捕捉源动作的时空特征,结合目标主体的外观一致性约束(如RefAdapter模块),实现自然迁移。,通过时空压缩与长时程依赖建模,实

OneThingAI算力云平台推出两大重磅更新:1)全新子账号管理功能,主账号可创建子账号并精准分配权限,提升团队协作效率与安全性;2)模型广场新增多款前沿AI模型,包括大语言模型通义千问3系列(支持119种语言)和图片模型通义万相系列(文生图/图生文能力),满足多样化AI应用需求。这些升级将显著提升用户在团队协作、语言处理、创意设计等方面的工作效率。

DeepSeek 热度持续,大家都在探索DeepSeek的使用场景,拓宽它的使用边界。在一些数据安全敏感的场景私有化部署是企业落地LLM的重要选项。本文将详细的讨论如何才能高性价比的完成DeepSeek的私有化部署,下面将以两个章节来讨论这个问题:第一章节定义一些大模型服务的性能指标,第二个章节评估私有化部署大模型的成本情况。

字节跳动Seed团队开源大模型Seed-OSS-36B,具备长文本、推理和智能体能力。该360亿参数模型支持512K上下文,采用GQA注意力机制,在MMLU、GSM8K等基准测试中表现优异。特色功能包括可调节思维预算控制,用户能根据任务复杂度调整推理长度。模型以Apache-2.0许可证开放商用,并提供含/不含合成指令数据的两个版本。Seed-OSS-36B在知识、数学、编程等任务上表现突出,如M

字节跳动Seed团队开源大模型Seed-OSS-36B,具备长文本、推理和智能体能力。该360亿参数模型支持512K上下文,采用GQA注意力机制,在MMLU、GSM8K等基准测试中表现优异。特色功能包括可调节思维预算控制,用户能根据任务复杂度调整推理长度。模型以Apache-2.0许可证开放商用,并提供含/不含合成指令数据的两个版本。Seed-OSS-36B在知识、数学、编程等任务上表现突出,如M

摘要:DeepSeek团队低调发布V3.1大模型,延续其一贯"夜间突袭"风格。该版本主要升级包括:上下文窗口从128K扩展至100万token、增强复杂推理与多语言处理能力、优化工具调用格式(更简洁的函数参数传递方式),并引入可切换的思维模式。技术架构保持671B总参数规模,采用稀疏MoE与MLA注意力机制。测试显示其物理理解和代码能力有所提升,通过"思考-搜索-工具

上传动作参考视频与目标图像,调整frame_num(帧数)与sample_guide_scale(动作强度),生成动态一致的新视频。划定编辑区域,调整参数--sample_shift(噪声调度)与guide_scale(提示词权重),生成局部修改后的连贯视频。,模型通过捕捉源动作的时空特征,结合目标主体的外观一致性约束(如RefAdapter模块),实现自然迁移。,通过时空压缩与长时程依赖建模,实

DeepSeek 热度持续,大家都在探索DeepSeek的使用场景,拓宽它的使用边界。在一些数据安全敏感的场景私有化部署是企业落地LLM的重要选项。本文将详细的讨论如何才能高性价比的完成DeepSeek的私有化部署,下面将以两个章节来讨论这个问题:第一章节定义一些大模型服务的性能指标,第二个章节评估私有化部署大模型的成本情况。

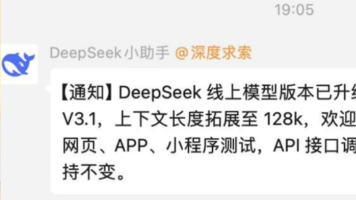

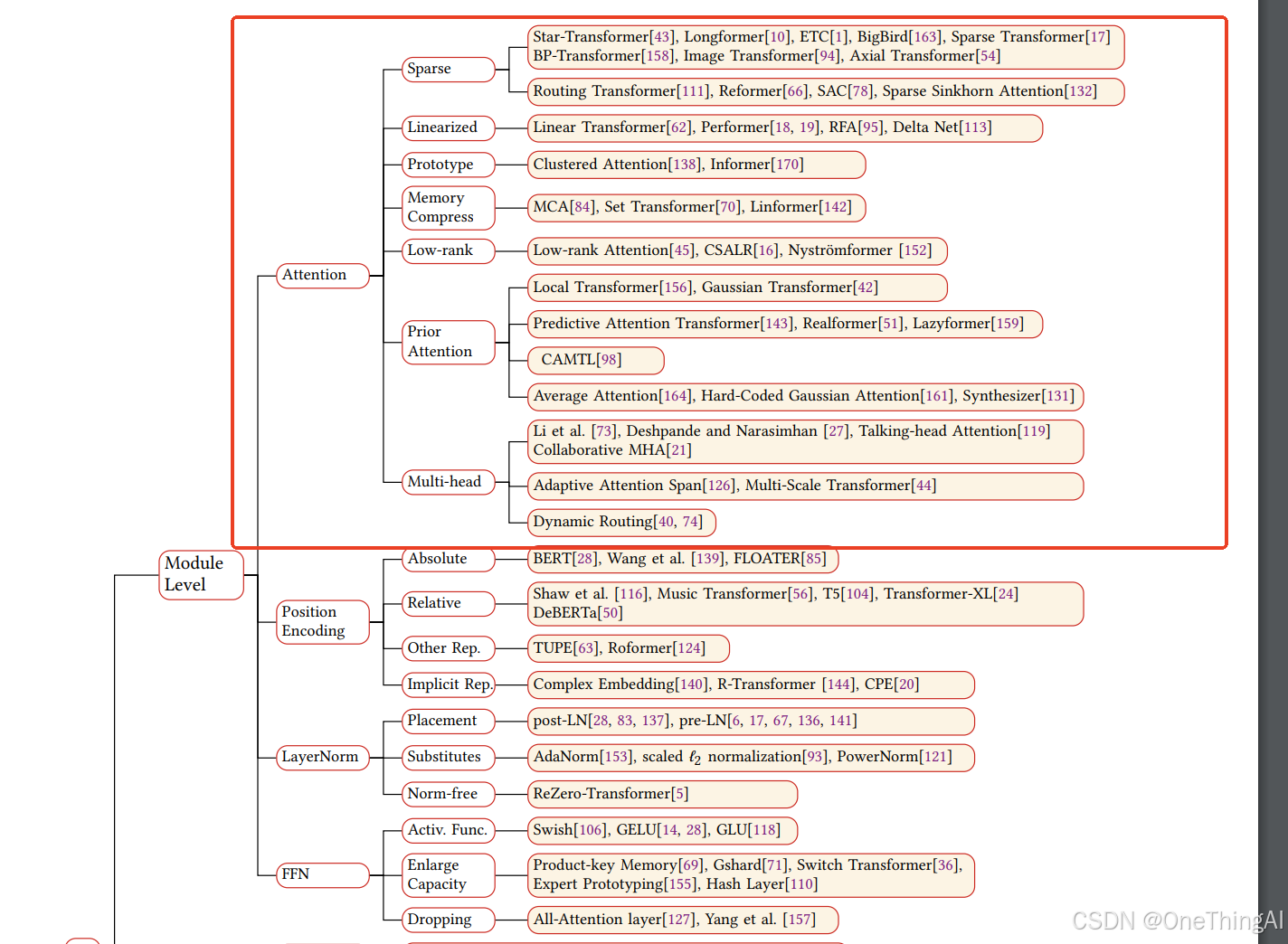

从第二章节不难看出(Decoder-only的attention计算和上面略有不同,不影响计算复杂度讨论),如果不做任何优化,生成每一个token的计算复杂度是O(n^2),最终生成的序列全局计算复杂度是O(n^3)。对于上下文这个计算复杂度肯定是无法接受的。1,所以,直觉上提升Attention的性能的做法是降低它的计算复杂度.kv caching就是为了解决这个问题将单个token的计算复杂度

DeepSeek 热度持续,大家都在探索DeepSeek的使用场景,拓宽它的使用边界。在一些数据安全敏感的场景私有化部署是企业落地LLM的重要选项。本文将详细的讨论如何才能高性价比的完成DeepSeek的私有化部署,下面将以两个章节来讨论这个问题:第一章节定义一些大模型服务的性能指标,第二个章节评估私有化部署大模型的成本情况。