简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

让 AI 基于你的文档准确回答问题,告别“一本正经地胡说八道”。

本文讲述了一个线上事故案例:在发布新版本时,由于未考虑老用户数据的兼容性而导致应用崩溃,从事故发生到解决问题的整个过程。

文章讲述了AI工程师小禾在解决LLM服务显存泄漏问题的过程。凌晨3点因GPU显存溢出导致服务崩溃后,小禾发现三个关键问题:未释放的张量、累积的中间变量和不受控的并发请求。他通过三道防线解决:1) 用信号量限制并发请求数;2) 增加显存余量检查,拒绝超负荷请求;3) 在每次生成后强制垃圾回收并清理PyTorch显存缓存。这些措施有效预防了显存泄漏,保障了服务稳定性。

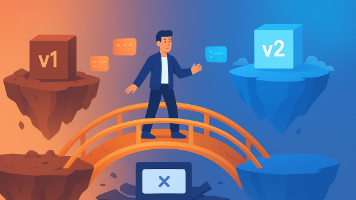

本文讲述了被迫更换4个不同LLM模型的痛苦经历,从GPT-5.1、Gemini 3.0到本地Qwen和Claude,每次更换都需重写47处业务代码。通过分析问题根源——业务代码与LLM实现强耦合,文章提出了适配器模式的解决方案:建立统一的LLM抽象层,定义标准消息格式和生成接口,使业务代码仅依赖抽象接口。以OpenAI适配器为例展示了具体实现,将各平台差异封装在适配器中,实现模型切换时业务代码无需

本文介绍如何利用小智音箱的MCP协议实现智能家居自动化控制,重点解决到家前10分钟自动开空调的实用场景。

本文通过程序员小刘的故事,生动讲解了适配器模式的应用场景和实现方法。面对OpenAI、Ollama和NVIDIANIM三种大模型API调用方式不一致的问题,小刘采用适配器模式定义了统一接口ModelAdapter,并为每个模型创建对应的适配器类,将不同API封装成一致的调用方式。结合工厂模式,只需修改配置文件即可切换不同模型,彻底解决了if-else泛滥的问题。文章还强调了错误处理、日志记录和测试

30 分钟内搭建一个完全私有化的 AI 对话平台,数据不出服务器,成本为零。

从零部署,不写代码也能让机器替你 007

本文通过一个故事介绍了一个专用于 AI 的 JSON 容错解析器的完整实现。

本文介绍如何利用小智音箱的MCP协议实现智能家居自动化控制,重点解决到家前10分钟自动开空调的实用场景。